Inleiding: op naar 7nm

Het lijkt erop dat 2018 definitief het jaar is waarin de beroemde Wet van Moore ter ziele is gegaan. Zo heeft Intel, gezien zijn relatie met Moore, lang aan de wet vastgehouden, maar eindelijk toegegeven dat het grote moeite heeft om de stap naar 10nm te maken. Hoe moeilijk die stap is, bleek uit het uitbrengen van de i3-8121u-processor. Dat is tot dusver de enige 10nm-processor die Intel produceerde. Hij is slechts in een enkele Lenovo IdeaPad en Intels eigen NUC ingebouwd geweest, verder nergens. Die processor is vooralsnog het enige model in de Cannon Lake-serie geweest en zal vermoedelijk het enige blijven.

Ook ARM, toch geen onbekende op het gebied van processorontwerp, heeft aangegeven dat de vijftig jaar oude wet inmiddels zijn beste tijd heeft gehad. Het bedrijf zegt daar overigens niet rouwig om te zijn, want er zijn nog andere manieren om krachtigere chips te maken volgens de ARM-cto. Hoewel het bedrijf zelf geen chips produceert, ontwerpt ARM ze wel en daarbij speelt de technologienode uiteraard een voorname rol.

Toch zijn er ook bedrijven die nog wel vrolijk doorgaan met scaling, of het kleiner maken van transistors. Zo is TSMC, leverancier van onder meer AMD, Nvidia en Apple, klaar voor de productie van 7nm-chips en staan 5nm en zelfs 3nm op de rol. Nu is de 7nm-node van TSMC niet vergelijkbaar met de nodes van andere fabrikanten. Zo is bijvoorbeeld Intels 10nm-node vergelijkbaar met TSMC's 7nm-node.

In dit achtergrondverhaal kijken we kort terug op de ontwikkelingen van de processormarkt van het afgelopen jaar en kijken we vooral vooruit naar 2019. Wat kunnen we verwachten op processorgebied, hoe gaan fabrikanten om met de uitdagingen die steeds geavanceerdere ontwerpen met zich meebrengen, en wat zit er straks in jouw computer?

/i/1304670448.jpeg?f=imagenormal)

AMD in 2018

Als we alfabetisch het rijtje processorfabrikanten langsgaan, moeten we bij AMD beginnen. Na de introductie van de Zen-core in 2017 timmerde AMD vrolijk verder aan zijn modulaire ontwerp, waarmee het modules aan elkaar kan knopen. Zoals bekend worden Ryzen-processors opgebouwd uit één Zeppelin-module, die maximaal acht Zen-cores bevat. Die Zen-cores zijn in twee core-complexes ondergebracht, die via AMD's nieuw ontwikkelde interconnect, Infinity Fabric, met elkaar communiceren. Voor de Threadripper-processors uit de X-serie worden twee van die Zeppelin-modules aan elkaar geknoopt en communiceren ze nog steeds via Infinity Fabric. In de Epyc-serverprocessors en de WX-serie Threadrippers zijn vier Zeppelin-modules actief. Bij de apu's, zoals de 2200G en 2400G, is een core-complex vervangen door een Vega-gpu, maar de communicatie verloopt ook dan via Infinity Fabric.

De Zen-cores werden op 14nm geïntroduceerd in 2017, maar de 2018-generatie, die zich onderscheidt met aanduiding 2xxx in plaats van 1xxx voor de processors, werd op 12nm geproduceerd. Dat is vooral een marketingnaam, want feitelijk is er geen scalingverschil tussen de 14nm-transistors en de 12nm-variant. Wel heeft GlobalFoundries, die beide varianten maakt, het 14nm-procedé verbeterd met zijn 12LP-procedé. Zo kreeg de tweede generatie Zen-cores hogere kloksnelheden en een lagere werkspanning, en noemt AMD de cores Zen+.

Begin dit jaar begon AMD zijn offensief met de in februari geïntroduceerde Raven Ridge-apu's. Daarin combineerde het niet twee Zeppelin-modules, maar een Zeppelin-module en een Vega-gpu. Daarmee had AMD de krachtigste apu's in handen waarmee je casual games zonder aparte videokaart kunt spelen. Gecombineerd met een vrij goedkoop A4-moederbord kun je daarmee op een klein budget een eenvoudig gamesysteem bouwen.

In april volgde het grote geschut, met de tweede generatie Ryzen 3-, 5- en 7-processors, die op het eerder genoemde 12LP-procedé worden gemaakt. Van de Ryzen 2-processors werden ook weer Pro-varianten gemaakt voor de zakelijke markt. Bovendien levert AMD zijn processors compleet met capabele koeler en is het platform nog altijd gebaseerd op de AM4-socket, zodat ook oudere moederborden van de eerste Ryzen-generatie voor de nieuwe processors kunnen worden gebruikt.

/i/2002162173.jpeg?f=imagenormal)

Het grove geschut volgde in de nazomer en herfst met de tweede generatie Threadripper-processors. Daarmee heeft AMD het maximale aantal cores uitgebreid van 16 naar 32. Waar bij de eerste generatie Threadrippers twee van de vier stukjes silicium, de dies, geactiveerd waren, zijn bij de WX-serie Threadrippers, met maximaal 32 cores dus, alle vier de dies actief. Daarmee voorkomt AMD de productieproblemen van grote chips en kan het relatief compacte dies met hoge yields maken.

Intels 2018

In het blauwe kamp, bij Intel, hebben we in 2018 eveneens een flink aantal productintroducties gezien. Daar zaten ten minste twee buitenbeentjes tussen, die niet in het standaardrijtje van Coffee Lake Refresh-processors horen.

Een van de opvallendste introducties was namelijk die van de Kaby Lake G-processors. Dat is een serie laptopprocessors die een Intel-quadcore uit, zoals de naam aangeeft, de Kaby Lake-generatie combineert met een Vega-gpu van AMD. Intel heeft voor de communicatie tussen gpu en hmb2-geheugen zijn emib-technologie ingezet, die in 2017 door het bedrijf werd geïntroduceerd. Met die silicon interposer-techniek kunnen verschillende kleine chiponderdelen met elkaar worden verbonden. De combinatie Kaby Lake-cpu en Vega-gpu heeft tot dusver geen navolging gekregen en de vijf aangekondigde modellen zijn nauwelijks in producten terug te vinden. Jammer, want de prestaties, zeker die van de Vega-gpu, waren stukken beter dan wat Intels eigen igpu presteerde en vergelijkbaar met de prestaties van een losse GTX 1050 van Nvidia.

/i/2001759621.jpeg?f=imagenormal)

Ook een 'one off' is Intels Core i7-8086K. Dat is een processor die in beperkte oplage werd geproduceerd en die, zoals de naam aanduidt, de veertigste verjaardag van de 8086-processor herdenkt. Stiekem is de i7-8086K een extreem goede i7-8700K, die fabriekshalve door Intel wordt overgeklokt tot een turbofrequentie van 5GHz.

Een andere vreemde eend in de bijt is de i3-8121U, die in mei werd geïntroduceerd. Dat lijkt een simpele dualcore, maar het is stiekem Intels enige 10nm-chip met codenaam Cannon Lake. Inmiddels lijkt het erop dat het ook de enige Cannon Lake-chip zal blijven, want hoewel Intel uiteraard nog steeds de overstap naar 10nm wil maken, lijkt dat met een nieuwe architectuur te gaan gebeuren. Ter illustratie van de problemen met de huidige architectuur heeft Intel de igpu van de Cannon Lake-processor uitgeschakeld, terwijl het Kaby Lake-equivalent, de i3-8130U, dezelfde baseclock heeft, maar een hogere turbo én een werkende igp, en dat allemaal binnen hetzelfde 15W-tdp-budget.

/i/2002256417.jpeg?f=imagenormal)

Gelukkig zijn er ook succesvollere productintroducties van Intel geweest in 2018, waarbij de Coffee Lake en -Refresh-serie van respectievelijk april en oktober het relevantst zijn. In april werd de eerste batch Coffee Lake-processors uitgebreid met een breder aanbod en in oktober volgde de zogeheten negende generatie Coffee Lake-processors. Dit zijn eigenlijk precies dezelfde processors, maar Intel gaf ze een nieuwe generatieaanduiding, met 9xxx als modelnummer. Een van de weinige significante veranderingen is de hardwarematige aanpassing tegen Spectre- en Meltdown-bugs. Bovendien heeft het topmodel acht in plaats van zes cores en wordt maximaal 128GB geheugen ondersteund, tegenover 64GB voor de vorige modellen.

/i/2002238025.jpeg?f=imagenormal)

Ook op het hedt-vlak gaf Intel tegengas aan het core-geweld van AMD, met de introductie van nieuwe Skylake-X-processors. Het topmodel daarvan heeft net als het topmodel van vorig jaar 18 cores, maar Intel kondigde tijdens de Computex ook een Xeon met 28 cores aan. Op zich had Intel al Xeons met zoveel cores, maar de Xeon W-3175X is bijzonder omdat deze een 'enthousiast'-processor is voor high-end workstations. Bovendien is de processor overklokbaar, iets wat Intel tijdens de Computex demonstreerde met een chiller, waarbij de cpu tot 5GHz werd overgeklokt. Intel vergat echter te melden dat de Xeon extreem werd gekoeld en deed het voorkomen dat de getoonde 5GHz-kloksnelheid stock was.

New Horizon en chiplets

Met 2018 achter de rug wordt het tijd om vooruit te kijken naar wat we in 2019 mogen verwachten. We beginnen weer met AMD, dat in november tijdens zijn New Horizon-evenement een vooruitblik op de techniek van 2019 gaf.

De ster van de show was uiteraard de nieuwe Zen 2-architectuur, die net als de eerste generatie Zen-cores de basis zal vormen van alle komende processors. Tijdens het evenement noemde AMD enkel zijn Epyc 2-serverprocessors, aangezien het bedrijf die chips al aan klanten samplet. Dezelfde cores moeten echter ook hun weg gaan vinden naar de diverse Ryzen-processors, inclusief de Threadrippers.

Met Zen 2 gaat AMD de overstap maken naar 7nm-chips, die echter niet meer worden geproduceerd door GlobalFoundries, zoals de huidige chips, maar bij TSMC zullen worden gemaakt. GloFo heeft aangegeven niet te willen concurreren met de fabs die agressief blijven scalen, omdat de investeringen te hoog zijn. De 7nm-Zen 2-cores van TSMC krijgen dankzij het kleinere procedé een dubbel zo hoge transistordichtheid en zijn vijftig procent zuiniger bij gelijke prestaties.

Bovendien heeft AMD aangekondigd dat de Zen 2-cores een stuk krachtiger zijn, vooral dankzij een verbetering in de floating point-units. Die hebben twee keer zoveel bandbreedte gekregen, zowel in load/store-units als in de fpu's zelf, en de avx2-ondersteuning is verbeterd. De execution units van de fpu's zijn in Zen 2 256bit geworden, in plaats van 128bit bij Zen 1. Mede daardoor kan een Zen 2-core 16 flops/kloktikken in de floating point-unit halen, waarmee hij Sky Lake-cores evenaart. Daarnaast heeft AMD de branch prediction verbeterd, en de instructiecache en µop-cache geoptimaliseerd. Al die factoren dragen bij aan een ipc-verbetering, maar het is nog onbekend hoeveel sneller de Zen 2-cores exact worden. De Zen 2-cores hebben ook hardwarematige beveiliging tegen kwetsbaarheden als Spectre.

AMD wint het meestal op prijs en aantal cores, maar Intel heeft altijd hoger geklokte processors gehad

Volgens sommige voorspellingen, of wensenlijstjes zo je wilt, zouden de nieuwe Ryzen 3000-processors 6 tot 16 cores krijgen en flink hoger geklokt gaan worden dan de 2000-serie. Bovendien zou Zen 2 een ipc-verbetering krijgen, die gecombineerd met hogere kloksnelheden AMD-processors voorbij die van Intel zouden brengen. AMD wint het meestal op prijs en aantal cores van Intel, maar laatstgenoemde heeft tot dusver altijd hoger geklokte processors in zijn assortiment gehad en Intels processors hebben een kleine ipc-voorsprong. Volgens de voorspelling van met name AdoredTV zou de nieuwe generatie Ryzen-processors niet alleen sneller dan Coffee Lake-processors worden, maar ook een stuk goedkoper en voorzien van lage tdp's. De tijd zal het leren.

Chiplets

Een van de features van AMD's 2019-line-up die wel door AMD zelf is aangekondigd, is de manier waarop de chips worden samengesteld. Vooralsnog heeft AMD enkel zijn Epyc 2-serverprocessors getoond, maar die hebben een interessant ontwerp met zogeheten chiplets. Waar de eerste generatie Epyc, en daarmee de Threadrippers die tot dusver zijn uitgekomen, nog waren opgebouwd uit vier Zeppelin-dies, ieder met twee core-complexes met in totaal acht cores, krijgt de tweede Epyc-generatie een extra die aan boord. De dies met de cores worden namelijk uitgekleed. Die krijgen niet langer naast de Zen (2)-cores ook geheugen- en pci express-controllers en andere i/o-hardware aan boord, maar worden gereduceerd tot zogeheten chiplets met enkel de cpu-cores.

In Epyc 2 worden tot 8 van die chiplets, met elk maximaal 8 Zen 2-cores, gecombineerd met een extra 'chip' die voor alle i/o als geheugencontrollers en pci express-controllers zorgt. De chiplets met de cores worden op het meest geavanceerde 7nm-procedé gemaakt, maar de i/o-controller wordt op 14nm gemaakt. Daarmee maakt AMD zijn chips nog meer modulair, en kan het kosten besparen door het prijzige 7nm-procedé alleen in te zetten bij de cores en voor de minder kritische i/o-onderdelen goedkopere 14nm-techniek in te zetten. Uiteraard communiceren de diverse onderdelen nog steeds met elkaar via Infinity Fabric, net als in de huidige Zen-producten.

De stilte doorbroken: Intel

Na een lange periode van relatief weinig openheid van Intel naar de buitenwereld in het algemeen en naar de pers in het bijzonder heeft het bedrijf in december weer een kijkje in zijn keuken gegeven in de vorm van een Architecture Day. Daarin deed het uitgebreid uit de doeken tegen welke problemen het opliep met de overstap van 14 naar 10nm en, belangrijker, heeft Intel verteld wat het in petto heeft voor de komende periode.

Om met de 10nm-productie te beginnen: die gaat er, naast het enkele model uit de Cannon Lake-serie dat we eerder noemden, nog wel komen, maar dan niet meer met de Skylake-architectuur. 10nm staat nog steeds op de planning, maar dan in de vorm van Ice Lake-processors. Die moeten met een geoptimaliseerd 10nm-procedé gemaakt gaan worden, met aan boord een nieuwe cpu-core, namelijk Sunny Cove, waarover zodirect meer.

Een van de belangrijkste conclusies die Intel zegt te hebben getrokken, is dat we in een nieuw tijdperk van architecturen zijn beland, na het tijdperk van de megahertzen en het tijdperk van meer cores. Simpel gezegd ziet het bedrijf niet zoveel heil meer in het verhogen van kloksnelheden of het toevoegen van meer cores om de prestaties van zijn processors te verbeteren, maar moet de winst worden gezocht in slimmere architecturen.Het bedrijf ziet niet zoveel heil meer in het verhogen van kloksnelheden of het toevoegen van meer cores

De eerste van die nieuwe architecturen wordt Sunny Cove, de core die we vermoedelijk volgend jaar in Ice Lake-processors gaan vinden. De Sunny Cove-core heeft meer rekenkracht dan de huidige architecturen, onder meer dankzij uitbreidingen van diverse buffers en caches in de frontend van de processor. Dat is nodig, omdat de execution units, de eenheden die daadwerkelijke berekeningen verrichten, zijn uitgebreid van 8 in Skylake naar 10 stuks in Sunny Cove. Samen daarmee zijn ook de caches als L1-, L2-caches en de TLB groter gemaakt en is de branch prediction verbeterd, om al die out-of-order rekenkracht optimaal te vullen.

Op het gebied van de instructies zijn verder diverse nieuwe toegevoegd, vooral bedoeld voor encryptie en decryptie van data, zoals met aes-algoritme en hashing met sha. Ook is het comprimeren van data verbeterd en zou Intel nog tal van instructies voor onder meer big data, machinelearning en vectorberekeningen toevoegen. Daarmee moeten Sunny Cove-cores een stuk sneller worden dan de huidige Skylake-cores die in alle 14nm-producten zitten. Hoeveel sneller ze zouden worden, is nog afwachten; daarover deed Intel op de Architecture Day geen uitspraken. Overigens zou na Sunny Cove een nieuwe core volgen met codenaam Willow Cove, die nog meer cacheoptimalisaties en verbeteringen aan het procedé krijgt, gevolgd door Golden Cove-cores, die onder meer snellere singlethreaded prestaties en verbeterde ai-prestaties krijgt.

Intels processors hebben al jaren gpu's aan boord en ook die belooft Intel flink sneller te maken dan de huidige. Daarbij lijkt generatie 10 te worden overgeslagen en gaan we van de huidige 9,5e generatie direct door naar de 11e. Die gaat een rekenkracht van ruim een teraflops krijgen, vergelijkbaar met AMD's geïntegreerde gpu's in Raven Ridge en Nvidia's 1030-kaarten. Om optimaal van de rekenkracht voor games gebruik te maken, krijgen de gpu's ondersteuning voor het selectief renderen van onderdelen in een frame, zodat snelle bewegingen meer rekencapaciteit toegewezen krijgen dan statische onderdelen. AMD en Nvidia gebruiken vergelijkbare technologie. Bovendien gaat Intel onder de naam Adaptive Sync monitors met Freesync ondersteunen. Ook de videodecoding is verbeterd met onder meer hdr-ondersteuning en verbeterde hevc-codecs.

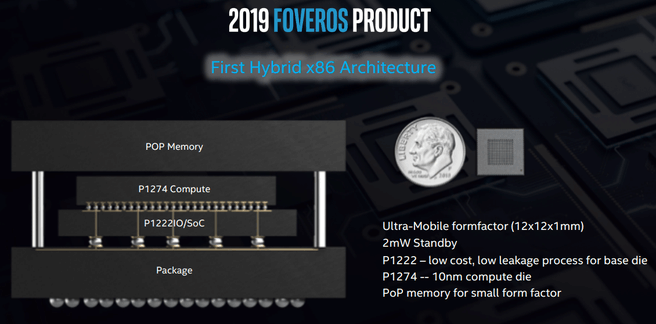

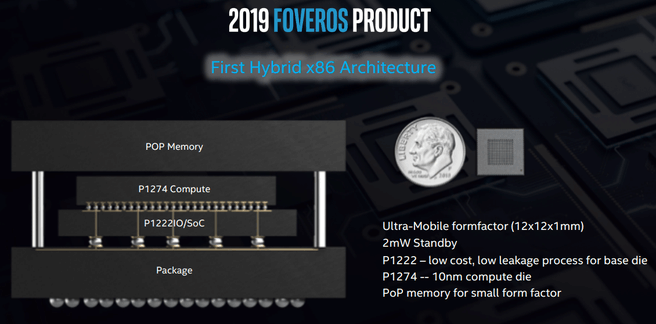

Foveros en Intels chiplets

We hebben het al even over Intels overstap naar 10nm gehad, maar we gaan nog even iets verder in op de daadwerkelijke productie van Intels nieuwe generatie processors. De 10nm-node die voor Cannon Lake is ontwikkeld en niet verder ontwikkeld zal worden, heeft een onbekende codenaam gekregen. De Sunny Cove-core, die productiegereed is, heeft naar alle waarschijnlijkheid intern de codenaam 1274 gekregen. Inmiddels heeft Intel ook een optimalisatie voor de 10nm-node in ontwikkeling, die het 1274.7 noemt, en nog een tweede optimalisatie, die als 1274.12 door het leven gaat. Intels nodes voor core-logica hebben een opeenvolgend even nummer, met een 12 ervoor voor 12"-wafers, en de i/o-logica heeft oneven nummers.

Dat is echter niet de enige node die Intel in zijn fabs produceert. Het bedrijf is namelijk van plan slechts een deel van zijn transistorlogica op 10nm te produceren, het deel dat daar het meest van profiteert. Dat zijn dus de daadwerkelijke rekencores, maar de perifere logica, zoals i/o, geheugencontrollers en pci express-controllers, hoeven niet zo nodig op het kleinst mogelijke procedé gemaakt te worden. Denk maar aan chipsets die vaak een of twee nodes achterlopen op processors. Wafers worden echter integraal geproduceerd. Je kunt dus niet een stukje van een wafer op 10nm maken en een stukje op 14nm. Daaruit volgt dat je een processor ook niet uit 10nm- en 14nm-onderdelen kunt laten bestaan, of toch?

Toch wel, want net als AMD wil Intel chiplets met snelle cores gaan maken en die combineren met andere stukken silicium, of dies, met daarop de controllers en andere i/o. Dat betekent dat Intel ook met silicium interposers moet gaan werken om die onderdelen met elkaar te laten communiceren, een techniek die Intel eerder al pionierde met emib-technologie, maar die nu in een verdere ontwikkeling als Foveros te boek staat. Dat Intel net als AMD chiplets gaat bouwen, is niet heel gek als je bedenkt dat Jim Keller, een bekende cpu-architect die eerder bij AMD werkte en de Zen-architectuur uitstippelde, inmiddels bij Intel werkzaam is.

Die Foveros-technologie moet het mogelijk maken om 10nm-chiplets met de cores te combineren met 14nm-i/o-chips en zo een complete cpu-package te maken. De Foveros-techniek gaat echter verder, want ze integreert niet alleen dies in een 2- of 2,5-dimensionale configuratie, maar ook in 3d. Het is met Foveros namelijk mogelijk om ook dies op elkaar te stapelen en zo zeer compacte chips met heterogene onderdelen te ontwikkelen.

Dat Foveros niet alleen een interessant concept is, maar daadwerkelijk in een vergevorderd stadium verkeert, blijkt uit een demochip die Intel liet zien. In die chip heeft Intel niet alleen met de Foveros-techniek een 10nm-die met compute-cores en een 14nm-i/o-die met elkaar gecombineerd. Er is ook een geheugenchip bovenop gestapeld en het geheel is slechts 12 bij 12mm groot en 1mm dik. Bovendien is het stand-byverbruik slechts 2mW en om nog zuiniger te werken, zijn niet alleen krachtige 10nm-Sunny Cove-cores gebruikt, maar in de 14nm-soc zitten bovendien Atom-achtige cores die lichte taken voor hun rekening moeten nemen. Zo combineert Intel dus krachtige Sunny Cove-cores met minder krachtige Atom-cores, voor het zware en lichte werk, vergelijkbaar met ARM's big.Little-concept dus. Uiteraard zijn bij Intel alle cores x86-cores, dus Windows moet in een ultradunne laptop of 2-in-1-apparaat zonder emulatie met de chip overweg kunnen. Producten met de chip moeten al volgend jaar verkrijgbaar zijn.

Tot slot: kapers op de kust?

Over ARM gesproken, we kunnen niet voorbij aan Qualcomm, bekend van zijn Snapdragon-chips. Diverse fabrikanten hebben jarenlang gepoogd om desktopsoftware op ARM-chips te laten draaien, met wisselend succes. Zo had ooit een desktop-Ubuntu op telefoons moeten draaien, zodat je met hetzelfde apparaat kon wisselen tussen telefoon en desktop, en we kennen allemaal nog de gefaalde Windows RT-pogingen.

Inmiddels draait Windows echter prima op ARM-hardware, reden voor Qualcomm om weer een poging te wagen om niet alleen een dominante speler op de telefoonmarkt, maar ook op de laptopmarkt te worden. Dit jaar doet het dat niet met een standaard Snapdragon-soc, maar met een speciaal daarvoor ontwikkelde chip. Qualcomm noemt die chip Snapdragon 8cx.

De 8cx maakt gebruik van de Kryo 495, met aan boord de nieuwste A76-cores van ARM, die ook in de nieuwe Snapdragon 855-soc zitten en vergeleken met de A75-cores van onder meer de 845-soc tot 35 procent sneller zouden zijn. In de Kryo 495 zitten acht cores in een big.Little-configuratie. Vier van die cores zijn A76-cores met onbekende kloksnelheid en de andere vier zijn A55-cores. De Kryo 495 beschikt over in totaal 10MB cache, en kan overweg met 16GB geheugen en nvme- of ufs 3.0-opslag. Qualcomm is net als AMD klant bij TSMC en de 8cx wordt op diens 7nm-node geproduceerd.

Dat klinkt allemaal zeer positief en volgens Qualcomm kan de 8cx binnen een thermal envelope van 7W een prestatieniveau volhouden dat vergelijkbaar is met Intels mobiele Y-processors. Het enige nadeel is dat alleen Windows en een handjevol apps native met de ARM-architectuur overweg kunnen. Als je gewone software wil draaien, moet een emulator de vertaalslag van x86-code naar ARM's risc-architectuur maken. Aangezien emulatielagen nooit tot snelheidswinst, maar enkel tot vertraging leiden, is het afwachten hoe de 8cx zich in de praktijk staande zal houden.

/i/2002419556.jpeg?f=imagenormal)

Toch lijkt er steeds meer momentum te komen voor ARM als ultrazuinige laptopprocessor. Zo is volgens Apple ook diens A12X-processor snel genoeg om zich met x86-processors te meten en is het volgens sommigen een kwestie van tijd voordat Apple, voor ten minste een deel van zijn laptops, de overstap maakt naar zijn eigen processors, in plaats van die van Intel. Voor Apple is het daarentegen wellicht makkelijker om zijn developers te dwingen een dergelijke overstap te maken, eventueel met een tijdelijke emulatieperiode. Het zou immers niet voor het eerst zijn, gezien de overstap van de PowerPC-architectuur naar Intels x86-processors, met Rosetta als vertaallaag.

Of 2019 echter het jaar wordt waarin we Apple Macbooks met A12-soc zullen zien, moeten we afwachten, maar ook zonder A12 in laptops blijft er genoeg over met Zen 2, Sunny Cove, en Foveros en de 8cx. Hoe dan ook wordt 2019 het jaar van TSMC's 7nm-node en komt Intel met zijn 10nm-node.

/i/1304670448.jpeg?f=imagenormal)

/i/2002162173.jpeg?f=imagenormal)

/i/2001759621.jpeg?f=imagenormal)

/i/2002256417.jpeg?f=imagenormal)

/i/2002238025.jpeg?f=imagenormal)

/i/2002422028.png?f=imagemedium)

/i/2002430448.png?f=imagemedium)

/i/2002419556.jpeg?f=imagenormal)

:strip_icc():strip_exif()/i/2006107804.jpeg?f=fpa_thumb)

:strip_icc():strip_exif()/i/2005002394.jpeg?f=fpa_thumb)

:strip_icc():strip_exif()/i/2002433366.jpeg?f=fpa_thumb)

:strip_icc():strip_exif()/i/2002340547.jpeg?f=fpa_thumb)

:strip_icc():strip_exif()/i/2001385603.jpeg?f=fpa_thumb)

:strip_icc():strip_exif()/i/2001941433.jpeg?f=fpa_thumb)

/i/2001665377.png?f=fpa)

/i/2001237765.png?f=fpa)

:strip_exif()/i/2002158313.jpeg?f=fpa)

/i/1243859159.png?f=fpa)

/i/1347363581.png?f=fpa)

:strip_exif()/i/1286274802.jpeg?f=fpa)

:strip_exif()/i/2002304455.jpeg?f=fpa)

/i/2001331269.png?f=fpa)

:strip_exif()/i/2001508675.jpeg?f=fpa)

:strip_exif()/i/2001969371.jpeg?f=fpa)