Clichés

In weinig sectoren is het cliché 'stilstand is achteruitgang' zo van toepassing als in de technologiesector. Hand in hand daarmee gaat een 'wet' die bijna een eeuw geleden door de Nederlandse historicus Jan Romein is opgepend. Zijn wet van de remmende voorsprong heeft een afgeleide, de wet van de stimulerende achterstand, en beide zijn van toepassing in de chipindustrie.

Chipgigant Intel genoot namelijk vele jaren van een positie als marktleider. Het bedrijf bekleedde vijfentwintig jaar de toppositie in de halfgeleidermarkt, als bedrijf met de grootste omzet. Bovendien had Intel vele jaren een technologische voorsprong, waardoor het in staat was om zuinigere chips te produceren op een kleinere node. Er was nog niet zo lang geleden zelfs sprake van een voorsprong van ongeveer twee jaar.

Was, is het sleutelwoord, want Intel lijkt te worden geplaagd door een remmende voorsprong. In de afgelopen maand kondigde concurrent TSMC, Taiwans grootste halfgeleiderfabrikant, aan dat het klaar is voor de massaproductie van 7nm-chips. Intels andere grote concurrent, Samsung, werd bijna tegelijk 's werelds grootste halfgeleiderfabrikant, vooral omdat de omzet van nandchips en dram opnieuw steeg. Zo verloor Intel in één klap zijn koppositie als grootste halfgeleiderbedrijf wat omzet betreft, en zijn technologische voorsprong; Intel produceert namelijk nog altijd chips op 14nm.

Wat betekent dat voor Intel en wat is de strategie van het bedrijf? Wat kunnen we in de komende maanden verwachten en is Intel nog in staat zich terug te vechten naar een toppositie?

Marktaandeel en nodes

Samsung is volgens marktanalysebureau Gartner, niet de minste als het om dergelijke onderzoeken gaat, in 2017 Intel voorbijgestreefd als chipfabrikant met de grootste omzet. Daarmee komt een eind aan een hegemonie van zo'n vijfentwintig jaar: een kwart eeuw waarin Intel de meeste omzet in de halfgeleidermarkt realiseerde.

Samsung kon vooral profiteren van de prijsdruk die al tijden op geheugen staat. De vraag naar zowel dram als nand, voor werkgeheugen en voor opslag dus, is groter dan het aanbod, een situatie waarvan Samsung als grootste geheugenfabrikant kon profiteren. De halfgeleideromzet steeg over 2017 met zo'n 45 procent vergeleken met het jaar ervoor.

| 2017 Rank |

2016 Rank |

Fabrikant |

Omzet 2017 (in miljarden dollars) |

Marktaandeel 2017 |

Omzet 2016 |

Groei 2016-2017 |

| 1 |

2 |

Samsung Electronics |

59,875 |

14,2% |

40,104 |

49,3% |

| 2 |

1 |

Intel |

58,725 |

14,0% |

54,091 |

8,6% |

| 3 |

4 |

SK hynix |

26,370 |

6,3% |

14,681 |

79,6% |

| 4 |

5 |

Micron Technology |

22,895 |

5,4% |

13,381 |

71,1% |

| 5 |

3 |

Qualcomm |

16,099 |

3,8% |

15,415 |

4,4% |

| 6 |

6 |

Broadcom |

15,405 |

3,7% |

13,233 |

16,4% |

| 7 |

7 |

Texas Instruments |

13,506 |

3,2% |

11,899 |

13,5% |

| 8 |

8 |

Toshiba |

12,408 |

3,0% |

9,918 |

25,1% |

| 9 |

17 |

Western Digital |

9,159 |

2,2% |

4,170 |

119,6% |

| 10 |

9 |

NXP |

8,750 |

2,1% |

9,314 |

-6,1% |

| |

|

Overig |

177,201 |

42,1% |

159,645 |

11,0% |

| |

|

Totaal |

420,393 |

100,0% |

345,851 |

21,6% |

Bron: Gartner (april 2018)

Het makkelijkst is het natuurlijk om te wijzen op de nog altijd krimpende pc-markt waarmee Intel al jaren worstelt, maar dat is slechts een deel van het verhaal, want Intel rapporteerde over 2017 een recordomzet van 62,8 miljard dollar, waar dat over 2016 59,4 miljard dollar was. De winst liep iets terug, maar dat was terug te voeren op een verandering in het Amerikaanse belastingstelsel. Bovendien liet Intels Client Computing Group, onder meer verantwoordelijk voor desktop- en mobileprocessors, een klein plusje zien.

Van de hoge prijzen op de geheugenmarkt kan Intel echter niet erg profiteren, aangezien maar een procent of 6 van de omzet van de opslagdivisie komt. Desalniettemin boekte die afdeling een omzetstijging van 37 procent, en ook de vrijwel even grote, of liever even kleine, iot-divisie liet een flinke groei van 20 procent zien. Programmeerbare chips, zoals de fpga's die het via Altera verkreeg, zijn goed voor een omzet van krap twee miljard dollar, met 14 procent groei vergeleken met 2016. Is dat genoeg, of heeft Intel te laat en op de verkeerde paarden gewed?

Mislukte uitbreidingen

Zonder meer de bekendste misser van Intel is die van de mobiele telefoon. Al heel vroeg had Intel de kans een grote speler op dat vlak te worden, met de overname van DSP Communications in 1998. Intel ontwikkelde destijds een bedrijfstak die XScale genoemd werd en had op dat moment een licentie om ARM-processors te maken. Enkele jaren en ettelijke miljarden aan investeringen later verkocht Intel de telefoonprocessortak aan Marvell voor een luttele zeshonderd miljoen dollar. Toegegeven, de markt was toen niet wat ie nu is, maar Intels tweede poging in de smartphonewereld was too little, too late en de markt was al grotendeels vergeven met ARM-socs. Intels relatief energiehongerige x86-processors vonden nooit echt aftrek, reden voor Intel om in 2016 zijn nieuwe generaties Broxton- en Sofia-socs te schrappen.

/i/2001441471.jpeg?f=imagemedium) Mobiele telefoons zijn big business en Intel heeft die boot gemist, maar dat is niet de enige misstap buiten de geijkte paden van pc, laptop en server. Intel Media, een tak die settopboxes en smart-tv's moest maken, werd in 2013 opgedoekt en recenter, in 2017, stopte Intel met de ontwikkeling van wearables, zoals slimme hoofdtelefoons en horloges.

Mobiele telefoons zijn big business en Intel heeft die boot gemist, maar dat is niet de enige misstap buiten de geijkte paden van pc, laptop en server. Intel Media, een tak die settopboxes en smart-tv's moest maken, werd in 2013 opgedoekt en recenter, in 2017, stopte Intel met de ontwikkeling van wearables, zoals slimme hoofdtelefoons en horloges.

Nog recenter werd zelfs de complete gadgetafdeling, de zogeheten New Devices Group, gesloten. Die afdeling ontwikkelde onder meer de Vaunt-smartglasses, een bril met head-updisplay. Ook een andere bril, de standalone-vr-bril met codenaam Project Alloy, werd enkele maanden geleden geschrapt.

Een laatste voorbeeld: de laatste paar IDF's, Intels Development Forum, waarop het jaarlijks zijn nieuwste technologie demonstreerde aan ontwikkelaars, journalisten en analisten, stonden bol van de diy-tech, zoals Intels Arduino-kloon, de losse Curie-modules die daarop zitten, en minicomputers als Galileo en Joule. Al die producten worden inmiddels niet meer verkocht en Intel lijkt de 'maker'-markt, die het zo enthousiast omarmde, te hebben verlaten. Overigens worden ook die IDF's niet langer georganiseerd.

Dan komen we bij een van de methodes die Intel kan inzetten om zijn productportfolio uit te breiden: het maken van producten voor derden. In 2013 gaf Intel aan dat het de chipproductie voor andere bedrijven op zich zou nemen. Intel zou ten minste deels net als TSMC of GlobalFoundries een zogeheten foundry worden. Dat zou betekenen dat bedrijven die de miljardeninvesteringen in chipfabrieken of fabs niet kunnen opbrengen, toch gebruik kunnen maken van het nieuwste van het nieuwste op het gebied van halfgeleiderproductietechnologie.

Vooralsnog levert de foundrytak echter bitter weinig omzet. Waar dat aan ligt, is onduidelijk, maar Intel zoekt partners waarvan het bedrijf zelf kan profiteren. Zo zou het aantrekkelijk zijn voor Intel als het socs kon maken voor een bedrijf dat nu bij de concurrent chips laat bouwen. Het mes snijdt dan aan twee kanten. Enerzijds levert het inkomsten voor Intel en zijn de dure fabs beter gevuld, anderzijds snoept het marktaandeel weg bij de concurrent. Denk bijvoorbeeld aan een klant als Apple, dat bij TSMC zijn A12-soc laat maken. Intel zou een dergelijke klant maar wat graag hebben, maar dan moet het voor een bedrijf als Apple wel aantrekkelijk zijn om voor Intel te kiezen. Tot dusver kon Intel bogen op een superieure technologie, maar is dat nog wel zo?

Tick, Tock, Tick, Tick, Tick...

Jarenlang kon je de klok erop gelijk zetten; elk jaar of elke achttien maanden bracht Intel een nieuwe architectuur, of Tock, uit. Die werd gevolgd door een verkleining van de procestechnologie: de Tick. Zo gingen we in 2006 van 65nm-chips met de Core-architectuur naar 45nm-Core-chips, gevolgd door Nehalem op eveneens 45nm, en een verkleining naar Westmere. Op een goed moment in deze cadans, rond 2014, had Intel naar eigen zeggen een technologievoorsprong van maar liefst drieënhalf jaar op zijn concurrenten. Een realistischer beeld zou een voorsprong van twee jaar zijn.

Toen Intel echter bij 22nm was aangekomen, met de Haswell-microarchitectuur, bleek de stap naar 14nm Broadwell-chips lastig. Er moest een Refresh voor de Tick worden ingelast, waardoor de cadans spaak liep. Dat werd nog veel erger toen de Tock van Skylake kwam. In plaats van een Tick naar een 10nm-architectuur volgden diverse optimalisaties van de Skylake-architectuur, met Kaby Lake en Kaby Lake Refresh. Het hele Tick-Tock-idee is inmiddels zelfs losgelaten en het is nog altijd onduidelijk wanneer precies de langverwachte stap naar 10nm zal volgen.

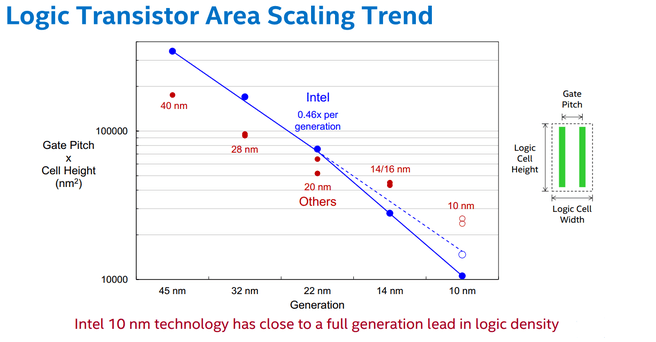

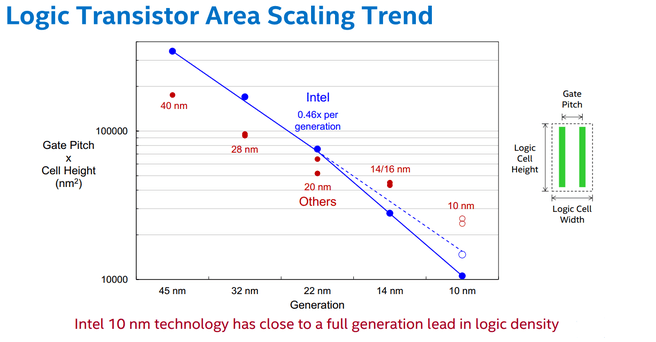

Nu is de ene procestechnologie de andere niet en Intel hanteert net iets andere dimensies om zijn nodes te benoemen. De 14nm-transistors van de huidige Intel-processors hebben dan ook geen enkele dimensie die aan 14nm doet denken, en datzelfde geldt voor de 16nm-node van TSMC en de 14nm-node van Samsung. Sterker nog: Intels 14nm-node is aanzienlijk compacter dan de 16nm- en 14nm-nodes van TSMC en Samsung, en komt eerder overeen met de 10nm-node van TSMC.

Waar Intel dus nog op 14nm produceert en pas in 2019 naar 10nm overstapt, produceert concurrent TSMC al geruime tijd op 10nm. Dat die equivalent is aan Intels 14nm-node, wordt echter langzaam irrelevant, want TSMC kondigde onlangs aan gereed te zijn voor de massaproductie van 7nm-chips. Ook Samsung produceert al geruime tijd op 10nm en maakt zich op voor 8nm-productie. Daarmee heeft ten minste TSMC Intel ingehaald; de 7nm-node van TSMC is ruwweg equivalent aan Intels 10nm-node. TSMC biedt echter momenteel al massaproductie op zijn CLN7FF-procedé met tientallen ontwerpen en volgend jaar volgt een verbeterde versie: CLN7FF+.

| Codenaam |

|

uArch |

Node |

Jaar |

| Haswell (Tock) |

|

Haswell |

22nm |

2013 |

| Haswell Refresh (Optimization) |

|

Haswell |

22nm |

2014 |

| Broadwell (Tick) |

|

Haswell |

14nm |

2014 |

| Skylake (Tock) |

|

Skylake |

14nm |

2015 |

| Kaby Lake (Optimization) |

|

Skylake |

14nm |

2017 |

| Kaby Lake R (Optimization, Mobile) |

|

Skylake |

14nm |

2017 |

| Coffee Lake (Optimization) |

|

Skylake |

14nm |

2017 |

| Whiskey Lake (Optimization, Mobile) |

|

Skylake |

14nm |

2018 |

| Cannon Lake (Tick) |

|

Skylake |

10nm |

2019? |

| Ice Lake (Tock/Optimization) |

|

Ice Lake |

10nm |

2020? |

| Tiger Lake (Optimization) |

|

Ice Lake |

10nm |

2020? |

Intel zit dus voorlopig nog vast op het 14nm-procedé, al is dat wel wat geoptimaliseerd sinds het bedrijf er in 2014 op overstapte. Pas in 2019 zal het, zoals het er nu voorstaat tenminste, overstappen op een 10nm-procedé. Daarmee is het zijn technologische voorsprong, die ooit verscheidene jaren bedroeg, kwijt en loopt de gewezen grootste chipfabrikant nu opeens een jaar achter op TSMC en Samsung. Bovendien is Intel een troef kwijt om klanten naar zijn foundrybusiness te krijgen, want wie leading-edgetechnologie wil, kan inmiddels misschien beter naar TSMC. Ook Samsung biedt momenteel 10nm-chips en bij GlobalFoundries staat de 7nm-node eveneens klaar.

Hoe verder?

Anno 2018 staat Intel er minder rooskleurig voor dan voorheen. Het is echter niet helemaal eerlijk om te rekenen met de nodes die fabrikanten zelf opgeven, want die geven de daadwerkelijke transistorafmetingen al lang niet meer accuraat weer. Zoals we op voorgaande pagina's al aangaven, is Intels 10nm-node min of meer equivalent aan de 7nm-node van diens concurrenten. We zetten de nodes voor dit jaar en de geplande nodes voor volgend jaar even op een rij en zetten er de gecorrigeerde afmetingen bij.

|

Fabrikant

|

Huidige node

Standaardnode-equivalent |

Geplande node |

| GloFo |

10nm

10,3nm |

7nm (eind 2018, begin 2019)

7,8nm (euv) |

| Intel |

14nm (en 10nm?)

12,1nm (en 8,3nm?) |

10nm (massaproductie 2019)

8,3nm (193i) |

| Samsung |

14nm en 10nm

14,4nm en 11,2nm |

7nm (2H 2018)

8,2nm (euv) |

| TSMC |

16nm, 10nm en 7nm

15,7nm, 10,3nm en 7,9nm |

7nm (2018) en 7nm+ (2019)

7,9nm (193i) en 7,9nm? (euv) |

In 2019 zou Intel dus weer redelijk concurrerend moeten zijn, maar TSMC en Samsung hebben voor dat jaar 5nm-nodes op de planning staan. Intel zou rond 2020 een 7nm-node introduceren, maar gezien de vertragingen met de 10nm-node is het afwachten of het bedrijf die tijdslijn kan realiseren. Intel heeft aangegeven al 10nm-chips te leveren, maar welke producten dat zijn, is onduidelijk. Een kandidaat zou de processor uit de nieuwste NUC zijn: een i3-8121U, een dualcore die vreemd genoeg zonder gpu zou worden gemaakt.

Een van de grootste problemen om van 14nm-processors naar 10nm-processors over te stappen, zou het probleem van de yields zijn. Intel heeft het 14nm-procedé inmiddels goed op orde, met diverse verbeteringen, onder meer in de verhouding tussen ribhoogte en -breedte van de finfets, wat sinds de introductie inmiddels zeventig procent betere prestaties voor de 14nm-transistors zou opleveren. Een factor die bijdraagt aan de problemen met 10nm-chips waar concurrenten minder last van lijken te hebben, zou de complexiteit van Intels processors kunnen zijn. Een x86-multicoreprocessor zit flink anders in elkaar dan bijvoorbeeld een gpu of soc, en de chips zouden gevoeliger voor fouten kunnen zijn.

Het 10nm-procedé zou lage yields hebben, waardoor te veel chips op een wafer niet goed zouden functioneren. Het lek zou inmiddels boven water zijn, maar niet op tijd om nog dit jaar massaproductie te draaien. Een van de oorzaken zou zijn dat Intel ook voor 10nm nog geen euv inzet, maar afhankelijk is van multipatterning en daarmee gepaard gaande defecten.

K/i/2001575531.jpeg?f=imagemedium) ortom, Intel heeft de boot gemist wat mobiele socs betreft en zijn technologische voorsprong van verscheidene jaren is inmiddels verdampt. Diverse pogingen om het productaanbod te diversificeren zijn grotendeels op niets uitgedraaid. Zo zijn gadgets als vr-brillen nooit succesvol geworden en moest de New Devices-afdeling worden gesloten. De diy-markt ontving Intel ook niet met open armen, vooral omdat de x86-processors nog altijd veel duurder waren dan goedkope Arduino's en andere bordjes met ARM-hardware. Het bedrijf wedt nu op andere paarden, zoals automotive, waarvoor het onder meer neurale netwerken wil maken. Als dat nog niet te laat is, ligt daar nog een miljardenmarkt voor Intel, dat met dat doel onder meer Nervana Systems, Movidius en Mobileye kocht.

ortom, Intel heeft de boot gemist wat mobiele socs betreft en zijn technologische voorsprong van verscheidene jaren is inmiddels verdampt. Diverse pogingen om het productaanbod te diversificeren zijn grotendeels op niets uitgedraaid. Zo zijn gadgets als vr-brillen nooit succesvol geworden en moest de New Devices-afdeling worden gesloten. De diy-markt ontving Intel ook niet met open armen, vooral omdat de x86-processors nog altijd veel duurder waren dan goedkope Arduino's en andere bordjes met ARM-hardware. Het bedrijf wedt nu op andere paarden, zoals automotive, waarvoor het onder meer neurale netwerken wil maken. Als dat nog niet te laat is, ligt daar nog een miljardenmarkt voor Intel, dat met dat doel onder meer Nervana Systems, Movidius en Mobileye kocht.

Ook de mobiele markt is nog niet helemaal losgelaten, met Intel als grote leverancier voor modems in zowel telefoons als masten. En natuurlijk heeft het bedrijf nog altijd een zeer dominant marktaandeel bij servers, desktops en laptops, maar concurrent AMD zou die heerschappij in de komende jaren weleens kunnen aanvallen.

/i/2001441471.jpeg?f=imagemedium)

/i/2001575531.jpeg?f=imagemedium) ortom, Intel heeft de boot gemist wat mobiele socs betreft en zijn technologische voorsprong van verscheidene jaren is inmiddels verdampt. Diverse pogingen om het productaanbod te diversificeren zijn grotendeels op niets uitgedraaid. Zo zijn gadgets als vr-brillen nooit succesvol geworden en moest de New Devices-afdeling worden gesloten. De diy-markt ontving Intel ook niet met open armen, vooral omdat de x86-processors nog altijd veel duurder waren dan goedkope Arduino's en andere bordjes met ARM-hardware. Het bedrijf wedt nu op andere paarden, zoals automotive, waarvoor het onder meer neurale netwerken wil maken. Als dat nog niet te laat is, ligt daar nog een miljardenmarkt voor Intel, dat met dat doel onder meer Nervana Systems, Movidius en Mobileye kocht.

ortom, Intel heeft de boot gemist wat mobiele socs betreft en zijn technologische voorsprong van verscheidene jaren is inmiddels verdampt. Diverse pogingen om het productaanbod te diversificeren zijn grotendeels op niets uitgedraaid. Zo zijn gadgets als vr-brillen nooit succesvol geworden en moest de New Devices-afdeling worden gesloten. De diy-markt ontving Intel ook niet met open armen, vooral omdat de x86-processors nog altijd veel duurder waren dan goedkope Arduino's en andere bordjes met ARM-hardware. Het bedrijf wedt nu op andere paarden, zoals automotive, waarvoor het onder meer neurale netwerken wil maken. Als dat nog niet te laat is, ligt daar nog een miljardenmarkt voor Intel, dat met dat doel onder meer Nervana Systems, Movidius en Mobileye kocht.:strip_icc():strip_exif()/i/2003043920.jpeg?f=fpa_thumb)

:strip_icc():strip_exif()/i/2002421862.jpeg?f=fpa_thumb)

/i/1239882744.png?f=fpa)

/i/2001665377.png?f=fpa)

:strip_exif()/i/2001969371.jpeg?f=fpa)

/i/2001543927.png?f=fpa)

/i/1240844012.png?f=fpa)

/i/2000621629.png?f=fpa)

/i/2002359975.png?f=fpa)

/i/1273568208.png?f=fpa)

/i/1260965273.png?f=fpa)

/i/2001393753.png?f=fpa)

/i/1349425400.png?f=fpa)

/i/1235349650.png?f=fpa)

/i/1297430422.png?f=fpa)