AMD en Nvidia kondigden maandag (lokale tijd in Las Vegas) beide nieuwe generaties videokaarten aan, maar de presentaties van de Radeon RX 9000-serie en de GeForce RTX 50-reeks konden bijna niet meer van elkaar verschillen. Waar AMD de verzamelde techjournalisten verbijsterd achterliet door in zijn persconferentie geen woord te besteden aan de RX 9070 XT en co − volgens directeur David McAfee omdat er 'te weinig tijd' was − liep Nvidia-ceo Jensen Huang het podium op in een volgepakte Michelob Ultra Arena, een stadion met een capaciteit van 12.000 mensen, om de wereld kennis te laten maken met vier nieuwe videokaarten.

Nvidia was ook aanzienlijk scheutiger met informatie over zijn nieuwe gpu's. De specificaties kon je vanochtend vroeg al lezen in ons nieuwsbericht, maar in de documentatie die Nvidia na de keynote met de pers deelde, staan nog veel meer details, bijvoorbeeld over DLSS 4, de nieuwe generatie van Nvidia's upscalingtechniek. In dit artikel lees je alles over Nvidia's aankomende videokaarten.

Blackwell voor gamers

De GeForce RTX 50-videokaarten maken gebruik van de Blackwell-architectuur, die Nvidia vorig jaar al introduceerde voor zijn datacenterproducten. Sinds de AI-hype is losgebarsten, zijn Nvidia's gpu's voor doeleinden als het trainen van AI-modellen niet aan te slepen en bovendien goud waard. Niemand met enige realiteitszin kan het Nvidia kwalijk nemen dat het dat segment voorrang gaf.

Blackwell is wel aangepast ten opzichte van de serverversies, zoals ook voorgaande architecturen niet volledig identiek waren tussen de consumenten- en serverversies. Bij de server-Blackwell lag de nadruk bijvoorbeeld op een enorme geheugenbandbreedte dankzij het gebruikte HBM-geheugen. Bij de gamingversie wordt 'gewoon' GDDR7 gebruikt en is er een nieuwe generatie raytracingcores aanwezig. Sommige van de verbeteringen in de serverversie zijn echter wel overgenomen, zoals ondersteuning voor berekeningen met een zeer lage fp4-precisie. Bepaalde generatieve AI-modellen kunnen daar met bijvoorbeeld quantization al goed mee omgaan en draaien daardoor veel sneller op de RTX 50-serie.

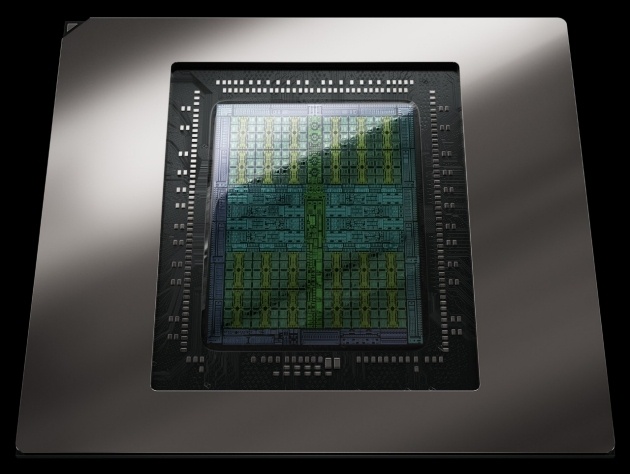

Bij de server-Blackwell was het topmodel, de GB200, een multichipoplossing. De GB202-gpu in de GeForce RTX 5090 is een grote, monolithische chip, met de nadruk op groot. De chip meet naar verluidt 750mm² en bevat 92 miljard transistors. Ter vergelijking: de AD102-chip in de RTX 4090 was 609mm² groot en telde 76 miljard transistors.

Alle nieuwe RTX 50-videokaarten maken gebruik van PCI-Express 5.0, waardoor de totale bandbreedte naar de rest van het systeem verdubbeld is ten opzichte van de voorgaande generaties. We weten uit het verleden dat een nieuwe PCIe-versie lang niet altijd echt nodig is om de volledige prestaties te behalen, maar of dat nu ook weer geldt, moeten we nog bezien.

De nieuwe line-up: GeForce RTX 5090, RTX 5080, RTX 5070 Ti en RTX 5070

Vooralsnog bestaat de nieuwe line-up uit vier modellen. Twee daarvan, de GeForce RTX 5090 en RTX 5080, hebben al een concrete releasedatum; ze komen op 30 januari uit. De RTX 5070 Ti en RTX 5070 volgen ergens in februari.

/i/2007169964.png?f=imagenormal)

Het topmodel van de nieuwe generatie is de GeForce RTX 5090. Deze videokaart maakt als enige gebruik van de high-end GB202-gpu, die 21.760 ingeschakelde CUDA-cores telt, bijna een derde meer dan de RTX 4090. Voor het eerst sinds de GeForce GTX 285 uit 2008 past Nvidia een 512bit-geheugenbus toe, die de gpu verbindt met maar liefst 32GB GDDR7-geheugen met een snelheid van 28Gbit/s. Dat komt neer op een totale geheugenbandbreedte van 1,8TB/s, bijna 80 procent hoger dan bij de RTX 4090. Ook de total graphics power (tgp) van de RTX 5090 valt in vergelijking met zijn voorganger hoger uit. Dat is nu 575W, net onder de limiet van 600W voor de 12Vhpwr-stroomconnector.

De RTX 5080 is gebaseerd op de kleinere GB203-gpu, die met 10.752 stuks bijna precies de helft van het aantal ingeschakelde cores heeft van de RTX 5090. Daarmee is het verschil tussen de twee duurste RTX 50-gpu's veel groter dan het verschil tussen de RTX 4090 en 4080 was. Geheel in dat thema heeft de RTX 5080 ook een half zo grote 256bit-geheugenbus en ook de helft van de hoeveelheid geheugen, met 16GB GDDR7. De tgp is 360W.

De laatste videokaarten die Nvidia vooralsnog heeft aangekondigd, zijn de RTX 5070 Ti en RTX 5070. De RTX 5070 Ti is gebaseerd op dezelfde GB203-gpu als de 5080, maar dan met minder ingeschakelde cores. Er zijn er nog 8960 over, gekoppeld aan 16GB GDDR7 met een lagere kloksnelheid dan bij de RTX 5080. Deze gpu heeft een tgp van 300W. De RTX 5070 gebruikt een kleinere GB205-gpu, heeft 6144 cores en ook minder geheugen: 12GB op een 192bit-bus. De tgp van dit model is 250W.

| RTX 5090 | RTX 4090 | RTX 5080 | RTX 4080 | RTX 5070 Ti | RTX 4070 Ti | RTX 5070 | RTX 4070 | |

|---|---|---|---|---|---|---|---|---|

| Architectuur | Blackwell | Ada | Blackwell | Ada | Blackwell | Ada | Blackwell | Ada |

| Procedé | TSMC N4P | TSMC N4 | TSMC N4P | TSMC N4 | TSMC N4P | TSMC N4 | TSMC N4P | TSMC N4 |

| Gpu | GB202 | AD102 | GB203 | AD103 | GB203 | AD104 | GB205 | AD104 |

| Cores | 21.760 | 16.384 | 10.752 | 9728 | 8960 | 7680 | 6144 | 5888 |

| Boostklok | 2,41GHz | 2,52GHz | 2,62GHz | 2,51GHz | 2,45GHz | 2,61GHz | 2,51GHz | 2,47GHz |

| Geheugen | 32GB GDDR7 | 24GB GDDR6X | 16GB GDDR7 | 16GB GDDR6X | 16GB GDDR7 | 12GB GDDR6X |

12GB GDDR7 | 12GB GDDR6X |

| Geheugenbus | 512bit | 384bit | 256bit | 256bit | 256bit | 192bit | 192bit | 192bit |

| Geheugen snelheid |

28Gbit/s | 21Gbit/s | 30Gbit/s | 22,4Gbit/s | 28Gbit/s | 21Gbit/s | 28Gbit/s | 14Gbit/s |

| Geheugen bandbreedte |

1792GB/s | 1008GB/s | 960GB/s | 716,8GB/s | 896GB/s | 504GB/s | 672GB/s | 504GB/s |

| Tgp | 575W | 450W | 360W | 320W | 300W | 285W | 250W | 200W |

| Interface | PCIe 5.0 x16 | PCIe 4.0 x16 | PCIe 5.0 x16 | PCIe 4.0 x16 | PCIe 5.0 x16 | PCIe 4.0 x16 | PCIe 5.0 x16 | PCIe 4.0 x16 |

| Releasedatum | 30-1-2025 | 12-10-2022 | 30-1-2025 | 16-11-2022 | 2-2025 | 5-1-2023 | 2-2025 | 12-04-2023 |

| Adviesprijs | 2369 euro | 1959 euro | 1190 euro | 1469 euro | 889 euro | 910 euro | 654 euro | 669 euro |

DLSS 4

Samen met de RTX 50-serie introduceert Nvidia de vierde generatie van zijn DLSS-upscalingtechniek. DLSS 4 kan tot drie frames extra genereren per gerenderd frame. Tot nu toe werd er bij Frame Generation in DLSS 3 maximaal één gegenereerd frame tussen twee 'echte' frames ingevoegd.

DLSS 4 werkt alleen op de RTX 50-videokaarten en maakt daarbij gebruik van de nieuwe tensorcores van de vijfde generatie. Drie onderdelen van DLSS, namelijk Ray Reconstruction, Super Resolution en Anti-Aliasing, maken bij DLSS 4 gebruik van een transformergebaseerd AI-model. Dit model is vooraf gegenereerd in Nvidia's datacenters.

Bij een transformer worden gegevens omgezet in zogenaamde tokens en opgeslagen in een vector, een getallenmatrix met één kolom. Deze techniek staat ook aan de basis van llm's. Door het gebruik van visiontransformers kan er veel meer data en rekenkracht worden gebruikt voor het toepassen van bijvoorbeeld upscaling en Ray Reconstruction. Nvidia noemt een verdubbeling van het aantal parameters en zelfs een verviervoudiging van de hoeveelheid rekenkracht.

Dat er nu meerdere frames gegenereerd kunnen worden tussen 'echte' gerenderde frames, komt door enkele aanpassingen in zowel de hardware als het gebruikte AI-model. Het nieuwe model is volgens Nvidia veertig procent sneller. De hardwarematige berekening van het 'optical flow field', waarin de richting en snelheid van bewegende pixels zijn verwerkt, is bovendien vervangen door een AI-model dat volgens Nvidia veel efficiënter werkt.

Alle gebruikte algoritmes voor opschalen, Ray Reconstruction en Frame Generation worden uitgevoerd op de volgens Nvidia tweeënhalf keer zo snel geworden tensorcores. Het geheel werkt nu zo veel sneller dat het meerdere keren per frame kan worden uitgevoerd. Nvidia noemt het bestaan van een 'X4 Mode', waarbij elk gerenderd beeld wordt opgevolgd door drie gegenereerde beelden, wat suggereert dat de hoeveelheid Frame Generation instelbaar wordt.

De pacing van de frames, oftewel met welke tussenpozen de frames worden getoond, wordt natuurlijk wel aanzienlijk complexer als er meer frames worden toegevoegd. Daarom heeft Nvidia de framepacing hiervoor verplaatst van de cpu naar een hardwarematige oplossing in de displayengine op de gpu.

Ten opzichte van native rendering wordt de mogelijke prestatieboost bij DLSS 4 veel groter. Nvidia demonstreerde de techniek in Cyberpunk 2077. Op een RTX 5090 werd zonder upscaling en met volledige raytracing 28fps gehaald. Met de nieuwe Multi Frame Generation, Ray Reconstruction en upscaling in de Performance-mode, steeg dat naar 242fps. Dat is ongetwijfeld een zorgvuldig uitgezocht voorbeeld, en bij snelle bewegingen is een basisframerate van 28fps doorgaans te weinig om een goed eindresultaat te bereiken met dit soort technologieën, maar het geeft wel aan wat de gecombineerde impact van al deze DLSS-technieken kan zijn. In dit voorbeeld worden vijftien van elke zestien weergegeven pixels niet gerenderd, maar gegenereerd, oftewel bijna 94 procent.

Onveranderd is dat ontwikkelaars ondersteuning moeten inbouwen voor DLSS. Bij de release van de eerste GeForce RTX 50-videokaarten zullen 75 games en programma's ondersteuning bieden voor DLSS 4, zo belooft Nvidia. Gebruikers van oudere RTX-videokaarten kunnen wel profiteren van de verbeterde Ray Reconstruction, Super Resolution en Anti-Aliasing, volgens Nvidia in meer dan 50 games en programma's, maar niet van Multi Frame Generation; dat werkt alleen op de RTX 50-serie.

Niet alle ontwikkelaars werken de DLSS-versie even snel bij, of doen dat überhaupt. Het vervangen van de betreffende DLL-bestanden door exemplaren van nieuwere games is dan ook een veelvuldig uitgevoerde truc door fanatieke gamers. Ondersteuning hiervoor wordt ingebouwd in de officiële Nvidia-app; je kunt dan de gebruikte DLSS-versie per game overriden. Er komen losse schakelaars voor Frame Generation, de gebruikte AI-modellen en de gebruikte Super Resolution-optie.

Neuralrendering

Waar bij DLSS AI-modellen worden ingezet als alternatief voor 'echte' rendering van frames, gaat het bij alle onderdelen van de nieuwe Nvidia RTX Kit juist om het verbeteren van normale rendering met AI. Met neuralrendering zouden detailniveaus mogelijk worden die normaal gesproken niet haalbaar zijn, aldus Nvidia.

Vermoedelijk het belangrijkste onderdeel van de RTX Kit zijn de neuralshaders, waarmee kleine AI-modellen kunnen worden gebruikt binnen de programmeerbare shaders. Voor nu zijn er drie mogelijke gebruiksdoelen. Het eerste is compressie van textures, waarmee tot zeven keer zoveel vram vrij zou kunnen worden gemaakt dan met traditionele, per 'block' gecomprimeerde textures. De tweede mogelijkheid is het comprimeren van complexe shadercode voor het renderen van materialen, zoals porselein en zijde. Hiermee zou rendering van 'filmkwaliteit' in real time mogelijk moeten worden. De derde en laatste optie is het oneindig laten heen en weer gaan van lichtstralen na het uitvoeren van pathtracing, wat zowel de kwaliteit van de belichting als de snelheid waarmee die berekend kan worden ten goede moet komen.

Een ander onderdeel van neuralrendering is RTX Neural Faces, waarbij een AI-model wordt gebruikt om een gerenderd gezicht een natuurlijkere uitstraling te geven. Dat kan worden aangevuld met de RTX Character Rendering SDK voor het raytracen van haar en huid. In plaats van driehoeken worden daarvoor bolvormige afgeleiden gebruikt, wat tot betere prestaties en een lager geheugengebruik moet leiden dan bij traditionele methoden om haar te renderen. Voor een natuurlijkere, minder plasticachtige uitstraling van huid kan subsurface scattering worden gebruikt, dat de deels doorzichtige eigenschappen van (de bovenste lagen van) de menselijke huid meeneemt.

Verbeterde encoders en decoders

Zowel de encoders als de decoders voor video zijn verbeterd bij de RTX 50-serie. Zo wordt nu video met 4:2:2-kleurcompressie ondersteund, waar sommige professionele camera's in kunnen opnemen. Voor bestaande formaten meldt Nvidia een verbetering van 5 procent in de kwaliteit van het encoderen van HEVC en AV1, en een verdubbeling van de decodesnelheid van H.264. De mogelijkheden voor het gelijktijdig encoderen of decoderen kunnen wel variëren afhankelijk van de gpu. De RTX 5090 heeft drie encoders en twee decoders aan boord; de RTX 5080 heeft er twee van elk; de RTX 5070 Ti heeft twee encoders met maar één decoder; de RTX 5070 heeft er van allebei maar één.

Nvidia werkt naar eigen zeggen met onder meer Adobe, Blackmagic en Wondershare aan de integratie van de nieuwe videomogelijkheden in hun videobewerkingsprogramma's.

Voorlopige conclusie

Hoewel AMD heeft aangegeven deze generatie niet met een antwoord in het topsegment te komen, lijkt Nvidia vol gas te blijven geven op zijn vlaggenschip. De RTX 5090 is in elk geval op papier een grote stap vooruit ten opzichte van de RTX 4090, met een derde meer cores, meer geheugen en een bredere geheugenbus. Daar staat tegenover dat de generatie-op-generatieverbeteringen lager in de line-up kleiner lijken te zijn. Het verschil tussen de xx90 en xx80 was zelden zo groot; in verschillende opzichten is de RTX 5080 bijna een halve RTX 5090.

Daarnaast blijft Nvidia zwaar inzetten op DLSS, waarvan de potentiële prestatiewinst met het nieuwe Multi-Frame Generation bij deze generatie flink toeneemt. Ook de mogelijkheden voor het integreren van kleine AI-modellen in de rendershaders lijken veelbelovend. Of het in de praktijk allemaal net zo mooi is als Nvidia ons wil doen geloven, zullen we uiteraard moeten testen zodra we de nieuwe kaarten in ons eigen testlab ontvangen. Voor nu heeft Nvidia de pc-gamer, zij het die met een goedgevulde spaarpot, in elk geval iets gegeven om naar uit te kijken, waarmee het vrijwel zeker lijkt dat 2025 een veel spannender gpu-jaar wordt dan het afgelopen jaar.

:strip_exif()/i/2007169918.jpeg?f=imagenormal)

:strip_exif()/i/2007169920.jpeg?f=imagenormal)

/i/2007169922.png?f=imagenormal)

/i/2007169940.png?f=imagenormal)

:strip_exif()/i/2007170032.png?f=thumbmedium)

:strip_exif()/i/2007299416.png?f=thumbmedium)

:strip_icc():strip_exif()/i/2007272698.jpeg?f=fpa_thumb)

:strip_icc():strip_exif()/i/2007231724.jpeg?f=fpa_thumb)

:strip_icc():strip_exif()/u/87978/crop566e036cc3e24_cropped.jpeg?f=community)

/u/452542/crop57b8a2dd1446b_cropped.png?f=community)

:fill(white):strip_exif()/i/2007228152.jpeg?f=thumbmedium)

:strip_exif()/i/2007170142.png?f=thumbmedium)

:strip_exif()/i/2007171958.png?f=thumbmedium)

:fill(white):strip_exif()/i/2007284754.jpeg?f=thumbmedium)

:strip_exif()/i/2007170048.png?f=thumbmedium)

:strip_exif()/i/2007170526.png?f=thumbmedium)

:strip_exif()/i/2007172024.webp?f=thumbmedium)

:fill(white):strip_exif()/i/2007219520.jpeg?f=thumbmedium)

:strip_exif()/i/2007170020.png?f=thumbmedium)

:strip_exif()/i/2007170138.png?f=thumbmedium)

:fill(white):strip_exif()/i/2007219670.jpeg?f=thumbmedium)

:strip_exif()/i/2007170816.png?f=thumbmedium)

:strip_exif()/i/2007176202.png?f=thumbmedium)

:strip_exif()/i/2007170350.png?f=thumbmedium)

:strip_exif()/i/2007170322.png?f=thumbmedium)

:fill(white):strip_exif()/i/2007214330.jpeg?f=thumbmedium)

:strip_exif()/i/2007170124.png?f=thumbmedium)

:strip_exif()/i/2007176278.png?f=thumbmedium)

:strip_exif()/i/2007176240.png?f=thumbmedium)

:strip_exif()/i/2007170378.png?f=thumbmedium)

:strip_exif()/i/2007172350.png?f=thumbmedium)

:fill(white):strip_exif()/i/2007228056.jpeg?f=thumbmedium)

:fill(white):strip_exif()/i/2007288972.jpeg?f=thumbmedium)

:strip_exif()/i/2007299538.png?f=thumbmedium)

:fill(white):strip_exif()/i/2007288988.jpeg?f=thumbmedium)

:strip_exif()/i/2007170478.png?f=thumbmedium)

:strip_exif()/i/2007170288.png?f=thumbmedium)

:strip_exif()/i/2007176320.png?f=thumbmedium)

:fill(white):strip_exif()/i/2007486728.jpeg?f=thumbmedium)

:strip_exif()/i/2007171922.png?f=thumbmedium)

:strip_exif()/i/2007172326.png?f=thumbmedium)

:fill(white):strip_exif()/i/2007289380.jpeg?f=thumbmedium)

:strip_exif()/i/2007172476.png?f=thumbmedium)

:fill(white):strip_exif()/i/2007299554.jpeg?f=thumbmedium)

:fill(white):strip_exif()/i/2007284870.jpeg?f=thumbmedium)

:strip_exif()/i/2007170700.png?f=thumbmedium)

:strip_exif()/i/2007171236.png?f=thumbmedium)

:fill(white):strip_exif()/i/2007289016.jpeg?f=thumbmedium)

:strip_exif()/i/2007172270.png?f=thumbmedium)

:strip_exif()/i/2007387488.png?f=thumbmedium)

:fill(white):strip_exif()/i/2007219846.jpeg?f=thumbmedium)

:strip_exif()/i/2007170084.png?f=thumbmedium)

:fill(white):strip_exif()/i/2007170680.jpeg?f=thumbmedium)

:strip_exif()/i/2007170626.png?f=thumbmedium)

:strip_exif()/i/2007171228.png?f=thumbmedium)

:fill(white):strip_exif()/i/2007289030.jpeg?f=thumbmedium)

:strip_exif()/i/2007171984.png?f=thumbmedium)

:strip_exif()/i/2007284328.png?f=thumbmedium)

:strip_exif()/i/2007171950.png?f=thumbmedium)

:strip_exif()/i/2007170222.png?f=thumbmedium)

:strip_exif()/i/2007172146.png?f=thumbmedium)

:strip_exif()/i/2007172000.png?f=thumbmedium)

:strip_exif()/i/2007170862.png?f=thumbmedium)

:fill(white):strip_exif()/i/2007170164.jpeg?f=thumbmedium)

:strip_exif()/i/2007299412.png?f=thumbmedium)

:strip_exif()/i/2007299390.png?f=thumbmedium)

:strip_exif()/i/2007172086.png?f=thumbmedium)

:strip_exif()/i/2007172050.png?f=thumbmedium)

:strip_exif()/i/2007170724.png?f=thumbmedium)

:strip_exif()/i/2007172336.webp?f=thumbmedium)

:strip_exif()/i/2007172038.png?f=thumbmedium)

:strip_exif()/i/2007170642.png?f=thumbmedium)

:strip_exif()/i/2007170640.png?f=thumbmedium)

:strip_exif()/i/2007170154.png?f=thumbmedium)

:strip_exif()/i/2007170146.png?f=thumbmedium)

:strip_exif()/i/2007489532.png?f=thumbmedium)

:strip_exif()/i/2007172324.webp?f=thumbmedium)

:strip_exif()/i/2007172330.webp?f=thumbmedium)

:strip_exif()/i/2007172022.webp?f=thumbmedium)

:fill(white):strip_exif()/i/2007228214.jpeg?f=thumbmedium)

:fill(white):strip_exif()/i/2007228198.jpeg?f=thumbmedium)

:strip_exif()/i/2007170140.png?f=thumbmedium)

:strip_exif()/i/2007299550.png?f=thumbmedium)

:strip_exif()/i/2007284746.png?f=thumbmedium)

:strip_exif()/i/2007171232.png?f=thumbmedium)

:strip_exif()/i/2007284676.png?f=thumbmedium)

:strip_exif()/i/2007217890.png?f=thumbmedium)

:strip_exif()/i/2007284750.png?f=thumbmedium)

:strip_exif()/i/2007172374.png?f=thumbmedium)

:strip_exif()/i/2007172424.png?f=thumbmedium)

:strip_exif()/i/2007172118.png?f=thumbmedium)

:strip_exif()/i/2007170766.png?f=thumbmedium)

:strip_exif()/i/2007170790.png?f=thumbmedium)

:strip_exif()/i/2007489866.png?f=thumbmedium)

:strip_exif()/i/2007487762.png?f=thumbmedium)

:strip_exif()/i/2007299508.png?f=thumbmedium)

:strip_exif()/i/2007299524.png?f=thumbmedium)

:strip_exif()/i/2007172286.png?f=thumbmedium)

:fill(white):strip_exif()/i/2007264372.jpeg?f=thumbmedium)

:strip_exif()/i/2007171976.png?f=thumbmedium)

:strip_exif()/i/2007284512.png?f=thumbmedium)

:strip_exif()/i/2007170468.png?f=thumbmedium)

:strip_exif()/i/2007170498.png?f=thumbmedium)

:strip_exif()/i/2007170100.png?f=thumbmedium)

:strip_exif()/i/2007169968.png?f=thumbmedium)

:strip_exif()/i/2007169978.png?f=thumbmedium)

:strip_exif()/i/2007169970.png?f=thumbmedium)

:strip_exif()/i/2007172210.png?f=thumbmedium)

:strip_exif()/i/2007172188.png?f=thumbmedium)

:fill(white):strip_exif()/i/2007284828.jpeg?f=thumbmedium)

:fill(white):strip_exif()/i/2007284800.jpeg?f=thumbmedium)

:fill(white):strip_exif()/i/2007170644.jpeg?f=thumbmedium)

:fill(white):strip_exif()/i/2007170198.jpeg?f=thumbmedium)

:strip_icc():strip_exif()/i/2007216712.jpeg?f=fpa_thumb)

:strip_icc():strip_exif()/i/2007203526.jpeg?f=fpa_thumb)

:strip_icc():strip_exif()/i/2007162466.jpeg?f=fpa_thumb)

/i/2004919460.png?f=fpa)

/i/2004695548.png?f=fpa)

:strip_exif()/i/2007273460.jpeg?f=fpa)

:strip_exif()/i/2007169962.jpeg?f=fpa)