Intel heeft dinsdag openhartig met de pers gepraat over verschillende toekomstige producten, waaronder de Xeon MP Dunnington, de langverwachte Nehalem en zelfs diens verre opvolger 'Sandy Bridge'.

Dunnington

Dunnington

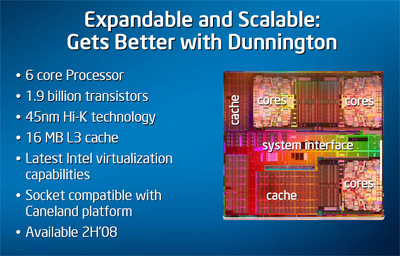

De 45nm Xeon voor servers met vier of meer sockets is een indrukwekkende chip: zijn 1,9 miljard 45nm-

Nehalem

Nehalem

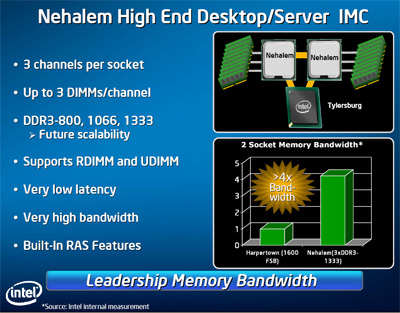

Intels tweede generatie 45nm-ontwerp kent een groot aantal verbeteringen ten opzichte van de eind 2007 geïntroduceerde Penryn. De belangrijkste daarvan waren al bekend: een geheugencontroller met drie kanalen ddr3 voedt ieder socket direct met tot 32GB/s aan bandbreedte, Quickpath-interconnects vervangen de fsb, HyperThreading is terug van weggeweest en bepaalde modellen krijgen een ingebouwde videochip. Verder was al bekend dat Nehalem zeven nieuwe sse4-

Bij deze punten houdt het echter nog niet op: om de efficiëntie verder op te schroeven kan Nehalem-core intern meer balletjes tegelijk hooghouden dan een Penryn-core: 128 in plaats van 96 µops. Het opvragen van niet optimaal gerangschikte data is sneller, net als het synchronizeren van threads. Er is een tweede branch predictor toegevoegd en een extra TLB-cache met ruimte voor 512 adressen. De nieuwe 'Renamed Return Stack Buffer' moet sprongen tussen verschillende functies sneller maken, terwijl de 'Extended Page Table' gaat helpen bij virtualisatie. Ook zijn de prefetchers en geheugentoegang verder geoptimaliseerd.

Nehalem krijgt een nieuwe cache-architectuur die bestaat uit 64KB L1-cache en 256KB L2-cache voor iedere core, aangevuld door 8MB gedeeld L3-cache. De Quickpath-links zullen maximaal 25,6GB/s per stuk leveren op een kloksnelheid van 6,4GHz, maar er is in de geruchtenmolen sprake geweest van een oorspronkelijke snelheid van 'slechts' 4,8GHz oftewel 19,2GB/s.

Sandy Bridge

Sandy Bridge

Met name opvallend aan de presentatie is dat Intel ook al details heeft vrijgegeven over Sandy Bridge. De opvolger van Nehalem is de 32nm Westmere. Sandy Bridge is dáár weer de opvolger van en zal op zijn vroegst eind 2010 verschijnen. Het bedrijf wil echter nu al laten weten dat deze chip weer een grote sprong voorwaarts zal zijn, in ieder geval op het gebied van floating point: de 128bits sse-eenheden van Core 2 Duo zullen dan vervangen worden voor 256bits eenheden en er worden instructies toegevoegd om het rekenen met deze langere vectoren makkelijker te maken. Intel noemt dit AVX: Advanced Vector Extension. Dezelfde instructies zullen wellicht ook benut worden door Larrabee, de hybride processor/videochip met meer dan een teraflop rekenkracht die in 2009 op de markt wordt verwacht.

/i/1270023761.png?f=fpa)

/i/1242207182.png?f=fpa)

/i/1246884910.png?f=fpa)

/i/1221502237.png?f=fpa)

/i/1212928088.png?f=fpa)

/i/1217843384.png?f=fpa)

/i/1215543822.png?f=fpa)

:strip_exif()/i/1191969624.jpg?f=fpa)

/i/1212686472.png?f=fpa)

:strip_exif()/i/1190152699.gif?f=fpa)

:strip_exif()/i/1178274684.jpg?f=fpa)

:strip_exif()/i/1060771143.gif?f=fpa)