In de aanloop naar de Siggraph 2008, een conferentie voor computergegenereerde grafische effecten, heeft Intel details vrijgegeven over zijn Larrabee-chip. De eerste producten op basis van de chip zullen high-end-videokaarten zijn.

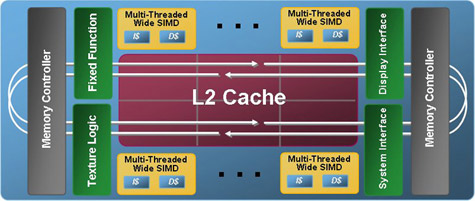

Hoewel de huidige videokaarten van AMD en Nvidia tot op zekere hoogte programmeerbaar zijn via shaders, introduceert Intel met zijn Larrabee een geheel nieuw gpu-ontwerp. Larrabee is volgens een artikel op Extremetech opgebouwd uit een niet nader genoemde hoeveelheid x86-cores, gebaseerd op een variant van de originele Pentium-architectuur, die twee instructies per klokcyclus in vaste volgorde kunnen verwerken. Het L1-cache van de kernen is uitgesplitst in een 32KB instructie-cache en een even grote data-cache, terwijl het L2-cache 256KB groot is. Elke x86-core wordt bijgestaan door een vectoreenheid die 16 32bit-instructies kan verwerken.

Niet al het grafische werk wordt door general purpose-chips gedaan: uit praktische overwegingen heeft Intel besloten om de textuureenheden een vaste functie mee te geven. Deze eenheden vormen geen onderdeel van het belangrijkste deel van de grafische pijplijn, maar zijn er wel mee verbonden via een 512bit-tweewegs-ringbus waar ook de geheugencontroller op zit. De textuureenheden kunnen wel de caches benaderen van de x86-kernen.

Volgens Intel heeft de bijzondere, flexibele architectuur van de Larrabee als voordeel dat de chip goed presteert bij games met zeer veel polygonen of die veel grafische rekenkracht vergen van de shaderunits. Ook kan de architectuur volgens Intel lineair schalen met het aantal rekeneenheden, waardoor Intel verschillende segmenten in de grafische markt kan bedienen.

De Larrabee-architectuur grijpt vreemd genoeg terug op 'tile-rendering', dat in de beginjaren van de 3D-videokaarten vooral gebruikt is door Powervr, alleen noemt Intel het bin-rendering. Elke frame wordt opgedeeld in honderden kleine vierkantjes, in de 256KB L2-cache is 128 bij 128 pixels waarschijnlijk de meest optimale opdeling, die worden gevoerd aan de chipkernen. Die bepalen eerst de zichtbare pixels van een tile en slaan die op in een speciale buffer, die Intel 'Bin Set' noemt. Vandaar dat Intel ook spreekt van bin-rendering.

Intel claimt dat de Larrabee, ondanks de afwijkende architectuur, volledig compatibel is met Directx en Opengl, maar de vraag is hoe goed Intel de drivers werkend weet te krijgen met huidige en toekomstige games. Intel heeft namelijk geen beste staat van dienst wat betreft driver-ondersteuning voor de igp's van zijn chipsets. Ontwikkelaars kunnen ook direct de Larrabee-hardware benaderen via C- of C++-code.

/i/1244101699.png?f=fpa)

/i/1242207182.png?f=fpa)

/i/1239375893.png?f=fpa)

/i/1204897246.png?f=fpa)

/i/1212928088.png?f=fpa)

/i/1215680017.png?f=fpa)

/i/1213953071.png?f=fpa)

/i/1194863299.png?f=fpa)