De eerste Intel-processors gebaseerd op de nieuwe Nehalem-architectuur zullen volgend jaar geïntroduceerd worden. De modellen met een geïntegreerde videocore zullen een jaartje later, in 2009, verschijnen.

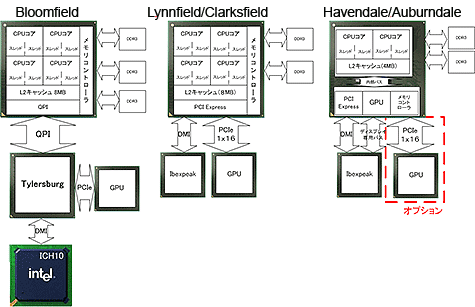

De eerste Nehalem-processor, met de codenaam Bloomfield, wordt verwacht in het vierde kwartaal van 2008 en zal gemaakt worden met het 45nm-procedé. De cpu zal beschikken over vier cores die via QuickPath-links met elkaar communiceren. Aanwezig is 8MB L2-cachegeheugen en een triplechannel ddr3-geheugencontroller. De cpu zal gecombineerd worden met de Tylersburg-northbridge die zorg draagt voor de pci express 2.0-bus en de ICH10-southbridge.

In de eerste helft van 2009 komt de Lynnfield-cpu op de markt die net als Bloomfield uitgerust is met vier cores, maar daarnaast ook beschikt over een geïntegreerde pci express-interface. De cpu wordt gecombineerd met één i/o-chip, de Ibexpeak, die via de dmi-bus aan de processor wordt gehangen. Lynnfield krijgt een dualchannel geheugencontroller en een voetje met 1160 pinnen, minder dan de 1366 pinnen van Bloomfield. De op dezelfde architectuur gebaseerde Clarksfield moet de mobiele markt bedienen en krijgt een socket met 989 pinnen.

In de eerste helft van 2009 komt de Lynnfield-cpu op de markt die net als Bloomfield uitgerust is met vier cores, maar daarnaast ook beschikt over een geïntegreerde pci express-interface. De cpu wordt gecombineerd met één i/o-chip, de Ibexpeak, die via de dmi-bus aan de processor wordt gehangen. Lynnfield krijgt een dualchannel geheugencontroller en een voetje met 1160 pinnen, minder dan de 1366 pinnen van Bloomfield. De op dezelfde architectuur gebaseerde Clarksfield moet de mobiele markt bedienen en krijgt een socket met 989 pinnen.

In de eerste helft van 2009 komt ook de Havendale ten tonele, die niet alleen een geïntegreerde pci express-interface heeft, maar ook een geïntegreerde gpu. Havendale is een dualcoreprocessor met 4MB L2-cachegeheugen en een dualchannel ddr3-controller. De chip heeft hetzelfde voetje als de Lynnfield en maakt ook gebruik van de Ibexpeak-chip voor de i/o. De mobiele variant hiervan gaat door het leven onder de codenaam Auburndale.

In de tweede helft van 2009 zal de volgende generatie processors verschijnen die gebakken zijn met een 32nm- in plaats van 45nm-procedé. De codenaam van deze familie is Westmere. Verwacht wordt dat ook AMD in 2009 de eerste processors zal leveren met geïntegreerde graphics, maar in tegenstelling tot Intel zal AMD de Fusion-cpu's initieel alleen richten op notebookmarkt.

/i/1204897246.png?f=fpa)

:strip_exif()/i/1223915640.gif?f=fpa)

/i/1157717307.png?f=fpa)

/i/1210582630.png?f=fpa)

/i/1194863299.png?f=fpa)

:strip_exif()/i/1144679778.jpg?f=fpa)

:strip_exif()/i/1178274684.jpg?f=fpa)

:strip_exif()/i/1060771143.gif?f=fpa)