AMD gaat het aantal cores in zijn serverprocessors drastisch opvoeren van de vier die de Barcelona momenteel bevat naar twaalf in de 'Magny-Cours' die in 2010 moet verschijnen.

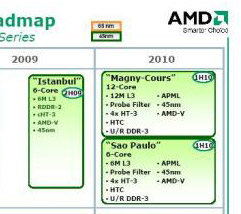

De vrijgegeven nieuwe serverroadmap van AMD toont nog meer nieuwtjes. Randy Allen, hoofd van AMD's server- en workstationdivisie, maakte de nieuwe roadmap 7 mei bekend tijdens een conference call. Tot en met 2008 zijn er geen grote wijzigingen in de bestaande plannen. Zo zal eind 2008 AMD's eerste 45nm-quadcore Shanghai-processor worden uitgebracht. Interessant wordt het in 2009. De geplande achtcore 'Montreal'-chip, bestaande uit twee aan elkaar gesmeedde Shangai-quadcores, is verdwenen uit de lijst met serverchips, terwijl de Istanbul met zes kernen en 6MB L3-cache is toegevoegd. Deze moet het in de tweede helft van 2009 opnemen tegen Intels zesklapper Dunnington.

De echt grote wijzigingen komen in de eerste helft van 2010. Niet alleen zal dan de Sao Paulo, een verbeterde versie van de Istanbul met zes kernen verschijnen, maar we zien dan ook de Magny-Cours het podium betreden met twaalf cores en 12MB aan L3-cache. Dit laatste model bestaat uit twee Sao Paulo-dies op één processor. De Magny-Cours en de Sao Paulo hebben vier Hypertransport 3.0-links, tegenover drie in de Barcelona, Shanghai en Istanbul. Daarnaast zijn de twee voorzien van een 'probe filter', waardoor er minder verkeer tussen de caches van de processorkernen nodig is om cache coherency te behouden. Onbekend is van hoeveel L2-cache de cores voorzien zijn. De Magny-Cours en Sao Paulo maken gebruik van ddr3-geheugen.

Verder blijkt uit AMD's blauwdruk dat het bedrijf de serverchipsets van Nvidia verruilt voor modellen van eigen makelij en dat de Magny-Cours en de Sao Paulo gebruikmaken van een nieuwe processorvoet met de codenaam 'Maranello', voorheen bekend onder de naam 'Piranha'. In 2010 zullen de serverchips van AMD de 35nm Westmere-processor van Intel tegenover zich treffen en misschien wel de Larrabee met een onbekende hoeveelheid cores. Het is onbekend wanneer AMD de Bulldozer-kern in zijn server- of desktopchips zal introduceren.

Update: Het lijkt erop dat het nieuws van gisteren over de Hydra-serverchip met acht kernen met de bekendmaking van de nieuwe roadmap niet juist is gebleken.

:strip_icc():strip_exif()/i/1232559082.jpeg?f=fpa_thumb)

/i/1253627114.png?f=fpa)

/i/1270023761.png?f=fpa)

/i/1241443636.png?f=fpa)

/i/1246536704.png?f=fpa)

/i/1207774563.png?f=fpa)

/i/1212484803.png?f=fpa)

/i/1208251199.png?f=fpa)

:strip_exif()/i/1163641880.gif?f=fpa)

/i/1219230359.png?f=fpa)

/i/1194863299.png?f=fpa)