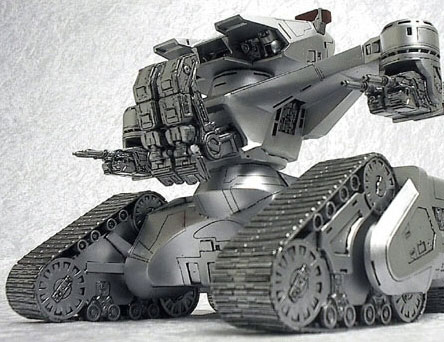

Het leger en de marine van de Verenigde Staten maken in toenemende mate gebruik van robots op het slagveld. Naarmate de robots meer autonomie verkrijgen, rijzen er ethische vragen rond het gebruik van de geautomatiseerde soldaten.

Vooralsnog worden de robots nog door mensen op afstand bestuurd, maar de zelfstandigheid van de toestellen neemt toe. Nu zullen het ook bij toenemende autonomie voorlopig nog mensen zijn die de beslissing nemen al dan niet de trekker over te halen, maar ook aan robots met grotere beslissingsbevoegdheden wordt hard gewerkt. Militaire onderzoekers werken aan robots die bijvoorbeeld zelfstandig een doelwit kunnen identificeren en die vervolgens aan de hand van de dreiging kunnen bepalen welk doelwit als eerste wordt aangevallen en welke munitie gebruikt moet worden. Een doembeeld in de richting van Terminator-achtige taferelen, waarin robots alle mensen structureel afslachten, is in dat geval niet ver weg meer.

Hoewel de praktijk minder bedreigend is, houdt het Amerikaanse ministerie van Defensie zich wel al bezig met ethische kwesties rond de inzet van een robotleger. Daarbij heeft de Amerikaanse marine de hulp ingeroepen van een Britse filosoof, die zijn expertise zal aanwenden om te helpen bij het ontwerp van gedragsregels voor robots. Zo zullen de machines conform de Geneefse conventie moeten strijden, wat onder meer betekent dat ze geen wraakacties mogen uitvoeren en mensen niet mogen martelen. Ook het Amerikaanse leger heeft derden ingeschakeld, nu in de vorm van een computerwetenschapper die meewerkt aan de ontwikkeling van software voor autonome robots.

Onderzoek heeft aangetoond dat Amerikaanse soldaten aan het Iraakse front meer dan eens marteling en wraakacties goedkeuren; een robot zou daar niet toe in staat zijn. Ook ontbreekt bij robots de noodzaak zichzelf te beschermen, zelfs al zou dat gezien de prijs van de hardware wel wenselijk zijn. Daarmee zouden robots ethischer dan mensen zijn, ook al beschikken ze uiteraard niet over de mogelijkheid tot reflectie.

/i/1348829391.png?f=fpa)

:strip_exif()/i/1098602434.jpg?f=fpa)

:strip_exif()/i/1262011607.gif?f=fpa)

/i/1248683747.png?f=fpa)

/i/1241947381.png?f=fpa)

/i/1247313738.png?f=fpa)

/i/1244714496.png?f=fpa)

/i/1242812802.png?f=fpa)

/i/1238835747.png?f=fpa)

/i/1223118312.png?f=fpa)

/i/1239449892.png?f=fpa)

/i/1238771248.png?f=fpa)

/i/1237743909.png?f=fpa)

/i/1237295728.png?f=fpa)

/i/1233158120.png?f=fpa)

/i/1198048718.png?f=fpa)

/i/1206275722.png?f=fpa)