Justin Rattner, Intel Senior Fellow and Director Corporate Technology Group, heeft in zijn keynote op het Intel Developer Forum een kijkje in de toekomst gegeven. Deze toekomst bestaat volgens Intel uit processors met meerdere cores en virtuele platforms. Daarnaast zouden chips in de toekomst niet meer met elektrische signalen, maar met licht met elkaar communiceren.

![]() Virtuele platformen

Virtuele platformen

Een virtueel platform is het beste te vergelijken met VMWare. Deze software maakt het mogelijk om een virtuele computer te creëren die zijn eigen besturingssysteem draait. Op dit moment is de oplossing nog steeds geheel in software geïmplementeerd, maar in de toekomst moet de hardware een virtueel platform ook mogelijk maken. Een eerste stap in die richting is Virtualisation Technologie (Vanderpool) die hardwarematige ondersteuning voor virtuele platformen in processors mogelijk maakt. Net zoals met VMWare kan een processor met behulp van deze techniek meerdere besturingssystemen tegelijkertijd draaien. Volgens Intel is dit niet alleen nuttig voor bedrijven, die op een server meerdere besturingssystemen willen draaien, maar ook voor de gebruiker thuis. Met behulp van Vanderpool en bijvoorbeeld een USB-stick zou deze op een andere computer zijn eigen besturingssysteem kunnen draaien en in zijn eigen vertrouwde omgeving kunnen werken. Intel demonstreerde deze technologie en liet ook zien dat het mogelijk is om een virtuele videokaart te maken. Intel heeft ook plannen om virtualisatie voor opslag en netwerken toe te passen.

![]() Many-core

Many-core

De toekomst is volgens Intel natuurlijk het gebruik van meerdere cores op een processor. In de nabije toekomst zullen dit er twee zijn. Later worden dat er vier of acht, maar de kans is groot dat dit er tientallen zijn in het jaar 2015. Hoewel dit op het eerste gezicht een goede methode lijkt om de snelheid van processors te verhogen, brengt het ook een aantal problemen met zich mee. Als eerste is het veel moeilijker om een programma te schrijven dat gebruikt maakt van meerdere processors. Daarnaast zal de honger naar geheugenbandbreedte die de cores gezamenlijk hebben, gestild moeten worden.

Om het eerste probleem aan te pakken werkt Intel aan nieuwe programmeertalen voor specifieke toepassingen. Met behulp van deze nieuwe talen zou het makkelijker moeten zijn om parallelle code te schrijven. Een nieuwe programmeertaal vereist ook een nieuwe compiler, waar Intel dus ook aan werkt. In de toekomst moet deze combinatie het dus mogelijk maken om makkelijker multi-threaded applicaties te schrijven, waarbij elke thread op een aparte core kan draaien.

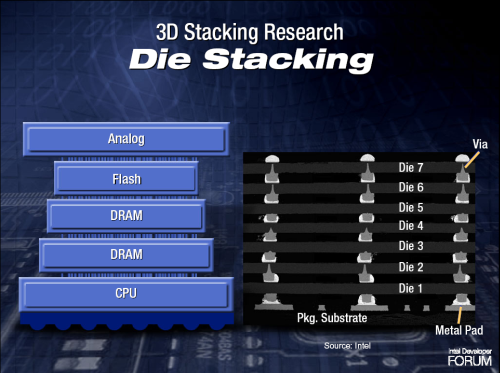

Voor het tweede probleem komt Intel met een combinatie van oplossingen. Naast een eigen cache voor elke core krijgt de processor ook een gezamenlijk cache dat gebruikt kan worden door alle cores. Dit lost echter maar een gedeelte van het probleem op, want uiteindelijk zullen de gegevens toch uit het geheugen moeten komen. Er is dus meer bandbreedte voor de FSB nodig. Dit kan bereikt worden door de processor te voorzien van meer pinnen, maar die kant wil Intel eigenlijk niet op. Projecties geven namelijk aan dat er alleen al voor de gegevens 600 tot 1800 pinnen in de toekomst nodig zijn. Hier moeten dan ook nog de pinnen voor de energievoorziening worden bijgeteld. Intel kijkt daarom of het niet mogelijk is om de processor met het geheugen te combineren. Met behulp van 3D wafer stacking kan bijvoorbeeld een complete DRAM-wafer bovenop een processor-wafer worden geplaatst die doormiddel van miljoenen contactpunten met elkaar verbonden kunnen worden. Dit is echter niet echt flexibel. Daarom kijkt Intel ook naar de mogelijkheden van 3D die-stacking, waarbij losse chips in plaats van wafers op elkaar worden geplaatst in dezelfde behuizing.

![]() Chip-to-chip communicatie

Chip-to-chip communicatie

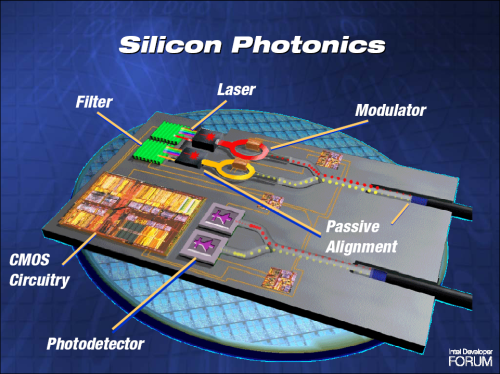

Niet alleen de processor zal in de toekomst behoefte hebben aan een enorme bandbreedte. Ook chips zullen in de toekomst steeds sneller met elkaar moeten kunnen communiceren. Op dit moment worden daar nog steeds elektrische signalen voor gebruikt, maar hier zijn een aantal problemen mee. Zo zijn elektrische signalen nogal gevoelig voor storing. Licht is dat echter niet en Intel werkt er dan ook hard aan om ervoor te zorgen dat chips in de toekomst via lichtsignalen met elkaar kunnen 'praten'. Hiervoor moeten de chips wel worden uitgerust met een laser om te zenden en een lichtgevoelige diode of transistor om te ontvangen. Op dit gebied ligt Intel ver voor op de concurrentie, getuige een grote doorbraak eerder dit jaar met de realisatie van de eerste silicium laser.

/i/1109766014.png?f=fpa)