ATi heeft vandaag zijn langverwachte nieuwe generatie videochips gepresenteerd, de Radeon X1000-serie. Deze reactie op de in juni geïntroduceerde GeForce 7800 GTX heeft een aantal maanden op zich laten wachten omdat er serieuze problemen waren met de chips: samples hadden namelijk de vervelende eigenschap om spontaan dood te gaan. Na lang zoeken werd het probleem getraceerd naar een fout in een blok van het ontwerp dat van een ander bedrijf was gekocht. Eenmaal gelokaliseerd kon het probleem binnen een uur worden opgelost, en schoten de yields omhoog naar het gewenste niveau. De massaproductie kon dus worden gestart, en vandaag zijn de specificaties en eerste resultaten wereldkundig gemaakt.

Het topmodel van de R520-generatie bestaat uit liefst 320 miljoen transistors, die met behulp van TSMC's 90nm-technologie in een chip van 288mm² worden gestopt. Er zijn zestien pixel pipelines en acht vertex shader units aan boord in het topmodel, die hun werk op een klok van 625MHz doen. Dit wordt ondersteund door 1,5GHz GDDR3-geheugen. Het ontwerp van de chip is flink onder handen genomen sinds de vorige generatie. Hoewel er zoals verwacht geen extra pipelines zijn toegevoegd zijn er genoeg features en prestatieverbeteringen aangebracht om een zeer geschikte concurrent voor de GeForce 7800 GTX neer te zetten.

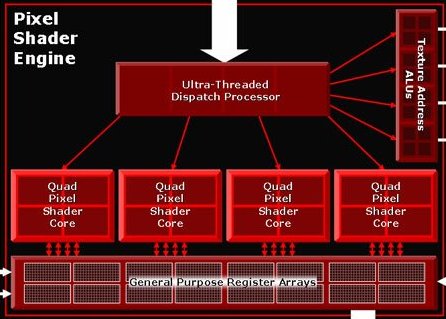

![]() Ultra-Threaded Dispatch Processor

Ultra-Threaded Dispatch Processor

Een nieuwe kreet van ATi is 'Ultra-Threaded Dispatch Processor'. Dit deel van het ontwerp is verantwoordelijk voor het verdelen van wachtende pixelbewerkingen tussen de verschillende pipelines. Een thread in deze context is niet hetzelfde als die van een CPU, maar wordt door ATi gedefinieerd als zijnde een blok van zestien pixels. Als een blok tijdelijk niet verwerkt kan worden (bijvoorbeeld omdat er gewacht moet worden op het laden van texture) kan de pipeline in plaats van te wachten meteen aan een ander blok gaan werken. nVidia gebruikt een soortgelijke techniek, maar werkt met blokken van 1024 pixels. De kleinere 'threads' van ATi leveren volgens het bedrijf een voordeel op het gebied van efficiëntie op, vooral als er gebruik gemaakt wordt van de features in Shader Model 3.0. De topmodellen van de serie zullen 512 'threads' tegelijk kunnen verwerken, maar de goedkopere zijn beperkt tot 128 threads.

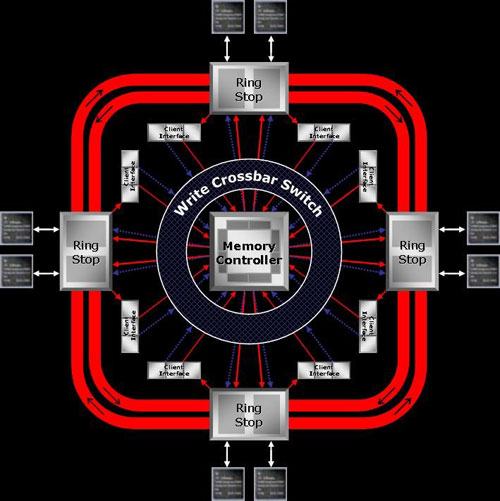

![]() Verbeterde geheugencontroller

Verbeterde geheugencontroller

De geheugencontroller van de R520 is volledig vernieuwd. In plaats van vier 64-bits controllers die met een crossbar verbonden zijn is men nu overgestapt op een centrale arbiter die twee interne bussen bestuurt. Deze bussen lopen als een spoorbaan in tegenovergestelde richting om te core heen. Datapakketjes kunnen op een van de vier tussenstations in- en uitstappen en ervoor kiezen om linksom of rechtsom te gaan, afhankelijk van wat de korste weg is. Het nieuwe geheugensysteem moet een aantal generaties meegaan: het is voorbereid op de GDDR4-standaard en effectieve snelheden tot 3,6GHz. Naast de snellere geheugencontroller heeft ATi de caches op de chip verbeterd en de compressie van textures en dieptegegevens sterker gemaakt, zodat er bandbreedte gespaard wordt.

![]() Beeldkwaliteit

Beeldkwaliteit

Naast ondersteuning voor Shader Model 3.0 biedt de R520 verbeteringen op het gebied van anisotropic filtering en anti-aliasing. 6xAA is volgens ATi op de nieuwe Radeon minder zwaar dan 4xAA op de huidige generatie. Ook is de combinatie van HDR met AA nu mogelijk en wordt een nieuw algoritme (Adaptive AA) geïntroduceerd dat rekening houdt met het alphakanaal (transparantie).

![]() De kaarten

De kaarten

Nu we weten hoe de kaarten technisch in elkaar steken is het de hoogste tijd om te kijken naar de zeven verschillende kaarten die ATi vandaag heeft aangekondigd:

| Radeon | X1800 XT | X1800 XL | X1600 XT | X1600 Pro | X1300 Pro | X1300 | X1300 HM |

|---|---|---|---|---|---|---|---|

| Core | R520 | RV530 | RV515 | ||||

| Vertex shaders | 8 | 5 | 2 | ||||

| Pixel pipelines | 16 | 12 | 4 | ||||

| Texture units | 16 | 4 | 4 | ||||

| Render outputs | 16 | 4 | 4 | ||||

| Z-units | 16 | 8 | 4 | ||||

| 'Threads' | 512 | 128 | 128 | ||||

| Coreklok | 625MHz | 500MHz | 590MHz | 500MHz | 600MHz | 450MHz | 450MHz |

| Geheugenklok | 1,5GHz | 1GHz | 1,38GHz | 680MHz | 800MHz | 500MHz | 1GHz |

| Geheugenbus | 256 bit | 128 bit | 128 bit | 32 bit | |||

| Memory Size | 256/512MB | 256MB | 128/256MB | 256MB | 128/256MB | 32MB | |

| Prijs | $499/$549 | $449 | $199/$249 | $149/$199 | $149 | $99/$129 | $79 |

Opvallend is dat er op dit moment nog geen CrossFire-edities zijn aankondigd. Deze worden later nog wel verwacht en zullen 50 dollar duurder zijn dan de normale edities. De R520 zal een betere versie van de techniek ondersteunen dan de huidige kaarten: de maximale resolutie gaat omhoog naar 2048x1536@70Hz en de prestaties van Super AA zullen volgens ATi ook een stuk beter worden.

![]() Benchmarks en conclusies

Benchmarks en conclusies

Er zijn al verschillende reviews van de nieuwe kaarten op het web verschenen, en ze zijn het er allemaal over eens dat ATi met de X1800 XT de GeForce 7800 GTX verslaat. Hoewel het traditionele zwakke punt van de Radeon (OpenGL) niet is aangepakt, is het verliezen van de Doom3-test voor weinig reviewers een reden om de superioriteit van de R520-chip in twijfel te trekken. De hoge kloksnelheid zorgt er wel voor dat de ATi-kaart een watt of 25 minder zuinig is dan zijn directe concurrent, maar door de stille dual-slot koeler is dat in de praktijk verder niet storend. Waar veel reviewers wel vraagtekens bij zetten is de beschikbaarheid van het topmodel. ATi belooft dat de kaart over 4 tot 6 weken in de winkels zal liggen, maar erg blij met weer een papieren introductie zijn sommige reviewers niet, zeker niet na de directe beschikbaarheid van de GeForce 7800 GTX en ATi's recente historie van leveringsproblemen.

Hoewel ATi zonder veel twijfel de kroon terugpakt met zijn topmodel, wordt de echte strijd in het middensegment van de markt uitgevochten. De meeste reviews richten zich vooral op de X1800 XT, maar er zijn ook al een aantal tests van de X1600 XT en de X1800 XL verschenen, die het tegen de GeForce 6800 en GeForce 7800 GT moeten opnemen. Op die twee punten komt ATi minder overtuigend uit de bocht, en zal uiteindelijk veel afhangen van zaken als de beschikbaarheid en prijzen.

| 2x GeForce 7800 GTX | |||

| 2x GeForce 7800 GT | |||

| 2x Radeon X850 XT | |||

| 2x GeForce 6800 Ultra | |||

| Radeon X1800 XT | |||

| GeForce 7800 GTX | |||

| GeForce 7800 GT | |||

| Radeon X1800 XL | |||

| Radeon X850 XT | |||

| GeForce 6800 Ultra | |||

| GeForce 6800 | |||

| Radeon X1600 XT | |||

![]() Reviews

Reviews

- Beyond3D (aanrader voor de technische kant)

- [H]ardOCP

- FiringSquad

- TechReport

- PC Perspective

- Tbreak

- Hexus.net

- DriverHeaven

- Guru3D