Hoewel een groot deel van de specificaties al eerder het internet op was gelekt, is vanmiddag pas de NDA gevallen die rustte op de details, foto's en benchmarks van nVidia's NV40 GPU, waarna onmiddelijk enkele tientallen sites hun bevindingen online zetten. nVidia probeert al sinds de introductie van de Radeon 9700 in de zomer van 2002 de performancekroon van ATi terug te pakken. De NV3x-serie werd geteisterd door productieproblemen, verkeerde keuzes tijdens de ontwerpfase en optimalisaties die ten koste gingen van de beeldkwaliteit om de performance in de buurt van de concurrentie te houden. Met NV40 wil nVidia duidelijk een nieuwe start maken: het "FX" achtervoegsel is gedumpt en het bedrijf heeft de sterke punten van NV3x overgenomen, nieuwe features toegevoegd en hier en daar wat technieken geleend van ATi om de prestaties en beeldkwaliteit van de chip te verbeteren. De hoofdarchitect van 3dfx' Rampage heeft bovendien een belangrijke rol gespeeld bij het ontwikkelen van bepaalde delen van NV40. Daarnaast is men van foundry veranderd; in plaats van TSMC is er een deal met IBM gesloten voor de productie van de 222 miljoen transistors tellende core.

![]() Architectuur

Architectuur

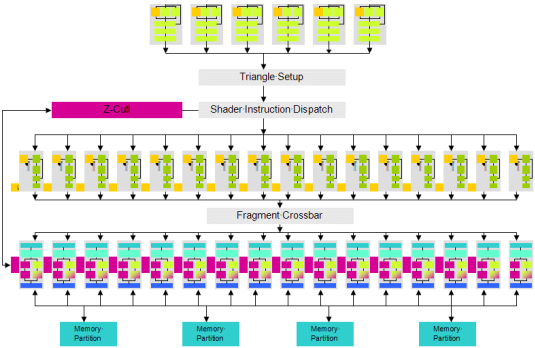

De NV40-core is voorzien van zestien pixel pipelines met ieder één texture unit. In tegenstelling tot de "8x1"-architectuur van NV3x die eigenlijk een 4x2 / 8x0-opstelling bleek te zijn, wijzen synthetische benchmarks er dit keer op dat het daadwerkelijk om een 16x1 / 32x0-configuratie gaat. Naast zestien pipelines, die op 400MHz goed zijn voor een fillrate van 6,4 gigatexels, heeft de chip een zestal vertex processors aan boord, goed voor een maximum van 320 miljoen triangles per seconde. NV40 is ontworpen voor volledige ondersteuning van pixel- en vertex shader 3.0. Dit betekent dat spelontwikkelaars nog complexere programma's kunnen gebruiken voor hun speciale effecten. Naast meer instructies, constantes en variabelen ondersteunen de nieuwe shaders een aantal extra features die bedoeld zijn om snellere en efficiëntere algoritmes mogelijk te maken, waaronder dynamische vertakkingen (if ... then) en vertex texturing.

De NV40-core is voorzien van zestien pixel pipelines met ieder één texture unit. In tegenstelling tot de "8x1"-architectuur van NV3x die eigenlijk een 4x2 / 8x0-opstelling bleek te zijn, wijzen synthetische benchmarks er dit keer op dat het daadwerkelijk om een 16x1 / 32x0-configuratie gaat. Naast zestien pipelines, die op 400MHz goed zijn voor een fillrate van 6,4 gigatexels, heeft de chip een zestal vertex processors aan boord, goed voor een maximum van 320 miljoen triangles per seconde. NV40 is ontworpen voor volledige ondersteuning van pixel- en vertex shader 3.0. Dit betekent dat spelontwikkelaars nog complexere programma's kunnen gebruiken voor hun speciale effecten. Naast meer instructies, constantes en variabelen ondersteunen de nieuwe shaders een aantal extra features die bedoeld zijn om snellere en efficiëntere algoritmes mogelijk te maken, waaronder dynamische vertakkingen (if ... then) en vertex texturing.

Dit laatste betekent dat de vertex shader gebruik kan maken van textures, die dus voortaan niet meer puur als 2d-behang dienen dat op de polygonen wordt gesmeerd, maar nu ook handig gebruikt kunnen worden om vormen 'fysiek' aan te passen. Denk hierbij een effecten zoals explosies (rondvliegende deeltjes), stof (vlaggen, kleding) en displacement mapping (de echte versie van het effect dat met bumpmapping gesuggereerd wordt) te realiseren. Ook nieuw is Geometry Instancing, waarbij bijvoorbeeld een heel bos gegenereerd kan worden door de kaart van het model van één boom te voorzien. De shader zou er dan ook nog voor kunnen zorgen dat iedere instantiatie van de boom er iets anders uit komt te zien.

![]() Beeldkwaliteit en video

Beeldkwaliteit en video

Naast het toevoegen van nieuwe shaderfuncties en extra pipelines heeft nVidia ook aandacht besteed aan anti-aliasing. Voor 4xAA is men overgestapt van ordered grid naar rotated grid, een methode die origineel van 3dfx afkomt en ook al een hele tijd door ATi wordt gebruikt. Deze methode van AA geeft over het algemeen een hogere beeldkwaliteit zonder duurder te zijn qua performance. Daarnaast is trilinear filtering terug. NV3x-kaarten gebruiken een mix van bilinear en trilinear filtering, zelfs wanneer expliciet om trilinear gevraagd wordt. Op NV40 is deze mix nog steeds de standaard instelling, maar bieden de drivers de mogelijkheid om over te schakelen naar echt trilinear. Hiervoor hoeft maar een klein beetje performance ingeleverd te worden. Ook anisotropic filtering (AF) is verbeterd. Niet alleen wordt voor het eerst 16xAF ondersteund, maar gebruikt nVidia nu dezelfde truc als ATi (angle-dependant AF) om deze methode om textures mooi om de triangles heen te vouwen wat sneller te maken.

Verder ondersteunt de NV40 High Dynamic Range-rendering, wat betekent dat alles van textures tot framebuffer in floating point gedaan kan worden. Eén van voordelen hiervan is dat de reactie van het menselijke oog (het groter en kleiner worden van de pupillen al naar gelang de hoeveelheid licht in de omgeving) op deze manier makkelijk nagebootst kan worden, waardoor de belichting zeer natuurlijk overkomt op het scherm. Ondere andere Half-Life 2 maakt gebruik van dit effect, dat op een NV40 dus relatief eenvoudig geïmplementeerd kan worden. Hieronder een screenshot waarin de toeschouwer als het ware 'verblind' wordt door invallende zon, waardoor de pilaren veel donkerer lijken dan ze eigenlijk zijn.

Ook is er een programmeerbare videoprocessor op de chip gebakken. De huidige drivers (ForceWare 60.72) ondersteunen MPEG1, MPEG2 en WMV9, maar in principe is het een universele 16-way vectorunit die in de toekomst ook ingezet zou kunnen worden voor het coderen en decoderen van andere formaten .

![]() Performance

Performance

De performance van de GeForce 6800 Ultra is fenomenaal vergeleken met de GeForce FX 5950 Ultra en Radeon 9800 XT. Ondanks het feit dat hij 75MHz lager geklokt is dan zijn voorganger, wordt in spellen waarin de processor geen beperkende factor vormt met grote regelmaat twee keer zo hoge of zelfs nog betere framerates neergezet. Dit is ondere andere te danken aan de sterk verbeterde mogelijkheden met betrekking tot pixel- en vertexshaders. Deze lopen namelijk twee tot zeven keer zo snel op NV40 dan op NV38. Gecombineerd met een enorme sloot geheugenbandbreedte, efficiëntere compressietechnieken en slimmere implementaties van AA en AF, heeft nVidia een kaart neergezet die voor geen enkel spel dat op dit moment te krijgen is op zijn knieën gaat. Veel spellen blijken zelfs met een resolutie van 1600x1200 niet in staat te zijn om de volledige kracht van NV40 te benutten; in Call of Duty, Serious Sam 2 en Unreal Tournament 2004 kost het inschakelen 4xAA op die resolutie dan ook weinig tot geen framerate, terwijl de GeForce FX 5950 Ultra in de zelfde omstandigheden al snel de helft van zijn prestaties in moet inleveren.

| 6800 Ultra | |||

| 5950 Ultra | |||

| 6800 Ultra (4xAA, 8xAF) | |||

| 5950 Ultra (4xAA, 8xAF) | |||

| 6800 Ultra | |||

| 5950 Ultra | |||

| 6800 Ultra (4xAA, 8xAF) | |||

| 5950 Ultra (4xAA, 8xAF) | |||

![]() Warmte en koeling

Warmte en koeling

De GeForce 6800 Ultra verstookt ongeveer 120 Watt wanneer hij volledig belast wordt. De AGP-versie kaart vereist dan ook twee molex-connectors en nVidia raadt het gebruik van een 480 Watt-voeding aan. Er zijn echter al berichten opgedoken die beweren dat het prima werkt met mindere voedingen, zolang deze maar van goede kwaliteit zijn. Het ziet er naar uit dat in ieder geval de eerste kaarten voorzien zullen zijn van een koeler met heatpipe die twee slots in beslag neemt. Reviewers melden dat het ding tot hun verbazing stiller en lichter is dan de beruchte dustbuster van NV30. De snelheid van de fan wordt dynamisch geregeld en komt in een kast met goede airflow niet boven de 'medium' instelling uit, waarin hij naar verluidt nog overstemd wordt door de gemiddelde processorkoeler. Zonder goede airflow zal hij iets meer decibels genereren tijdens het spelen van spellen, maar het is sowieso niet aan te raden om een NV40 aan te schaffen voor een kast die niet goed gekoeld wordt; de warme lucht die van de kaart afkomt kan zonder fatsoenlijke afvoer leiden tot instabiliteit.

![]() Conclusie

Conclusie

nVidia heeft met de introductie van de GeForce 6800 Ultra de performancekroon met groot gemak teruggepakt. De vraag is echter of dit felbegeerde juweel binnenkort niet opnieuw van eigenaar wisselt, als ATi de R420-core introduceert in de vorm van de Radeon X800 Pro, of anders een paar maanden later met de Radeon X800 XT. Als de twee chips elkaar benaderen qua performance, iets wat wel in de lijn der verwachting ligt, dan zou het nog lange tijd kunnen duren voor er echt een duidelijke winnaar uit de strijd naar boven komt. De prestatieverschillen tussen de twee titanen zullen in door de processor beperkte benchmarks nauwelijks zichtbaar worden. Titels als Doom 3 en Half-Life 2 zullen videokaarten een stuk harder laten zweten, maar die zijn vooralnog niet beschikbaar.

Voor nVidia zal het spannend zijn om te zien in hoeverre ontwikkelaars van spellen gebruik gaan maken van de mogelijkheden van pixel- en vertexshader 3.0, aangezien alle geruchten erop wijzen dat R420 dit niet (geheel) ondersteunt. Daarnaast zal het succes van beide voor een deel afhankelijk zijn van secundaire factoren zoals stroomverbruik, geluidsniveau, prijs en beschikbaarheid. Beide bedrijven lijken alles op alles te zetten om deze ronde te winnen op het gebied van framerates, een motivatie waardoor in het verleden wel eens minder nauw gekeken werd naar laatstgenoemde punten. De eerste NV40-kaarten zullen volgens nVidia in ieder geval binnen 45 dagen in de winkels liggen, voor een prijs van 499 dollar.

![]() Meer reviews / links

Meer reviews / links

- GeForce 6800 op nVidia.com

- GeForce 6800 demo's

- Persbericht #1, #2 en #3

- GoT-topic

- Beyond3d (aanrader)

- X-Bit Labs (aanrader)

- AnandTech

- HardOCP (benchmarks)

- HardOCP (technieken)

- Tom's Hardware

- Tech Report

- FiringSquad

- Hardware Analysis

- Nvnews

- Bit-Tech