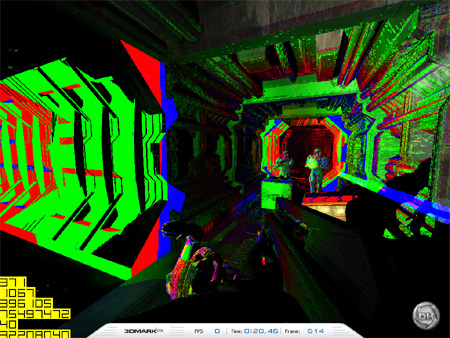

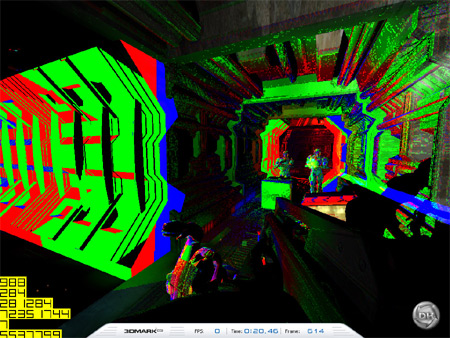

Bij Driverheaven is een artikel verschenen waarin de beeldkwaliteit van de nVidia GeForce 6800 Ultra in combinatie met de Forceware 60.72 drivers wordt onderzocht. Het blijkt dat de beeldkwaliteit van de nVidia GeForce 6800 Ultra in vergelijking met de reference DirectX rasterizer en de Radeon 9800 XT een beetje achterblijft. De nVidia Forceware 60.72 driver maakt gebruik van mipmap texture levels van een lagere kwaliteit. Hierdoor kan de GeForce 6800 Ultra sommige stukjes van een scene renderen met kleinere textures wat logischerwijs een kleine, doch positieve invloed heeft op de snelheid.

Hoewel de auteur van het artikel op Driverheaven deze optimalisatie bestempelt als cheaten is het de vraag in hoeverre dit waar is. Er wordt immers nergens voorgeschreven welke kwaliteit mipmap levels moeten hebben bij een bepaalde instelling in de drivers. De enige conclusie die getrokken kan worden is dat ATi op de "high quality"-instelling textures van een hogere kwaliteit tekent dan nVidia op zijn "high quality"-instelling.

:strip_exif()/i/1182521066.jpg?f=fpa)