Op het forum van Beyond is een gelekte presentatie van ATi opgedoken genaamd "Save the Nanosecond! PC Graphics Performance for the next 3 years". De presentatie, bedoeld voor game ontwikkelaars, heeft een tweetal onderwerpen. Het eerste deel gaat over het optimaliseren van shader programma's. In het tweede deel wordt een blik geworpen op de toekomst van pc graphics. Hierbij komen we meer te weten komen over de mogelijkheden van de R420 en die van de concurrentie, maar de meeste details blijven in nevelen gehuld.

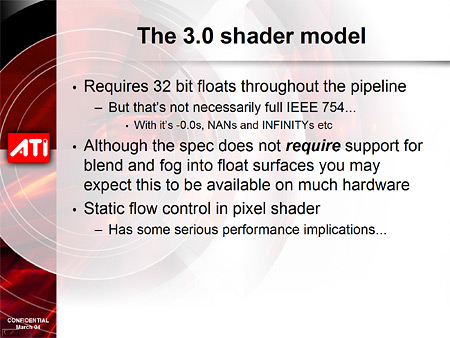

Wat we wel te weten komen is het volgende. Allereerst vraagt versie 3.0 van de pixel- en vertex shaders om 32-bits precisie en de R420 zal dat dus ook ondersteunen. De volgende DirectX-standaard, die waarschijnlijk gelijktijdig met Longhorn geïntroduceerd zal worden, zal zelfs vragen om 64-bits precisie. In de notities die bij de slides staan lezen we verder dat ATi developers ontmoedigt om gebruik te maken van 'static flow control' (if/then-constructies) binnen shader programma's gezien de performance problemen. De NV40 kan hier echter wel zonder problemen mee overweg en in de aantekeningen wordt het zelfs 'the main extra feature on NV40 vs R420' genoemd. De R5xx zal hier wel goed mee overweg kunnen. Hoewel de NV40 hier dus een streepje voor heeft op de R420, wordt er in de rest van de presentatie zeer negatief gesproken over de prestaties van nVidia's DirectX 9 hardware.