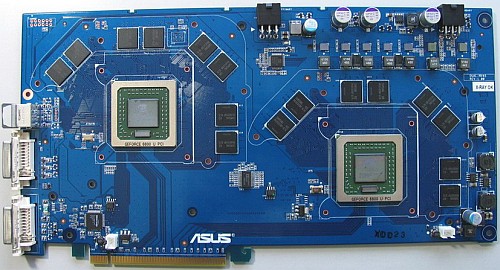

Op verschillende websites zijn foto's opgedoken van een dual-GeForce 6800 Ultra SLI grafische kaart die Asus aan het ontwerpen is. Naast twee GeForce 6800 Ultra GPU's die op 400MHz draaien, zou de kaart uitgerust zijn met 512MB DDR3-geheugen op 1100MHz. Eerder toonden Asus en Gigabyte al een grafische kaart met twee GeForce 6600 GT GPU's. Deze kaart lijkt dus een logisch vervolg hierop te zijn.

Het prototype zou op dit moment uitvoerig getest worden en het zou best wel eens kunnen zijn dat er binnenkort een officiële aankondiging komt. Wat meteen opvalt, zijn de enorme afmetingen van de kaart. De kaart is namelijk groter dan de maximale afmetingen zoals die zijn vastgelegd in de PCI Express-standaard. Dit zou problemen op kunnen leveren bij het plaatsen van de kaart in een systeem. Er wordt dan ook aangenomen dat de uiteindelijke versie een stuk kleiner zal zijn.

Ondertussen heeft nVidia laten weten dat er binnenkort ondersteuning voor vier GPU's in SLI-configuratie in de drivers zal worden ingebouwd. Daarnaast werkt nVidia ook aan de nForce4 Pro-chipset die onder andere twee volwaardige 16x PCI Express-sloten zal ondersteunen. Het gerucht dat twee Asus EN6600GT, met twee GeForce 6600 GT GPU's, in SLI-opstelling gebruikt kunnen worden lijkt hiermee dus bevestigd te worden. Of dit ook mogelijk zal worden met deze dual-GeForce 6800 Ultra is echter niet duidelijk, daar op het prototype geen SLI-connector aanwezig is. Hoewel dat natuurlijk op een retail-versie anders zou kunnen zijn.