AnandTech heeft een uitgebreide review geschreven over Asus' A8N-SLI Deluxe-moederbord. Deze plank is voorzien van de nForce4 SLI-chipset en ondersteunt dus twee PCI Express-videokaarten. Middels nVidia's technologie kunnen 3d-spellen op twee verschillende manieren versneld worden. Bij de eerste methode - Alternate Frame Rendering (AFR) - wordt de helft van de frames op de ene en de andere helft op de andere videokaart gebouwd. De andere methode is Split Frame Rendering (SFR) waarbij ieder frame in twee delen wordt geknipt en iedere videokaart een van de stukken tekent. Welke van de twee gebruikt wordt, bepaalt de driver, maar dit gaat niet automatisch: nVidia heeft voor zo'n honderd spellen de beste keuze bepaald en hard in de ForceWare-driver gecodeerd. Bij spellen die niet door het bedrijf zijn getest wordt SLI standaard uitgeschakeld uit angst voor compatibiliteitsproblemen, maar als de gebruiker het wil forceren zal AFR gebruikt worden. De reviewer beweert echter geen enkel probleem te zijn tegengekomen.

Het moederbord van Asus laat een flinke hoeveelheid ruimte vrij tussen de twee PCI Express Graphics-slots (afhankelijk van de splitter twee keer x8 of één keer x16 plus een dummy), maar gezien de hete kaarten met dual-slot koelers van tegenwoordig is dat waarschijnlijk ook geen overbodige luxe. Naast twee PCI Express-videokaarten met exact hetzelfde BIOS zijn de juiste drivers (ForceWare 66.93 of hoger), een bridge connector (zit bij het moederbord) en een extra 4-pins stroomaansluiting nodig om een SLI-configuratie aan de praat te krijgen. Een goede voeding is bovendien zeer aan te raden: een tweede GeForce 6600 GT is nog te overzien met een toename in verbruik van 27 tot 51 Watt, maar een extra GeForce 6800 Ultra slurpt toch 70 tot 92 Watt volgens de metingen van de reviewer.

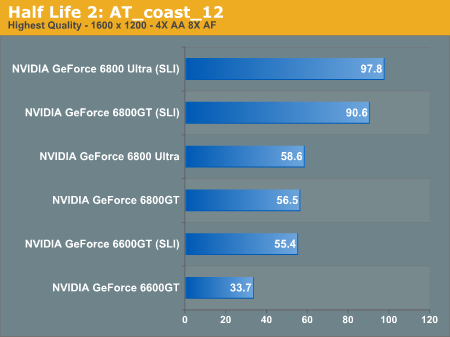

Om te kijken wat dit nou aan performance oplevert, test men de plank in combinatie met een Athlon 64 4000+ en draait men spellen als Half-Life 2, Doom 3, Far Cry, Unreal Tournament 2004, Wolfenstein: Enemy Territory en Battlefield. Hieruit blijkt net als in eerdere tests dat SLI een flinke boost (40 tot 70 procent) aan de prestaties geeft. De conclusie is dat het voor twee soorten mensen interessant is: de eerste groep zijn degenen met veel geld die het beste van het beste willen, en zelfs de modernste spellen in 1600x1200 met minstens 2xAA willen kunnen spelen. De tweede groep zijn degenen die tactisch investeren door nu een betaalbare kaart te kopen en deze later een upgrade te geven door een tweede exemplaar van dezelfde - maar inmiddels veel goedkoper geworden - kaart bij te pluggen. Vanwege de op dit moment nog zeer beperkte beschikbaarheid van de hardware en het feit dat ATi nog niet op de SLI-trein is gestapt, verwacht AnandTech echter dat de techniek pas halverwege 2005 echt door gaat breken.

:strip_exif()/i/1124045470.jpg?f=thumbmedium)