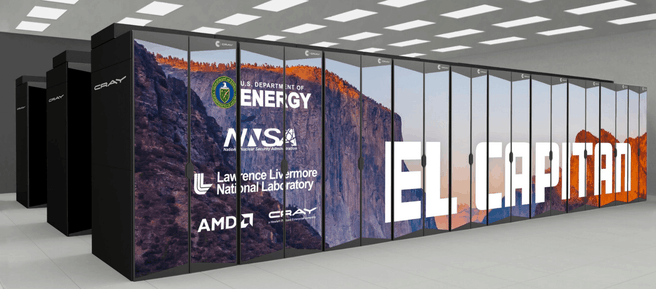

AMD bouwt mee aan een nieuwe supercomputer, El Capitan genaamd. Het systeem wordt opgetrokken rond Epyc-serverprocessors met Zen 4-cores aan boord. El Capitan zou 2,2 exaflops rekenkracht krijgen, ruim tien keer zoveel als de huidige krachtigste supercomputer.

El Capitan wordt in opdracht van het Amerikaanse Lawrence Livermore National Laboratory ontwikkeld. Dat overheidsinstituut doet voornamelijk onderzoek naar nucleaire veiligheid, waarbij onder meer simulaties van bestaande en nieuwe nucleaire wapens worden uitgevoerd. Het instituut heeft voor dergelijke berekeningen momenteel de Sierra-supercomputer, de nummer 2 op de Top500-lijst van supercomputers. AMD levert overigens al in 2021 een exascalecomputer voor een ander Amerikaans overheidsinstituut; Frontier moet volgend jaar bij het ministerie voor Energie zo'n 1,5 exaflops opleveren.

El Capitan zal gemaakt worden met een nieuwe generatie Epyc-serverprocessors met codenaam Genoa. Die generatie krijgt Zen 4-cores aan boord, die op 5nm zullen worden geproduceerd en, volgens AMD, significant meer ipc zullen leveren dan de komende Milan-processors. Het is echter nog niet bekend wat die verbeteringen worden, maar El Capitan zou veel sneller worden dan de huidige supercomputers. Met een rekenkracht van ten minste 2 exaflops zou El Capitan tien keer zo snel worden als de Summit-supercomputer, de huidige nummer 1 in de Top500-lijst supercomputers.

Hoeveel processorcores voor die rekenkracht ingezet gaan worden, maakte AMD nog niet bekend. Wel is bekend dat de Epyc Genoa-processors via een nieuwe, derde generatie Infinity Fabric met onder meer gpu's worden verbonden. De verhouding processors en gpu's zou 1:4 worden en de gpu's in El Capitan zullen bestaan uit een nieuwe generatie Radeon Instinct-kaarten. Die Instinct-generatie krijgt onder meer een nieuwe generatie hbm-geheugen en wordt geoptimaliseerd voor deep learning en andere hpc-toepassingen. Daarnaast zal Genoa, en zullen de Instinct-kaarten via het Infinity Fabric, beschikken over een nieuwe generatie werkgeheugen, waarschijnlijk ddr5.

Hoewel AMD nog niet bekendmaakt uit hoeveel nodes El Capitan zal bestaan, heeft het wel aangegeven dat het aanzienlijk minder dan 40MW energie zal verstoken. Huidige supercomputers vergen 10 tot 20MW energie, wat zou impliceren dat El Capitan aanzienlijk meer verstookt. De energiebehoefte zou overigens dichter bij 30MW zitten, wat de capaciteit is van Crays Shasta-supercomputingplatform. Shasta maakt gebruik van waterkoeling om de warmte af te voeren en beschikt over Slingshot-interconnects om de nodes aan elkaar te knopen.

Met El Capitan is een investering van 600 miljoen dollar gemoeid en naar verwachting wordt het systeem begin 2023 opgeleverd. De Zen 4 Genoa-generatie Epyc-processors wordt overigens al in 2021 verwacht. Dit jaar komt AMD met de Milan-generatie Epyc met Zen 3-cores aan boord.

:strip_exif()/i/2006847440.jpeg?f=fpa)

/i/2004611214.png?f=fpa)

/i/2004646380.png?f=fpa)

/i/1386671556.png?f=fpa)

:strip_exif()/i/2001610695.jpeg?f=fpa)

/i/1194954230.png?f=fpa)

:strip_exif()/i/2001508675.jpeg?f=fpa)

/i/2001237765.png?f=fpa)

/i/2001116017.png?f=fpa)

/i/1234449793.png?f=fpa)

/i/2001393753.png?f=fpa)

:strip_exif()/i/2002989802.jpeg?f=fpa)

:strip_exif()/i/2002705138.jpeg?f=fpa)