Omnivision heeft, in samenwerking met Tsmc, een methode ontwikkeld om de lichtopbrengst van cmos-sensors te vergroten. Door de chips om te draaien, wordt het licht niet door de metaallagen van de sensor gehinderd.

Omnivision, een leverancier van cmos-beeldsensors, heeft de gebruikelijke opbouw van een cmos-chip voor gebruik in camera's aangepast om de efficiëntie te vergroten. De huidige sensors bevatten elektronica die nodig zijn om licht in een elektrisch signaal om te zetten. Ook moet het signaal door de nodige transistors worden versterkt, waardoor nog minder licht daadwerkelijk op de lichtgevoelige sensor valt. Omnivision heeft met zijn 'Backside Illumination'-sensor de chip simpelweg omgedraaid, zodat het licht minder ver hoeft te reizen.

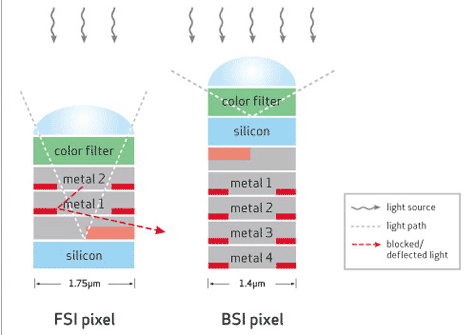

Bij de courante frontside-illuminationsensors moet het licht door drie lagen elektronica reizen. De backside-illuminationtechnologie zorgt er echter voor dat het licht direct het silicium met de lichtgevoelige sensors kan bereiken. De backside illumination heeft een lichtopbrengst in sensors met pixels van 1,4 micron tot gevolg die groter is dan de lichtopbrengst van even grote frontside-illuminationsensors en die zelfs vergelijkbaar zou zijn met die van grotere 1,75-micronsensors. De grotere lichtopbrengst van backside-illuminationsensors moet volgens Omnivision onder meer de weg vrijmaken om kleinere cmos-sensors met 0,9 micron grote pixels te produceren.

Bij de courante frontside-illuminationsensors moet het licht door drie lagen elektronica reizen. De backside-illuminationtechnologie zorgt er echter voor dat het licht direct het silicium met de lichtgevoelige sensors kan bereiken. De backside illumination heeft een lichtopbrengst in sensors met pixels van 1,4 micron tot gevolg die groter is dan de lichtopbrengst van even grote frontside-illuminationsensors en die zelfs vergelijkbaar zou zijn met die van grotere 1,75-micronsensors. De grotere lichtopbrengst van backside-illuminationsensors moet volgens Omnivision onder meer de weg vrijmaken om kleinere cmos-sensors met 0,9 micron grote pixels te produceren.

Omnivision heeft een cmos-sensor van 8 megapixel met backside illumination gedemonstreerd, waarvan het verwacht in juni samples te kunnen leveren. Dankzij de nieuwe sensors kunnen camera's met minder licht toe en kunnen ook de lenzen van camera's korter worden gemaakt, omdat de hoek van invallend licht groter is. Dat maakt plattere cameramodules mogelijk, bijvoorbeeld voor gebruik in telefoons. Ook zouden de beeldsensors goedkoper dan frontside-illuminationchips kunnen worden, aangezien de productie eenvoudiger is en kleinere chips mogelijk zijn.

/i/1312449404.png?f=fpa)

:strip_exif()/i/1268163438.jpeg?f=fpa)

:strip_exif()/i/1222186311.gif?f=fpa)

/i/1213263299.png?f=fpa)

/i/1211541585.png?f=fpa)

/i/1211528180.png?f=fpa)

/i/1205957718.png?f=fpa)