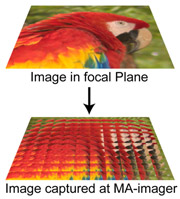

Onderzoekers van de Stanford-universiteit hebben een beeldsensor ontwikkeld die - beperkt - 'diepte' kan zien. Het prototype van de drie megapixel-beeldsensor is een multi-aperture-ontwerp.

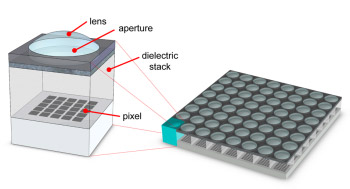

De cmos-beeldsensor is gebakken op een 110nm-procedé en is onderverdeeld in groepen van 16 bij 16 pixels, waarbij elke pixelgroep voorzien is van een microlens die een klein deel van het beeld projecteert op de onderliggende pixels. In totaal bevat de beeldsensor 12.616 van deze groepen. Elke groep bekijkt het te 'vangen' beeld vanuit een iets andere hoek en de geprojecteerde beelden van aangrenzende groepen overlappen elkaar gedeeltelijk.

De cmos-beeldsensor is gebakken op een 110nm-procedé en is onderverdeeld in groepen van 16 bij 16 pixels, waarbij elke pixelgroep voorzien is van een microlens die een klein deel van het beeld projecteert op de onderliggende pixels. In totaal bevat de beeldsensor 12.616 van deze groepen. Elke groep bekijkt het te 'vangen' beeld vanuit een iets andere hoek en de geprojecteerde beelden van aangrenzende groepen overlappen elkaar gedeeltelijk.

Beeldbewerkingssoftware kan uit de resulterende opname niet alleen het originele tweedimensionale beeld terug toveren, maar ook de diepte-informatie is te herleiden. Volgens Keith Fife, die het onderzoek bij Stanford leidt, kan deze extra informatie als metadata toegevoegd worden aan een jpeg-bestand. Fife presenteerde het ontwerp tijdens de ISSCC-conferentie.

De nieuwe beeldsensor heeft als voordeel dat de kleurruis in foto's af kan nemen, omdat aan de hand van meerdere groepen pixels nauwkeuriger de juiste kleur kan worden bepaald. Deze zogeheten 'chroma noise' treedt vooral op bij hogere lichtgevoeligheden van een beeldsensor. Daarnaast is het mogelijk om de pixelgroepen toe te wijzen aan één van de rgb-kleuren om zo het 'lekken' van kleuren naar andere pixels tot een minimum te beperken. Volgens Fife is er voor extreme close-ups zelfs geen extra lens voor de beeldsensor nodig. Vooral voor medische toepassingen zou dit handig kunnen zijn.

Nadelen kleven ook aan een multi-aperture-indeling van de beeldsensor: de uiteindelijke beeldresolutie is beduidend lager vanwege de redundante beeldinformatie, er is tien keer meer rekenkracht nodig om het tweedimensionale beeld en de bijbehorende diepteinformatie te berekenen en om diepte te onderscheiden moet er genoeg contrast zijn tussen de in beeld gebrachte onderwerpen.

De oplossing van de onderzoekers van Stanford lijkt veel op de facetlens van Adobe. Met het verschil dat bij de oplossing van Adobe het beeld van één van de kleine lenzen op de sensor de hele scene bestrijkt. Bij een presentatie van de facetlens bevestigde Adobe's Dave Story dat de volgende stap het integreren van de microlenzen op de beeldsensor is.

/i/1308745077.png?f=fpa)

/i/1240825121.png?f=fpa)

/i/1211884796.png?f=fpa)

/i/1202991879.png?f=fpa)

:strip_exif()/i/1179920635.jpg?f=fpa)