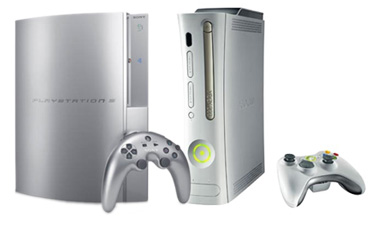

In een interview met Bit-tech.net heeft ATi's Richard Huddy zich uitgelaten over de grafische capaciteiten van de Xbox 360 en de PlayStation 3. Volgens hem zou de ATi Xenos-chip in de Xbox 360 tot 100% beter presteren dan de nVidia RSX-chip in de PlayStation 3, ondanks dat de RSX op een 10% hogere kloksnelheid draait. Dit zou komen omdat de Xenos gebruik maakt van een unified shader architectuur en de RSX niet. Hiermee bedoelt Richard Huddy dat elke pipeline in de Xenos een volledige shader heeft, die alle shader-instructies aan kan. De pipelines van de RSX van nVidia zijn echter uitgerust met verschillende shaders die niet allemaal alle instructies aankunnen. Uiteraard moet dit met een korreltje zout genomen worden daar Richard Huddy van beide chips nog niet het eindresultaat heeft gezien.

Behalve deze uitlatingen over de 'superieure' grafische kracht van de Xbox 360 maakt Richard Huddy ook nog wat opmerkingen over het spelen van Xbox-spellen op de Xbox 360. Dit zou geheel met emulatie gaan gebeuren, waarbij er emulatieprofielen op de harde schijf opgeslagen kunnen worden. Volgens Richard zou het geen probleem moeten zijn om een 733MHz Pentium 3 te emuleren op de Xbox 360, daar deze uitgerust is met drie 3GHz PowerPC-cores. Echter met alleen het emuleren van de processor is het werk nog niet af. Ook de grafische processor zal geëmuleerd moeten worden. Dit betekent dat API-calls voor de nVidia GPU in de Xbox vertaald moeten worden naar API-calls voor de Xenos. Volgens Richard is dat voor het gros van de API-calls geen moeilijke taak. Voor spellen die echter van specifieke functies van de Xbox GPU gebruik maken is dit echter een stuk moeilijker.