Nicholas Blachford heeft op zijn homepage een beschrijving gegeven van de Cell-processor, die in de PlayStation 3 zal worden gebruikt, en de achterliggende architectuur. Daarnaast gaat hij in op de vraag of de Cell-processor een bedreiging zal vormen voor de huidige processors die momenteel in pc's gebruikt worden. Dit was geen gemakkelijke taak, want IBM, Toshiba en Sony, die deze processor hebben ontworpen, hebben tot nu toe maar weinig los gelaten over de architectuur. Het artikel is dan gebaseerd op een patent omtrent de Cell-processor en informatie die verspreid over het Internet is te vinden. Het is dus goed mogelijk dat Blachford een aantal details niet correct heeft, hoewel er waarschijnlijk wel gesteld kan worden dat hij er niet ver naast zal zitten.

De Cell-processor is gebaseerd op een architectuur die bestaat uit meerdere cellen, waarbij de onderliggende processors, als de software, inclusief de gegevens die verwerkt moeten worden, beschouwd worden als afzonderlijke cellen. Dit geheel wordt bestuurd door een cel die softwarecellen richting processorcellen verstuurd. Als de processorcel klaar is met de berekeningen, worden de resultaten weer teruggestuurd naar de moedercel. Deze architectuur valt dan ook heel goed te vergelijken met een vorm van distributed computing. Ook kan het geheel zo geprogrammeerd worden dat een cel de gegevens van een andere cel gebruikt. Hiermee kan op een redelijk eenvoudige manier bijvoorbeeld een MPEG2-stream (dvd, HDTV) worden afgespeeld, waarbij er door elke cel een andere bewerking wordt losgelaten op de stream die afkomstig is van de bron.

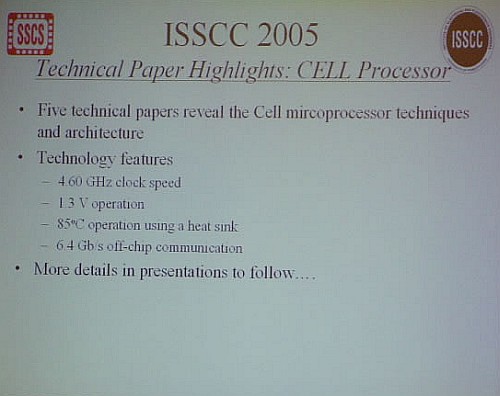

Volgens Blachford zal de Cell-processor bestaan uit een op IBM's Power Architectuur gebaseerde processor, de Processor Unit, acht geheugencontrollers en acht Attached Processing Units. De Power-processor zorgt voor het distribueren van de softwarecellen over de APU's. Deze APU's, vergelijkbaar met een SSE3-unit in de Pentium 4, doen dus het uiteindelijke werk. Hiervoor heeft elke APU de beschikking over 128KB snel SRAM-geheugen, 128 128-bits registers, vier floating point unit en vier integer units. Tijdens een presentatie van de Cell-processor tijdens het ISSCC werd een dia getoond waaruit blijkt dat dit alles zijn werk zal doen op 4,6GHz en 1,3V:

Deze slide was de basis voor een discussie op Real Word Technologies, waarbij ook het artikel van Blachford werd besproken. Onder andere Paul DeMone laat hier van zich horen en stelt dat de architectuur van de verschillende onderdelen erg simpel moet zijn om dit soort snelheden toe te laten. Vooral het feit dat de Power-architectuur deze snelheden waarschijnlijk nooit kan halen, wijst erop dat de 4,6GHz waarschijnlijk alleen betrekking heeft op de APU's.

Blachford stelt in zijn artikel dat er maar liefst vijf 3GHz dual-core Opteron-processors nodig zijn om de rekenkracht van een enkele Cell-processor te evenaren. Toch zal de Cell-processor niet meteen een x86-processor kunnen vervangen. Alle software zal namelijk herschreven moeten worden om te kunnen draaien op de Cell-architectuur, iets dat waarschijnlijk niet zal gebeuren. Toch ziet Blachford in de Cell-processor een geduchte concurrent voor de huidige x86-processor. Met behulp van een Just-In-Time (JIT) compiler zou een Cell-processor namelijk een pc kunnen emuleren en dus via een omweg de concurrentie aangaan. Dit is min of meer vergelijkbaar met de morphing-technologie die gebruikt wordt in de processors van Transmeta, bijvoorbeeld de Efficeon. Op Real Word Technologies zijn ze hier echter een stuk sceptischer over.