Geheugenfabrikant Sandisk zou aan een standaard werken om de levensduur van solid state disks te kwantificeren. De Jedec, een organisatie die standaarden vaststelt, zou met Sandisk en andere fabrikanten over ssd-standaarden overleggen.

Volgens Sandisk vult de nieuwe standaard, die ze Longterm Data Endurance (LDE) gedoopt hebben, een hiaat in de specificaties van solid state drives: namelijk een indicatie voor de verwachte levensduur van een ssd-drive. Fabrikanten weten weliswaar hoeveel lees- en schrijfcycli de individuele geheugenchips in een ssd aankunnen, maar de vertaling naar de complete solid state disk ontbreekt vooralsnog. LDE moet daar verandering in brengen.

Volgens Sandisk vult de nieuwe standaard, die ze Longterm Data Endurance (LDE) gedoopt hebben, een hiaat in de specificaties van solid state drives: namelijk een indicatie voor de verwachte levensduur van een ssd-drive. Fabrikanten weten weliswaar hoeveel lees- en schrijfcycli de individuele geheugenchips in een ssd aankunnen, maar de vertaling naar de complete solid state disk ontbreekt vooralsnog. LDE moet daar verandering in brengen.

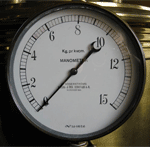

De LDE-'standaard' is gebaseerd op het totaal aantal terabytes dat een ssd gedurende zijn levensduur kan wegschrijven. In samenwerking met testbedrijf Bapco concludeerde Sandisk dat een 'professionele pc-gebruiker' gemiddeld 87GB per week wegschrijft. Op basis van dat getal schat Sandisk, in combinatie met zijn LDE, de resterende levensduur van een ssd. Die schatting zou realtime op een virtuele meter weergegeven kunnen worden. Of de berekeningen ook gelden voor andere ssd's is niet duidelijk: de gebruikte geheugencontrollers, en daarmee de methodes voor foutcorrectie, zijn immers niet in elke ssd identiek.

De Jedec, maakte ruim een week geleden bekend een onderzoekscommissie met de naam JC-64.8 te hebben ingesteld die standaarden voor solid state disks moet ontwikkelen. De Jedec, die standaarden voor de halfgeleiderindustrie vastlegt, is ook op de hoogte van de activiteiten van Sandisk. De onderzoekscommissie werkt echter ook nauw samen met Seagate en de JC-64.8 wordt mede voorgezeten door medewerkers van die fabrikant. Seagate hoopt zelf in 2009 met een lijn ssd's voor gebruik in servers te komen en via de Jedec standaarden voor het testen van prestaties en levensduur van data op ssd's te ontwikkelen.

De Jedec, maakte ruim een week geleden bekend een onderzoekscommissie met de naam JC-64.8 te hebben ingesteld die standaarden voor solid state disks moet ontwikkelen. De Jedec, die standaarden voor de halfgeleiderindustrie vastlegt, is ook op de hoogte van de activiteiten van Sandisk. De onderzoekscommissie werkt echter ook nauw samen met Seagate en de JC-64.8 wordt mede voorgezeten door medewerkers van die fabrikant. Seagate hoopt zelf in 2009 met een lijn ssd's voor gebruik in servers te komen en via de Jedec standaarden voor het testen van prestaties en levensduur van data op ssd's te ontwikkelen.

Een geplande datum wanneer de Jedec-werkgroep zijn standaarden gereed hoopt te hebben, wordt niet genoemd. Het is evenmin bekend wanneer de LDE-meters, die het uiterlijk van een manometer zouden kunnen krijgen, officieel het levenslicht zullen zien. Het gebruik van een analoge drukmeter als indicatie voor de geschatte resterende levensduur van een ssd, sprak klanten aan, aldus Don Barnetson, verantwoordelijk voor ssd-marketing bij Sandisk.

/i/1201865680.png?f=fpa)

:strip_exif()/i/1220893496.gif?f=fpa)

/i/1279014340.png?f=fpa)

/i/1212498934.png?f=fpa)

/i/1221644136.png?f=fpa)

/i/1216735171.png?f=fpa)

:strip_exif()/i/1216650698.gif?f=fpa)