Terwijl AMD in Tunesië een select gezelschap journalisten tekst en uitleg geeft over de R600-architectuur, zijn de eerste benchmarkresultaten en de exacte specificaties van de ATi Radeon HD 2900XT al uitgelekt.

Na een aantal vertragingen heeft AMD nu eindelijk zijn zaakjes op orde, zodat nieuwe videokaarten rond de R600-architectuur in grote getale van de lopende band kunnen rollen. Naast de high-end Radeon 2900-serie, waarvan verschillende versies medio mei op de markt moeten komen, heeft ATi voor het middensegment en de budgetmarkt respectievelijk de 2600- en 2400-serie in de planning. De gelekte details geven inzicht in de mogelijkheden van de Radeon HD 2900XT, een kaart die het moet gaan opnemen tegen de GeForce 8800GTS van nVidia. Om het grafisch geweld van nVidia aan te kunnen, heeft AMD de 2900XT voorzien van 320 stream-processors voor het aansturen van de unified shaders. De 8800GTS heeft 96 stream-processors, maar door een andere architectuur van nVidia zijn niet direct conclusies te trekken over de prestaties. De R600-gpu is geklokt op 742MHz en communiceert middels een 512-bits brede geheugeninterface met 512MB gddr3-geheugen op 1,65GHz.

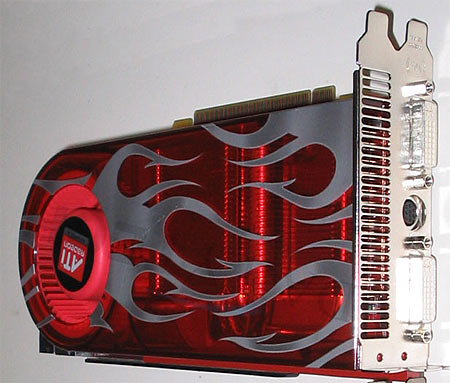

De 24,1 centimeter lange kaart wordt actief gekoeld en slokt twee sloten op. Verder ondersteunt de R600-gpu uitvoer van hdmi-audio en -video, maar het door DailyTech geteste exemplaar heeft twee dual-link dvi-aansluitingen. De benchmarks zijn uitgevoerd op een Intel D975XBX2, voorzien van een Intel Core 2 Extreme QX6700 cpu en 2GB ddr2-geheugen op 800MHz. De kaart werd onder Windows XP getest met een aantal populaire games en het onontkoombare 3DMark06. De 2900XT houdt zich prima staande tegenover de 8800GTS en weet in enkele spellen de nVidia-kaart te verslaan. Het systeem haalde een 3DMark06-index van 11.447 punten, terwijl de 8800 GTS-configuratie het met 9.836 moest stellen. AMD belooft dat de HD 2900XT - adviesprijs 449 dollar - voldoende voorradig zal zijn. Het bedrijf komt ook nog met de HD 2900XTX op de markt, waarbij het geheugen is verdubbeld tot 1GB en geklokt op 2,2GHz.

:strip_exif()/i/1171112937.jpg?f=fpa)

:strip_exif()/i/1184690058.gif?f=fpa)

:strip_exif()/i/1174259409.gif?f=fpa)

:strip_exif()/i/1163504062.gif?f=fpa)