In een interview met FiringSquad heeft ATi's Will Willis verteld dat ATi alle belangrijke physics-engines ondersteunt. Hij reageert daarmee op het rumoer dat nVidia deze week veroorzaakte met de aankondiging van de Havok-engine, waarmee videokaarten kunnen worden ingezet om natuurkundige berekeningen door de gpu in plaats van door de cpu te laten afhandelen. 'Onze X1K-kaarten zijn bij uitstek geschikt voor zulk parallel rekenwerk en we onderzoeken momenteel de mogelijkheden om de physics-berekeningen ook door CrossFire-setups te laten uitvoeren. Havok heeft al laten weten dat ze zich niet uitsluitend op nVidia-producten toeleggen - we willen geen concrete beloftes doen, maar je kan zelf wel nagaan hoe dit zal uitpakken.'

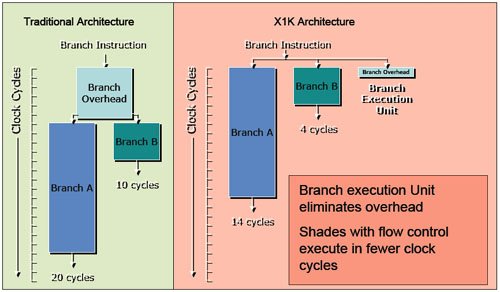

Volgens Willis blinkt de R580-core, die in de X1900-kaarten verwerkt is, uit in natuurkundig rekenwerk omdat de 48 pixelshaders van de chip gebruikt kunnen worden. Het belangrijkste voordeel ten opzichte van nVidia's 7-serie is echter 'Dynamic Flow Control', de branch prediction-technologie van ATi. De chips van het bedrijf kunnen met aanzienlijk kleinere threads overweg dan 'concurrerende producten', waarbij veel minder data hoeft te worden geanalyseerd. Daarom zou ATi-hardware in dezelfde tijd meer en gedetailleerdere objecten kunnen genereren, zoals bijvoorbeeld een weelderige haardos.

De in natuurkundige berekeningen gespecialiseerde Ageia-processor ziet Willis niet als een serieuze bedreiging. 'Natuurlijk is hun benadering interessant, maar wij kunnen alles wat zij kunnen, en vaak efficiënter en sneller. Bovendien hoef je voor onze oplossing geen extra hardware aan te schaffen, en dat kunnen zij niet zeggen: probeer een Ageia-ppu maar eens een 3D-model te laten renderen.' Het grootste voordeel is volgens hem echter dat de videochips veel verder ontwikkeld zijn. 'Zelfs als de effectiviteit van een R520 lager is dan die van de Ageia-chip, is het aantal instructies dat kan worden uitgevoerd zoveel hoger, dat een X1900 gehakt van de physics-chip maakt.'

Een nadeel van het inzetten van de gpu is uiteraard dat die minder tijd overhoudt voor lijntrekkerij en het plaatsen van puntjes op de i. Dat kan echter ondervangen worden door van meer dan een kaart gebruik te maken, waarbij ATi's CrossFire-drivers het mogelijk zouden moeten maken om bijvoorbeeld een X1900 voor het grafische geweld te gebruiken, terwijl voor natuurkundeberekeningen een veel goedkopere X1600 gebruikt kan worden. Omdat er nog maar weinig software voor de Ageia beschikbaar is, lijkt de ATi-oplossing, die ook voor puur grafisch werk gebruikt kan worden, kostentechnisch voordeliger. Voor nVidia, dat voor SLI gelijkwaardige kaarten nodig heeft, betekent de Ageia-kaart een grotere bedreiging. Toch zal moeten worden afgewacht hoe populaire software met de verschillende alternatieven presteert, voordat er een winnaar van de physics-race kan worden aangewezen.

/i/1122632544.png?f=fpa)

:strip_exif()/i/1144679778.jpg?f=fpa)