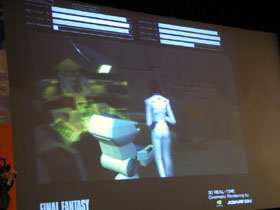

nVidia's chief technical officer David Kirk heeft enkele dagen geleden in Korea enkele nieuwe details bekendgemaakt over de NV30, die nu binnen drie weken zal worden aangekondigd. Op deze site vind je een fotoverslag van de presentatie die werd gegeven op "GeForce Mania's Day". Zoals bekend kweekt nVidia hoge verwachtingen voor deze chip. Tijdens de presentatie wordt vooral gesuggereert dat de kwaliteit even goed is als die van bepaalde films. Zo worden screenshots getoond uit Shrek en Final Fantasy om te illustreren wat voor soort effecten de gamers kunnen verwachten op hun eigen pc, dankzij de hoge mate van programmeerbaarheid. De pixelshader alleen zou al goed zijn voor 51 gigaflops per seconde, en het T&L-gedeelte zou in staat zijn om honderd dino's uit Jurassic Park met 100fps in beeld te brengen. De core bestaat uit 125 miljoen transistors en de performance zou in totaal meer dan twee keer zo goed zijn als die van de GeForce4, waarbij met name verbeteringen zijn aangebracht op het gebied van anti-aliasing en hoge kleurendieptes. Om al deze claims kracht bij te zetten werd na de presentatie een real-time gerenderde scene uit de film Final Fantasy: The Spirits Within getoond:

The Inquirer meent overigens dat de naam van de chip Nitro wordt, iets wat op zich wel in de traditie zou passen (TNT, Detonator) maar niet in het originele Koreaanse stuk is terug te vinden.