Het betaalde abonnement voor ChatGPT is sinds vrijdag ook beschikbaar in Nederland en België. Dat blijkt uit screenshots van meerdere gebruikers. Ook uit eigen observatie blijkt dat het nu mogelijk is om te upgraden naar ChatGPT Plus.

:strip_exif()/i/2005621318.jpeg?f=imagenormal)

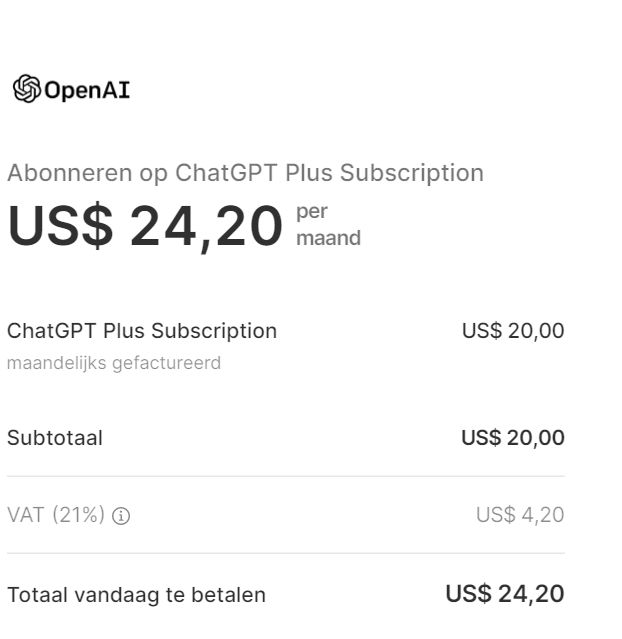

Op de pagina van ChatGPT is nu links het kopje 'Upgrade to Plus' te vinden. Het abonnement voor de Plus-dienst kost in Nederland en België 24,20 dollar per maand, omgerekend 22,61 euro, vanwege de 21 procent btw die bovenop de 20 dollar wordt berekend. De enige betaalmethode is via een creditcard. In onder meer Duitsland en Frankrijk is de abonnementendienst op dezelfde dag beschikbaar gemaakt. Een volledige lijst landen waar de dienst nu beschikbaar is, is niet gegeven.

ChatGPT Plus werd begin deze maand geïntroduceerd in de Verenigde Staten. Het biedt onder meer snellere responstijden, vervroegd toegang tot nieuwe features en algemeen toegang tot de chatbot, ook op drukke momenten. OpenAI zegt ook bezig te zijn met verschillende andere abonnementen rondom ChatGPT.

/i/2006258942.png?f=fpa)

/i/2005490828.png?f=fpa)

:strip_exif()/i/2005545080.jpeg?f=fpa)

/i/2004790848.png?f=fpa)

:strip_exif()/i/2005670352.jpeg?f=fpa)

/i/2005297412.png?f=fpa)

:strip_exif()/i/2005618266.jpeg?f=fpa)