Nvidia's G-Sync-technologie, die stuttering en tearing voorkomt tijdens het gamen, komt naar laptops en vereist dan geen extra hardwaremodule. Dat bevestigt Nvidia nadat een testdriver G-Sync op een laptop mogelijk bleek te maken.

Met behulp van G-Sync lopen de gpu en beeldscherm synchroon. Als de videochip een frame berekent, zorgt een signaal naar het beeldscherm ervoor dat de verversing van het scherm hierop gelijkgezet wordt. Dit moet stuttering en tearing voorkomen en een soepelere weergave van beelden opleveren.

Vorige week verscheen in een blog van Gamenab de claim dat Nvidia's G-Sync een marketingtruc was. De technologie werkte ook op een laptop met de GeForce GTX 980M, zo toonde de site aan, en een hardwaremodule was niet nodig. Nvidia brengt monitorfabrikanten geld in rekening voor het gebruik van die module en beeldschermen met G-Sync-ondersteuning zijn dan ook duurder dan varianten zonder ondersteuning.

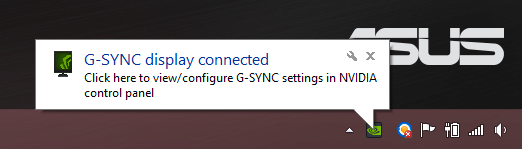

De mogelijkheid om G-Sync op een laptop werkend te krijgen ontstond nadat een alfa-driver voor de Asus ROG G751 was verschenen. Na installatie toonde de laptop een pop-up dat een G-Sync-scherm was aangetroffen en de technologie bleek ook daadwerkelijk te werken. Gamenab concludeerde dat de module een verkapte drm-component was en dat G-Sync in feite hetzelfde deed als VESA's Adaptive-Sync-variant, die mogelijk is op elk scherm met displayport 1.2 en embedded-displayport. De Adaptive-Sync-standaard komt voort uit AMD's Freesync.

PCPer dook dieper in het onderwerp en kreeg G-Sync eveneens werkend. De site speculeerde dat G-Sync inderdaad op een Adaptive-Sync-achtige manier werkt en dat de timing-controller van het LG-scherm van de laptop in staat was zodanig voor variabele verversingssnelheid te zorgen dat dit goed genoeg was voor G-Sync. Het ging daarnaast om een paneel met een maximale refreshrate van 100Hz. De werking zou wel enige nadelen hebben. Zo vertoonde het scherm drop-outs bij lage fps en bij onverwachte overgangen naar 0fps. Een beeldscherm met een G-Sync-module zou hier minder last van hebben.

Navraag bij Nvidia leerde dat laptops inderdaad ondersteuning voor G-Sync krijgen zonder dat een module vereist is. De desbetreffende driver was bedoeld voor fabrikanten om alvast aan troubleshooting te kunnen doen. De fabrikant zou de technologie kunnen optimaliseren doordat Nvidia de implementatie van de specifieke panelen en timing-controllers kent. De grote vraag is nu of Nvidia het dan nog noodzakelijk vindt om de hardwaremodule bij beeldschermen te eisen om G-Sync te kunnen ondersteunen. Die vraag wordt echter nog niet beantwoord door het bedrijf.

/i/2001665377.png?f=fpa)

:strip_exif()/i/1394531145.jpeg?f=fpa)

:strip_exif()/i/1295600046.gif?f=fpa)

/i/1208164214.png?f=fpa)

/i/1207757626.png?f=fpa)

/i/1303211688.png?f=fpa)

/i/1263217042.png?f=fpa)

/i/1361627046.png?f=fpa)

/i/1255676664.png?f=fpa)

/i/1349425400.png?f=fpa)

/i/1316677350.png?f=fpa)

/i/1399980552.png?f=fpa)

/i/1221730219.png?f=fpa)

:strip_exif()/i/1380099265.jpeg?f=fpa)

/i/1333356382.png?f=fpa)