AMD heeft drie nieuwe mobiele videokaarten op basis van de Graphics Core Next-architectuur aangekondigd. De R9, R7 en R5 M200-gpu's zullen dit jaar verschijnen in systemen van onder andere Alienware, Clevo, Lenovo en MSI. Ook komt AMD met een alternatief voor Nvidia's G-sync.

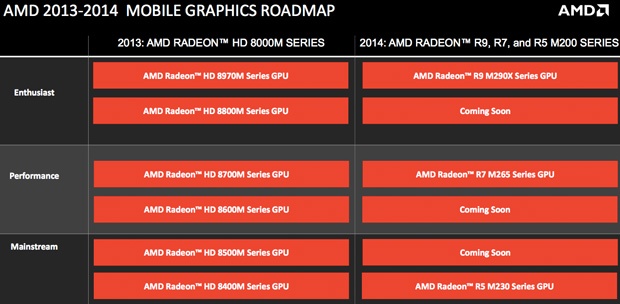

AMD komt dit jaar met zes nieuwe mobiele gpu's, waarvan het bedrijf er drie heeft aangekondigd tijdens de CES-elektronicabeurs. De R9 M290X is een high-end model, dat de HD 8970M moet opvolgen. De R7 M265-serie is de opvolger van de HD 8700M-reeks voor krachtige mainstream-laptops en de R5 M230-gpu's zijn meer voor het instapsegment, als aflossing van de HD 8400M-serie. Details over de gpu's geeft AMD nog niet, maar wel komen Alienware, Clevo, Lenovo en MSI met systemen met de videochips. Volgens ComputerBase gaat het om Volcanic Island-gpu's, die ook de basis vormen voor de R9 290- en R9 290X-desktopkaarten.

Daarnaast heeft AMD de technologie Freesync aangekondigd. Dit is een alternatief voor Nvidia's G-sync, dat tearing en stuttering moet voorkomen. Waar Nvidia een hardwaremodule naar voren schuift die door monitorfabrikanten moet worden ingebouwd, maakt AMD gebruik van een bestaande VESA-standaard om de vblank-intervals te beheren en een variabele verversingssnelheid te verkrijgen. AMD's apu's en gpu's ondersteunen dit al enkele generaties en als ook de displays ondersteuning bieden, is verder geen nieuwe hardware nodig, schrijft AnandTech.

:strip_exif()/i/1295600046.gif?f=fpa)

/i/1303211688.png?f=fpa)

/i/1208164214.png?f=fpa)

/i/1349425400.png?f=fpa)

:strip_exif()/i/1358501421.jpeg?f=fpa)

/i/1221730219.png?f=fpa)