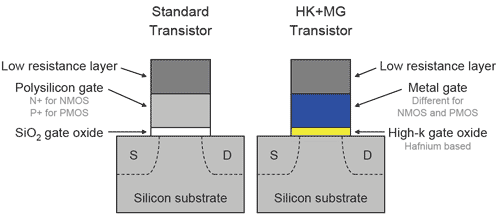

Intel heeft vandaag bekendgemaakt dat het voor zijn 45nm-chips een nieuw soort transistor heeft ontwikkeld bestaande uit een 'high-k' hafniumlegering en een metalen gate. Men noemt het de grootste verbetering in transistortechniek sinds het polysiliciumontwerp uit de jaren 60.

De nieuwe materialen zorgen er samen met de fysieke verkleining voor dat er ten opzichte van het 65nm-procédé meer dan tien keer minder stroom weglekt uit de gate en er zo'n dertig procent minder schakelstroom nodig is. Daarnaast kan er - afhankelijk van de toepassing - gekozen worden tussen twintig procent hogere snelheid of vijf keer minder lekstroom tussen source en drain. Het vinden van de juiste combinatie van metalen was een grote uitdaging, omdat men niet alleen goede prestaties wilde, maar ook rekening moest houden met zaken als kosten, betrouwbaarheid en produceerbaarheid. Welke legeringen men precies gebruikt wil men nog niet zeggen. Hoewel de concurrentie er ongetwijfeld achter kan komen zodra ze de eerste chips in handen krijgen, wil Intel ze waarschijnlijk zo lang mogelijk in het duister laten tasten.

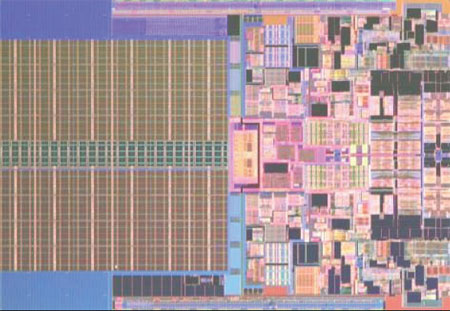

Er worden op dit moment drie fabrieken uitgerust met 45nm-productielijnen. De Amerikaanse Fab 32 en D1D zullen in de tweede helft van dit jaar beginnen met massaproductie, in de eerste helft van volgend jaar gevolgd door Fab 28 in Israël. De eerste processor die gebruik zal gaan maken van de techniek is de opvolger van Core 2, die de codenaam Penryn draagt. Deze zal in alle smaken van notebook tot server verschijnen en heeft een paar verbeteringen ten opzichte van de huidige generatie, waaronder vijftig sse4-

Update (9:05): Direct na de aankondiging van Intel heeft IBM onthuld dat het ook een versie van deze techniek heeft ontwikkeld voor de 45nm-generatie. IBM werkt onder andere met AMD samen op het gebied van productietechniek, dus Intels verwachting dat de concurrentie de techniek pas voor 32nm-chips zal toepassen zou wel eens te optimistisch kunnen blijken.

/i/1242207182.png?f=fpa)

:strip_exif()/i/1178274684.jpg?f=fpa)

:strip_exif()/i/1060771143.gif?f=fpa)

/i/1157717307.png?f=fpa)

:strip_exif()/i/1149584728.jpg?f=fpa)