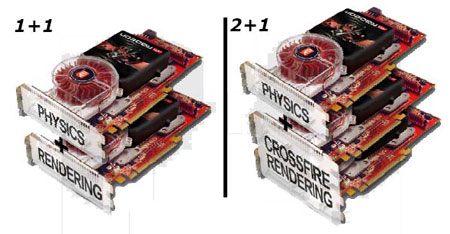

ATi heeft op de openingsdag van Computex in Taiwan een versie van de natuurkunde-engine Havok gedemonstreerd die op een Radeon-GPU draait. Het systeem is bedoeld voor mensen met CrossFire-configuraties, waarbij één kaart de natuurkunde kan doen en de andere kaart zich puur met de pixels bezighoudt. Het is echter ook mogelijk om het extremer aan te pakken met drie kaarten: twee om te renderen en één voor physics. Een aantal verschillende fabrikanten van moederborden zou al bezig zijn met ontwerpen met drie PEG-slots om dat mogelijk te maken. De kaart die met Havok aan de slag gaat hoeft overigens niet identiek te zijn aan de andere kaart(en) en zou bovendien helemaal niet zo krachtig hoeven zijn. Volgens de claims van ATi zou een X1600 XT al genoeg zijn om de PhysX PPU van Ageia te verslaan en een X1900 XT zou maar liefst negen keer zo snel zijn. Bij welk soort werk vermeldt men echter niet: er zijn grofweg twee categorieën effecten te onderscheiden en al eerder werd voorspeld dat een GPU het visuele deel (rook, water, vonken, etc.) veel beter zou kunnen afhandelen dan andere taken zoals zwaartekracht, bewegingen en botsingen. De Havok-engine kan dit alles sowieso aan, maar of ook echt alles zoveel sneller gaat op een Radeon dan op de PhysX PPU valt nog te bezien.

ATi is in ieder geval niet de enige die vertrouwen heeft geuit in de technieken van Havok: ook nVidia werkt met ze samen om deze vorm van natuurkunde-versnelling naar de GeForce te brengen, waardoor de nieuwe hardware van Ageia - die in tegenstelling tot een videokaart geen enkele andere functie kent - in een benarde positie terechtkomt tussen twee gevestigde namen. Het bedrijf mag dan wel een voorsprong hebben genomen, maar echt overtuigende spellen zijn er nog niet en het product is dan ook nog lang niet zeker van een permanente positie in high-end spelmachines. In sommige gevallen is zelfs gebleken dat de videokaart moeite heeft om de extra complexe spelwerelden die PhysX kan simuleren op het scherm te tekenen en dat de prestaties hierdoor juist achteruit gaan in plaats van vooruit. Concurrentie vanuit de videokaarten zelf zal het alleen maar moeilijker maken om een voet aan de grond te krijgen.

/i/1166184322.png?f=fpa)

/i/1203101875.png?f=fpa)

/i/1122632544.png?f=fpa)