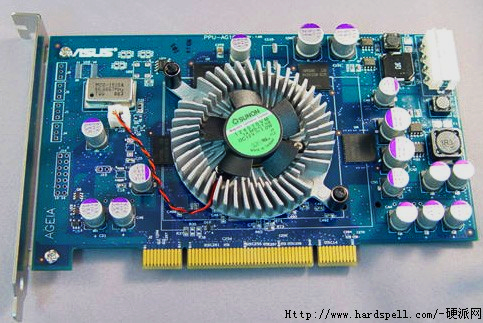

Op de Chinese website Hardspell.com zijn de eerste foto's te vinden van de Asus PhysX-kaart. Deze kaart moet de cpu ondersteunen bij het berekenen van natuurkundige effecten in spellen. Hierdoor zouden spellen een stuk realistischer moeten worden. De kaart van Asus lijkt qua lay-out veel op een grafische kaart die in een PCI-slot kan worden gestoken. Opvallend detail is de aanwezigheid van een molex-connector voor de voeding. Deze is nodig omdat de processor 20W aan energie verbruikt. In de toekomst zullen spellen als Unreal Tournament 2007 en andere spellen met de Unreal Engine 3.0, Bet on Soldier: Blood Sport, Dogtag en Sacred gebruik kunnen maken van de PhysX-processor. Huidige spellen, waaronder Half-Life 2, die gebruik maken van de NovodeX-API zouden ook gebruik kunnen maken van de PhysX-processor. De Asus PhysX zou met kerst in de winkel moeten liggen. Hoeveel deze echter moet gaan kosten is niet bekend.

483px; height: 323px;" title="Asus PhyxX" alt="Asus PhyxX">

483px; height: 323px;" title="Asus PhyxX" alt="Asus PhyxX">