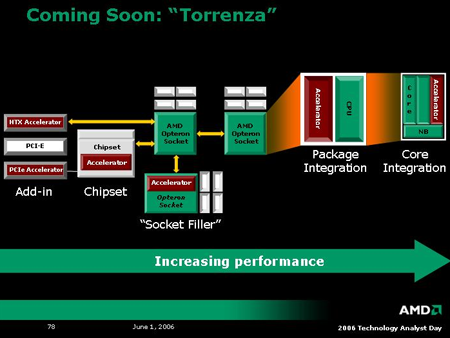

Tegelijkertijd met de introductie van het 4x4-platform heeft AMD aangekondigd delen van de architectuur van de volgende generatie Opterons openbaar te maken. Onder de noemer 'Torrenza' heeft AMD een platform ontwikkeld waarin derden de Opteron kunnen aanvullen met specifieke co-processors. Net zoals er nu toegewijde processors zijn voor grafische taken, wil AMD het zo eenvoudig mogelijk maken om extra rekenkracht aan een systeem toe te voegen voor andere taken. Deze zogenoemde 'accelerators' worden in een losse socket geplaatst en communiceren met de processor via - bij voorkeur - AMD's HyperTransport-architectuur. In een latere fase zouden de accelerators ook op de core zelf geïntegreerd kunnen worden. Als mogelijke toepassingen kan bijvoorbeeld aan een speciale chip voor VoIP, Java, XML of het (de)coderen van media gedacht worden. Torrenza zou overigens voor AMD pas het begin zijn: het bedrijf zegt naar een modulaire structuur toe te willen, waarin ook onderdelen als een geheugencontroller door klanten gekozen kunnen worden.