Uit een eerste testreeks kan worden geconcludeerd dat de Radeon HD 4870 X2 de Geforce GTX 280 van nVidia onttroont als snelste videokaart. De druk ligt nu op de schouders van de driverontwikkelaars van AMD.

Met de Radeon HD 3xx0-serie wist AMD al de aandacht op zich te vestigen, maar de nieuwe Radeon HD 4850 en HD 4870 verslaan de nVidia-videokaarten niet alleen op prijs/prestatie-verhouding: de laatste weet zelfs het prestatieniveau van de 100 dollar duurdere Geforce GTX 260 te evenaren. De prestaties van de Geforce GTX 280 bleken echter een stap teveel.

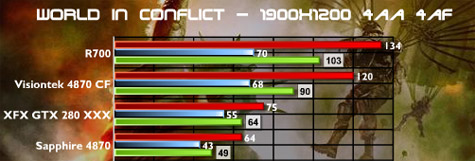

Met de komst van de Radeon HD 4870 X2-videokaart, met daarop twee RV770-gpu's en 2GB gddr5-geheugen, moet hier echter verandering in komen. De eerste tests op onder meer Anandtech, PC Perspective en Driverheaven tonen aan dat de HD 4870 X2 met een verwachte adviesprijs van iets boven de 500 dollar, de vergelijkbaar geprijsde GTX 280 in de meeste games voor blijft, vaak met ruime marge. Alleen in Crysis moet de AMD-videokaart zijn meerdere erkennen in de snelste nVidia-videokaart. De HD 4870 X2 wint het nipt van twee losse HD 4870-videokaarten in Crossfire-opstelling, waarschijnlijk geholpen door de extra gigabyte geheugen van de HD 4870 X2. Wat verder opvalt is de uitstekende schaling van de prestaties van de enkele HD 4870 naar de HD 4870 X2, die in sommige gevallen meer dan 90 procent bedraagt. Volgens de testers staat of valt alles echter nog steeds met de aan- of afwezigheid van een Crossfire-profiel voor de games. De high-end AMD-videokaart zal waarschijnlijk eind augustus worden uitgebracht.

Het energieverbruik van de HD 4870 X2 ligt op vol vermogen ongeveer 100W hoger dan de vorige dual-gpu-kaart, de HD 3870 X2, terwijl een enkele GTX 280 nog iets minder verbruikt. Omdat de bios van de AMD-kaart nog niet helemaal klaar was - wat de reden was waarom Powerplay, de energiebesparende technologie van AMD, nog niet werkte - konden de testers nog geen energieverbruik voor systemen in rust optekenen. Net als bij de gewone HD 4850 en HD 4870 zal AMD de temperatuur van de gpu's op de HD 4870 X2 constant tussen 80 en 90 graden moeten houden, ongeacht de grafische belasting. Een goede luchtaan- en -afvoer in de computerkast is dus essentieel.

/i/1218452064.png?f=fpa)

:strip_exif()/i/1213639478.gif?f=fpa)

/i/1214415351.png?f=fpa)

/i/1214223517.png?f=fpa)

/i/1213898816.png?f=fpa)

/i/1213452309.png?f=fpa)

/i/1209113511.png?f=fpa)