Tijdens het VLSI-symposium dat dinsdag op Hawaii van start gaat, presenteert Intel verschillende papers over nieuwe technieken op het gebied van chipdesign en procestechnologie.

Op het symposium zal Intel onder meer een nieuw type 'floating body cell'-geheugen uit de doeken doen. Fbc-geheugen wordt gezien als een potentiële kandidaat om embedded dram of cachegeheugen te vervangen omdat voor een enkele geheugencel slechts één transistor nodig is. Ter vergelijking: voor sram zijn zes transistors nodig per geheugencel terwijl dram-geheugen één transistor en één condensator nodig heeft. Het weglaten van de condensator is mogelijk doordat transistors die middels een soi-procedé gebakken zijn, ook lading kunnen opslaan.

In 2006 presenteerde Intel het eerste fbc-geheugen, dat gebruikmaakt van twee gates. De nieuwe geheugencel gebruikt slechts één gate en is volgens Intel aanzienlijk kleiner dan de tot nu toe gepubliceerde fbc-geheugens. Het geheugen is geschikt voor chips die gebakken worden met een 15nm-procedé en een enkele geheugencel is kleiner dan een honderdste vierkante micrometer.

In 2006 presenteerde Intel het eerste fbc-geheugen, dat gebruikmaakt van twee gates. De nieuwe geheugencel gebruikt slechts één gate en is volgens Intel aanzienlijk kleiner dan de tot nu toe gepubliceerde fbc-geheugens. Het geheugen is geschikt voor chips die gebakken worden met een 15nm-procedé en een enkele geheugencel is kleiner dan een honderdste vierkante micrometer.

Naast het fbc-geheugen zal Intel ook verschillende technieken uit de doeken doen die het energieverbruik moeten verminderen en de prestaties moeten maximaliseren. Door variaties in het productieprocedé, het voltage of de temperatuur is er een zekere marge tussen het minimale voltage dat een chip nodig heeft om correct te functioneren en het daadwerkelijke voltage dat gebruikt wordt. Een stap om het gat tussen deze twee waardes te dichten is de ontwikkeling van een robuust type sram-geheugen dat overweg kan met deze variaties. Het nieuwe type geheugen zou zesentwintig keer betere foutkarakteristieken hebben waardoor een lager voltage gebruikt kan worden.

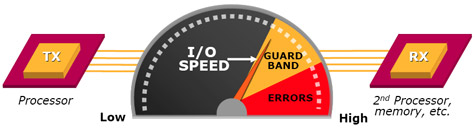

Ook bij de bepaling van de maximale snelheid van de communicatie tussen verschillende chips wordt uitgegaan van een zekere veiligheidsmarge. Om dichter bij de maximaal haalbare snelheid te komen wil Intel de chips uitrusten met logica die onder andere de jitter op het communicatiesignaal meet zodat de optimale timings en kloksnelheden kunnen worden gekozen. Verder zal Intel tijdens het symposium meer details vrijgeven over de microarchitectuur van de Nehalem en het 45nm high-k + metal gate productieprocedé dat gebruikt zal worden om deze processor te fabriceren.

/i/1297430422.png?f=fpa)

/i/1253695573.png?f=fpa)

/i/1250157415.png?f=fpa)

/i/1200408445.png?f=fpa)

/i/1215543822.png?f=fpa)

/i/1213953071.png?f=fpa)