Innovative Silicon heeft een tweede klant gevonden voor zijn Zram-techniek. Na eerst de interesse van AMD te hebben gewekt, heeft nu ook Hynix een bedrag met zeven nullen betaald voor een licentie.

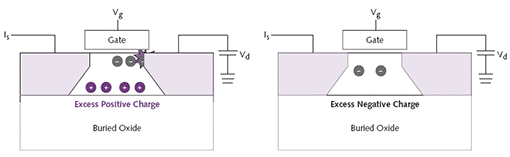

Zram maakt gebruik van de unieke eigenschappen van soi-wafers om informatie in één transistor op te slaan. Voor traditionele geheugens en caches is veel meer nodig: dram gebruikt twee transistors per bit en sram heeft er zelfs zes per bit nodig. Het voordeel is dus dat er meer informatie op hetzelfde oppervlak gestopt kan worden.

Nadelen zijn er echter ook: met name de eerste generatie werd geplaagd door een lage snelheid (100MHz) en zelfs 'vergeetachtigheid', waardoor opgeslagen data na een tijdje onleesbaar werd. In de tweede generatie is de betrouwbaarheid en snelheid behoorlijk verbeterd, waardoor inmiddels 500MHz mogelijk is.

Hynix gaat de komende twee jaar intensief met de patenthouders bij Innovative Silicon samenwerken om zram-geheugens te ontwikkelen die compatible zijn met standaard ddr3-gleuven. Men gelooft na een jaar van vooronderzoek dat zram een revolutie binnen de geheugenmarkt kan worden. Een concrete datum waarop het feest kan beginnen wil men echter nog niet noemen.

AMD zou volgens sommige geruchten zram willen gebruiken als L3-cache, maar heeft officieel niets meer gezegd dan dat het de technologie aan het bestuderen is.

/i/1204897246.png?f=fpa)