Nvidia heeft maandag de langverwachte Geforce GTX 260 en 280 aangekondigd. De kaarten zijn gebaseerd rond de GT200-chip die bijna tweemaal zoveel shaderprocessors bevat als de vorige generatie.

De GT200 bouwt verder op het ontwerp van de G80 en G92 die respectievelijk gebruikt worden voor de Geforce 8800 GTX en de Geforce 8800 GT. De architectuur van de chip is op verschillende punten aangepast en verbeterd, maar de belangrijkste verandering is het toegenomen aantal shaderprocessors. De chip beschikt nu over 240 rekeneenheden, een toename van 87,5 pocent ten opzichte van de 128 shaderprocessors van de G80/G92. Het aantal texture address units en het aantal texture filtering units is echter niet rechtevenredig toegenomen: namelijk van 64 naar 80, een toename van ‘slechts’ 25 procent.

:fill(white)/i/1213637296.jpg?f=thumb) Naast deze twee in het oog springende verbeteringen zijn er op tal van vlakken ook kleinere veranderingen doorgevoerd. De chip beschikt nu bijvoorbeeld over twee extra rop's voor een totaal van acht waardoor in totaal 32 pixels per klok geproduceerd kunnen worden. Andere verbeteringen zijn onder andere het verdubbelen van het aantal registers waarover de shaderprocessors kunnen beschikken, de maximale precisie waarop floating point berekeningen uitgevoerd kunnen worden en tweaks ten behoeven van de efficiëntie van de chip. DirectX 10.1-ondersteuning is evenwel nog steeds niet aanwezig.

Naast deze twee in het oog springende verbeteringen zijn er op tal van vlakken ook kleinere veranderingen doorgevoerd. De chip beschikt nu bijvoorbeeld over twee extra rop's voor een totaal van acht waardoor in totaal 32 pixels per klok geproduceerd kunnen worden. Andere verbeteringen zijn onder andere het verdubbelen van het aantal registers waarover de shaderprocessors kunnen beschikken, de maximale precisie waarop floating point berekeningen uitgevoerd kunnen worden en tweaks ten behoeven van de efficiëntie van de chip. DirectX 10.1-ondersteuning is evenwel nog steeds niet aanwezig.

Al deze extra rekenkracht heeft echter wel geresulteerd in een verdubbeling van het aantal transistors. De GT200 bevat maar liefst 1,4 miljard transistors, die nog gebakken worden met een 65nm-procedé. Hiermee heeft nVidia de dubieuze eer in handen om de grootste chip te hebben ontworpen die ooit is geproduceerd door fabricagepartner TSMC. Desondanks blijkt uit de tests dat de energieconsumptie van de kaart binnen de perken is gebleven wanneer de kaart idle is: zowel de GTX 260 en GTX 280 gebruiken nauwelijks meer dan de GeForce 8800 GT. Onder belasting is het echter een ander verhaal en weet de GTX 280 meer te verbruiken dan de Radeon HD 3870 X2, terwijl de GTX 260 meer verbruikt dan een Geforce 8800 GTX.

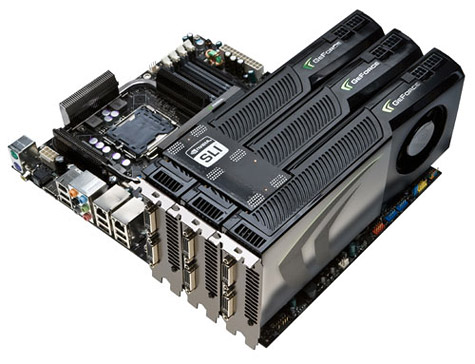

Niet geheel verrassend blijkt de GTX 280 in de benchmarks de snelste singlecore-videokaart te zijn, met de GTX 260 op een goede tweede plaats. De Radeon HD 3870 X2 blijkt echter een gewaagd aan de GTX 260 terwijl de GTX 280 regelmatig voorbijgestreefd wordt door nVidia's eigen Geforce 9800 GX2. Desondanks is de adviesprijs voor de GTX 280 een forse 649 dollar terwijl de GTX 260 nog altijd 399 dollar moet opbrengen. AnandTech concludeert dan ook dat er weinig goede redenen zijn om één van beide kaarten aan te schaffen: voor minder geld zijn snellere alternatieven verkrijgbaar, zoals twee Geforce 8800 GT-kaarten in een sli-opstelling.

/i/1234015072.png?f=fpa)

:strip_exif()/i/1123776957.jpg?f=fpa)

:strip_exif()/i/1221674914.gif?f=fpa)

:strip_exif()/i/1192102413.jpg?f=fpa)

:strip_exif()/i/1213639478.gif?f=fpa)

/i/1208164214.png?f=fpa)