Fujitsu beweert dat het de capaciteit van harddisks met een factor vijf kan vergroten dankzij de 'patterned media'-technologie. In theorie zou een verhonderdvoudiging ook mogelijk zijn, maar wanneer de technologie op de markt komt is nog onbekend.

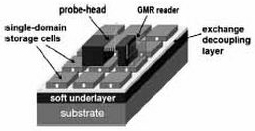

Het nadeel van de huidige harde schijven is dat de magnetische laag, waarop data wordt opgeslagen, één geheel is. Daardoor kan het gebied waarin een databit wordt opgeslagen, vrij eenvoudig invloed uitoefenen op andere gebiedjes. Als de afstand tussen twee bits te klein wordt, kan overspraak optreden, wat tot dataverlies leidt. Dit fenomeen staat bekend als de 'superparamagnetische limiet'. Met perpendiculaire opslag kunnen bits dichter opeen geplaatst worden, maar ook die techniek heeft last van de superparamagnetische begrenzing. Bij patterned media zijn er echter fysiek gescheiden eilandjes waarop de data wordt opgeslagen, en dat maakt een radicale vergroting van de maximale opslagcapaciteit mogelijk.

Het nadeel van de huidige harde schijven is dat de magnetische laag, waarop data wordt opgeslagen, één geheel is. Daardoor kan het gebied waarin een databit wordt opgeslagen, vrij eenvoudig invloed uitoefenen op andere gebiedjes. Als de afstand tussen twee bits te klein wordt, kan overspraak optreden, wat tot dataverlies leidt. Dit fenomeen staat bekend als de 'superparamagnetische limiet'. Met perpendiculaire opslag kunnen bits dichter opeen geplaatst worden, maar ook die techniek heeft last van de superparamagnetische begrenzing. Bij patterned media zijn er echter fysiek gescheiden eilandjes waarop de data wordt opgeslagen, en dat maakt een radicale vergroting van de maximale opslagcapaciteit mogelijk.

Het huidige opslagrecord is in handen van Seagate, dat ruim vierhonderd gigabit op een vierkante inch kwijtkan - dat is ruim tweemaal zoveel als de dichtheid van commercieel verkrijgbare harde schijven. Wetenschappers denken dat de limiet van perpendiculaire opslag ongeveer een terabit per vierkante inch is, maar met patterned media zou een informatiedichtheid van maar liefst 20 tot 40 terabit op dezelfde oppervlakte kunnen worden behaald. Fujitsu zou de nieuwe technologie momenteel kunnen gebruiken voor 1Tb per vierkante inch, wat neerkomt op harde schijven van een terabyte of vijf. Op notebookschijven met een diameter van 1,8" zou met deze informatiedichtheid nog altijd een halve terabyte opslag kunnen worden geboden. Hoewel er nog met geen woord over een eventuele marktintroductie wordt gesproken, lijkt Bill Gates met zijn stelling dat blu-ray en hd-dvd mede dankzij hardeschijfopslag geen opvolgers zullen kennen, dicht bij de waarheid te zitten.

Het huidige opslagrecord is in handen van Seagate, dat ruim vierhonderd gigabit op een vierkante inch kwijtkan - dat is ruim tweemaal zoveel als de dichtheid van commercieel verkrijgbare harde schijven. Wetenschappers denken dat de limiet van perpendiculaire opslag ongeveer een terabit per vierkante inch is, maar met patterned media zou een informatiedichtheid van maar liefst 20 tot 40 terabit op dezelfde oppervlakte kunnen worden behaald. Fujitsu zou de nieuwe technologie momenteel kunnen gebruiken voor 1Tb per vierkante inch, wat neerkomt op harde schijven van een terabyte of vijf. Op notebookschijven met een diameter van 1,8" zou met deze informatiedichtheid nog altijd een halve terabyte opslag kunnen worden geboden. Hoewel er nog met geen woord over een eventuele marktintroductie wordt gesproken, lijkt Bill Gates met zijn stelling dat blu-ray en hd-dvd mede dankzij hardeschijfopslag geen opvolgers zullen kennen, dicht bij de waarheid te zitten.

/i/1196163806.png?f=fpa)

:strip_exif()/i/1169377561.jpg?f=fpa)

:strip_exif()/i/1052261955.gif?f=fpa)