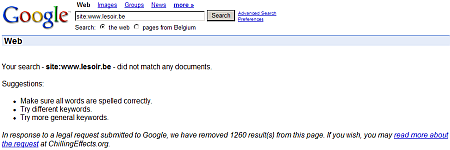

In een reactie op de eis van de rechtbank, heeft Google de links naar een aantal sites van Belgische kranten en dagbladen uit zijn index verwijderd. Diverse Frans- en Duitstalige magazines hadden zich bij de rechter erover beklaagd dat artikelen van hun site via de zoekmachine volledig te raadplegen waren, terwijl dit op de site zelf voorbehouden was aan betalende klanten van het dagblad. Het ging daarbij overigens niet uitsluitend om vermeldingen op Google News, maar ook om zoekresultaten op de gewone Google-pagina's. Naast het verwijderen van de gecachete pagina's moest Google ook het vonnis op zijn website publiceren. Een zoektocht naar artikelen van de Franstalige krant Le Soir levert dan ook een link naar dit vonnis op.

Aangezien het vonnis in Brussel door een Belgische rechtbank uitgesproken werd, zijn de internationale versies van de zoekmachine vooralsnog ongewijzigd te raadplegen. Bovendien gaat Google met de actie verder dan de eis die door de rechter gesteld werd. Het bedrijf werd immers slechts verplicht de gecachete pagina's niet langer raadpleegbaar te maken, maar Google besloot Le Soir geheel uit zijn Belgische index te verwijderen. Het lijkt dan ook aannemelijk Google hiermee een wraakactie wil ondernemen, gezien websites over het algemeen net hun best doen om zo hoog mogelijk in de zoekresultaten te verschijnen.

:strip_exif()/i/1158539251.gif?f=fpa)

/i/1210666281.png?f=fpa)

/i/1154672443.png?f=fpa)

:strip_exif()/i/1211833335.gif?f=fpa)