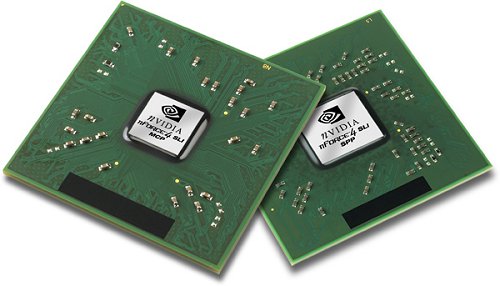

Zoals al werd verwacht heeft ook nVidia chipsets die twee PCI Express x16-slots ondersteunen aangekondigd. Van de vooral voor gamers interessante nForce4 SLI x16-chipset wordt zowel een Intel- als een AMD 64-variant verwacht. Dit nieuws komt niet onverwacht: Dells XPS 600, waar we eerder over berichtten, zal met de nieuwe nVidia-telg worden uitgerust. De SLI x16-chipset beschikt over nVidia's nieuwe 'System Platform Processor' en 'Media and Communication Processor', die elk over 'minimaal' zestien PCI Express-lanes beschikken. Daarnaast zijn de chipsets uiteraad uitgerust met alle features waar eerdere versies ook al mee te koop liepen: RAID, Gbit ethernet met firewall, 3Gbit SATA en natuurlijk USB 2.0, FireWire, 8-kanaals AC'97 audio en natuurlijk een PCI-bus. Hoewel de Intel-variant dus op korte termijn via Dell uitgeleverd zal worden, is het nog niet duidelijk wanneer de chipsets voor andere fabrikanten beschikbaar zullen komen.

De Intel Edition-versie kan met diverse Pentium 4-, Pentium D-, Pentium EE- en Celeron D-processors overweg; naast ondersteuning voor een 1066MHz FSB en 667MHz dual channel DDR2-geheugen zijn ook 4 PCIe x1-slots beschikbaar. De AMD-versie van de nieuwe nForce4 kan overweg met dual-coreprocessors en ondersteunt 1000MHz HyperTransport-bussen, maar moet het met slechts twee PCIe x1-lanes doen. Naast de voor de hand liggende toepassing met twee grafische kaarten in SLI-opstelling is het tweede PCIe x16-slot ook geschikt voor bijvoorbeeld dual tuner-kaarten en netwerkapparatuur die de extra bandbreedte weten te waarderen. Toch blijven gamers de belangrijkste doelgroep: 'De introductie van de XPS 600 zet de SLI x16 als de nieuwe standaard voor gamesliefhebbers neer', hoopt nVidia-topman Jen-Hsun Huang.

:strip_exif()/i/1123520030.gif?f=fpa)