SURF en Nikhef zijn er in geslaagd de eerste 400Gbit/s-verbinding met CERN in Zwitserland te leggen, een afstand van 1650 kilometer. Tot nu toe was 100Gbit/s het hoogst haalbare, maar die snelheid is in de toekomst niet meer toereikend.

Het gaat om de eerste internationale 400Gbit/s-verbinding ter wereld. De verbinding met CERN verloopt over glasvezel en SURF en Nikhef hebben de eerste testen voor de stabiliteit met succes afgerond. De verbinding volgt op een geslaagde pilot op een 400Gbit/s-netwerk in de randstad, vorig jaar.

De verbinding bevindt zich tussen de opslagsystemen van aan het ene uiteinde de Europese organisatie voor nucleair onderzoek CERN in Zwitserland en aan de andere kant Nikhef, het Nederlandse Nationaal instituut voor subatomaire fysica. Via een switch gaat de verbinding het optisch DWDM-systeem van SURF in, dat verantwoordelijk is voor het belichten van de glasvezel. Het opzetten van een verbinding met zo'n hoge bandbreedte is niet triviaal, vertelt Tristan Suerink, IT-architect bij Nikhef aan Tweakers.

"Voor 400Gbit/s moeten je glasvezels heel erg schoon zijn, elk klein vuiltje geeft al problemen." Bij de eerste testen van de verbinding duurde het drie kwartier voor deze succesvol kon worden opgezet. De oorzaak bleek bij een vieze vezel te liggen. "Dan moet je aan de slag met een glasvezelcleaner, die lijkt op een knijpkat en kan met een microvezeldoekje de vezel schoonmaken. Voor 10Gbit/s kun je de vezel bij wijze van spreken schoonmaken door deze aan je broek af te vegen. Maar om 400Gbit/s te realiseren mag je er al niet met je duim aanzitten, dan wordt deze al te vies. Je signaal-ruisverhouding op langeafstandsverbindingen is ook erg belangrijk en je moet daarvoor het verlies met elke koppeling en versterking op de lijn minimaliseren. Daar is SURF in 2019 en 2020 erg druk mee bezig geweest", aldus Suerink.

Gerben van Malenstein valt hem bij. Van Malenstein is technisch productmanager bij SURF en hij houdt zich onder andere bezig met de internationale verbindingen: "We zijn er al drie jaar mee bezig. Toen voerde onze optische expert de eerste simulaties uit om te bepalen wat het verlies zou zijn. We constateerden dat als je dat verlies wilt beperken, je zo min mogelijk fiberconnectors in de lijn wilt hebben. Deze 400Gbit/s-lijn bevat daarom zo min mogelijk van die connectorovergangen: we hebben ze zoveel mogelijk aan elkaar gelast. Ook wisten we toen al dat we flink moeten gaan versterken. Dat doen we nu met Ramanversterkers. Die hebben we voorheen op dit traject niet nodig gehad."

Nikhef converteert meerdere 100Gbit/s-signalen vanaf zijn servers om tot 400Gbit/s te komen. "Er zijn nog geen 400Gbit/s-netwerkkaarten beschikbaar. Dus vandaar op deze manier. We gebruiken voor de conversie de Juniper QFX5220; de gebruikte glasvezelmodules zijn de QSFP-56DD-FR4 en de QSFP-56DD-LR4L."

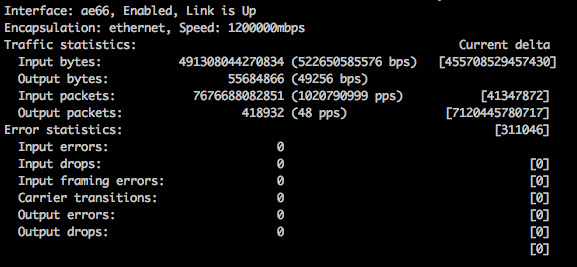

Om de grote hoeveelheid data voor het testwerk te genereren, bouwde Nikhef vorig jaar al een zogenoemde '1Bpps Machine': een systeem dat een miljard pakketjes van 64 bytes per seconde kan verzenden. In aanvulling daarop zijn dit jaar twee testsystemen gebouwd die met elke mogelijke pakketgrootte 400Gbit/s aan verkeer kunnen genereren. Suerink: "Deze zijn gebaseerd op de IBM IC922- en de Lenovo SR655-servers. Als netwerkkaarten gebruiken we Mellanox Connect-X5 kaarten."

De signalen van Nikhef en CERN komen binnen bij SURF, dat een ECI TR1200E-transponder gebruikt om dit om te zetten in een coherent DWDM-signaal voor de glasvezelverbinding. SURF ondersteunt Flex Grid op zijn netwerk om de grote hoeveelheid data door een enkel kanaal te krijgen. Van Malenstein benadrukt dat 400Gbit/s een service over de lijn is. "De hele lijn is aangepast om deze 400Gbit/s mogelijk te maken, maar het gaat om dezelfde glasvezel als de bestaande 100Gbit/s-services. Er komt grijs licht binnen vanuit CERN en Nikhef en per service wijzen wij een golflengte op het internationale DWDM-systeem tussen CERN en Nikhef toe. Als je een nieuwe 400Gbit/s-service wil aanbieden, moet er een nieuw setje transponders bij. Je kunt het zien als dat er een nieuw kleurtje op de glasvezel bijkomt."

Suerink: "Ter vergelijking: in 2017 testten met een DWDM-verbinding op een 'oude' vezelkabel met een oude connector en toen kwamen we tot maximaal 150Gbit/s per kleurtje." Volgens Van Malenstein is het volgende doel om 1Tbit/s te behalen, door meerdere 400Gbit/s-golflengtes te combineren.

Nikhef is het Nationaal instituut voor subatomaire fysica en is al vanaf de start van de deeltjesversneller verbonden met de LHC, via een verbinding van SURF. De deeltjesversneller levert enorme hoeveelheden data op. Nikhef en SURF vormen een van de dertien tier 1-locaties wereldwijd waar die data terechtkomt voor verdere analyse en opslag. CERN zelf is de tier 0-locatie.

:strip_exif()/i/2004091312.jpeg?f=imagenormal)

De enorme bandbreedte van een 400Gbit/s-verbinding is nu nog niet nodig, maar dat gaat veranderen. Dit jaar komt een einde aan Long Shutdown 2, een periode van meer dan twee jaar waarin CERN upgrades aan de Large Hadron Collider doorvoerde. Dan kan Run 3 beginnen, een reeks van nieuwe experimenten met de deeltjesversneller, mits er geen vertraging komt door de coronacrisis.

Tijdens Run 2, die van 2014 tot en met 2018 duurde, leverde de LHC gemiddeld zo'n 8Gbit/s aan data, met pieken tot boven de 10Gbit/s. De verwachting is dat dit bij Run 3 gaat verdubbelen. Daarna volgt een nieuwe Long Shutdown, om de LHC om te bouwen tot de High Luminosity LHC, of HL-LHC. CERN zet de vernieuwde versneller in 2027 in gang en bij die Run 4 moet nog eens vijf keer zoveel data gegeneerd worden, oftewel tien keer zoveel als bij de laatste run.

De grote vloedgolf aan data komt dus pas op zijn vroegst over zes a zeven jaar. Waarom dan nu al testen met enorm veel meer bandbreedte? Van Malenstein: "Deze een-op-een-verbinding met CERN is voor ons echt maatwerk. We maken gebruik van de nieuwste technologie voor onderwijs en onderzoek. We zijn de operator van lijnen en een exchange in Amsterdam. Die exchange is NetherLight. Dat is een open knooppunt voor glasvezelverbindingen waar internationale partijen voor onderwijs en onderzoek zich op aan kunnen sluiten. We lopen daarmee al eens tegen de grens van 100Gbit/s aan en het doel is om binnen een jaar naar 400Gbit/s en op termijn tot 1Tbit/s te gaan. De verbinding met CERN is een manier voor ons om te testen, maar verschillen zijn er momenteel ook, want er zit bijvoorbeeld nog geen ethernetswitch tussen. Die zijn er nog niet. Voor NetherLight gaan we die wel gebruiken. De hardware voor 400Gbit/s-switching, een Juniper MX10008, is al gekocht, maar we wachten nog op de 400Gbit/s-kaarten. De verbinding met CERN moet straks ook via het Netherlight-knooppunt verlopen."

Wie bij de omschrijving van NetherLight aan de AMS-IX denkt, denkt in de goede richting. SURF is samen met Nikhef medeoprichter van de Amsterdam Internet Exchange en NetherLight moet net zo succesvol als dat knooppunt worden, maar dan voor lichtpaden. Om dat te realiseren wil SURF voorop blijven lopen met technologie. Eerder maakte de organisatie zo de eerste intercontinentale 100Gbit/s-verbinding via NetherLight mogelijk.

Voor Nikhef is de reden iets anders. Suerink: "Voor ons is het noodzakelijk om voorbereid te blijven. We weten inmiddels, met de vroege nieuwe van technologie blijft het gedoe. Je constateert dan dat hardware van verschillende merken nog niet goed op elkaar aan te sluiten is, je komt dingen tegen als vuile vezels, enzovoorts. En we weten inmiddels ook over de experimenten met CERN: ze willen zo hard mogelijk gaan."

/i/2007013630.png?f=fpa)

:strip_exif()/i/2005022306.jpeg?f=fpa)

:strip_exif()/i/1298541741.gif?f=fpa)

/i/1229769740.png?f=fpa)

/i/2004317866.png?f=fpa)

:strip_exif()/i/1307622149.gif?f=fpa)

:strip_exif()/i/2002465936.jpeg?f=fpa)

:strip_exif()/i/1237906277.gif?f=fpa)