De in 2011 te introduceren Bulldozer- en Bobcat-processors waren lange tijd onderwerp van speculatie, maar tijdens Hot Chips 22 heeft AMD eindelijk details over de nieuwe architecturen vrijgegeven.

De op prestaties gerichte Bulldozer-architectuur is bedoeld voor desktops, servers en high-end notebooks. De eerste Bulldozer-processors zouden door GlobalFoundries op 32nm worden geproduceerd en aanvankelijk voor de servermarkt worden gemaakt; desktop-cpu's zouden later volgen. Het zou gaan om processors met vier tot zestien cores, terwijl de sockets en tdp's gelijk zouden zijn aan die van de huidige Magny-Cours-serverprocessors.

De processors zijn opgebouwd uit modules van twee cores. Deze cores hebben hun eigen L1-cache en integer scheduler, maar delen het gros van de overige logica. De L2-cache is gedeeld binnen de modules, terwijl de L3-cache en de geheugencontroller door verschillende modules worden gedeeld. Elke core heeft vier integer-pipelines, een gedeelde floating point scheduler en twee 128bit-fmac's, die ook als een enkele 256bit-fmac dienst kunnen doen en die de nieuwe fma4-floating-point-instructies kunnen uitvoeren.

Een extra core zou op moduleniveau slechts twaalf procent extra silicium vergen; op processorniveau is dat zelfs maar vijf procent. Dankzij de modulariteit en de gedeelde logica zouden de prestaties van de Bulldozer-processors tot vijftig procent hoger kunnen zijn zonder dat de complexiteit en de kosten te groot worden. Ook het energieverbruik en de warmteontwikkeling zouden opmerkelijk laag zijn.

Een interessante eigenschap is dat de modules transparant voor het besturingssysteem zouden zijn, zodat verschillende cores tegelijk aan een enkele thread kunnen werken. Daarmee zou AMD een concurrent voor Intels HyperThreading hebben ontwikkeld.

/i/1282653887.png?f=imagenormal)

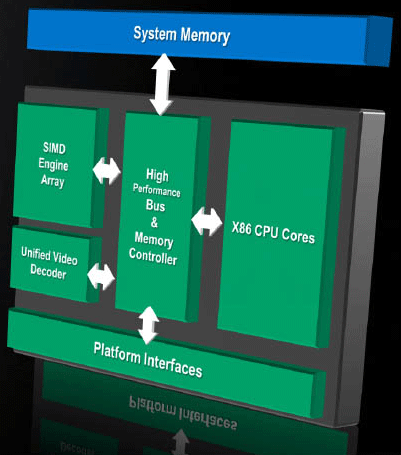

Ook van de Bobcat-architectuur zouden in 2011 de eerste op 32nm geproduceerde processors verschijnen. Deze Ontario-cpu's zouden een geïntegreerde videochip en dito geheugencontroller hebben en worden door AMD daarom apu genoemd. De zuinige Ontario is ontworpen voor laptops, netbooks en nettops.

Volgens AMD zouden de Bobcat-cpu's per core minder dan 1W verstoken. Anders dan de Atom-processors van Intel, die een vergelijkbare markt bedienen, ondersteunen de Ontario-apu's out-of-order instructies, wat ze significant sneller zou maken. Een Bobcat-core bestaat uit zes pipelines: twee voor integerberekeningen, één load-pipe, één store-pipe en twee floating point-pipelines. Elke core heeft zijn eigen L1- en L2-cache, maar de geheugencontroller, de gpu en overige componenten zoals de systeembussen worden weer door de cores gedeeld.

/i/1251207549.png?f=fpa)

:strip_exif()/i/1295600046.gif?f=fpa)

:strip_exif()/i/1269505912.jpeg?f=fpa)

/i/1225791484.png?f=fpa)

/i/1253627114.png?f=fpa)

/i/1241443636.png?f=fpa)

:strip_exif()/i/1265815969.jpeg?f=fpa)

/i/1242207182.png?f=fpa)

/i/1240489321.png?f=fpa)