Nvidia heeft zijn nieuwe gpu-architectuur 'Fermi' gepresenteerd. De fabrikant spreekt zelf van de grootste stap voorwaarts sinds de G80. De focus ligt bij Fermi op Cuda en de architectuur lijkt vooral gericht op gebruik in supercomputers.

De verwachting was dat Fermi het antwoord zou worden op AMD's ATI Radeon HD 5000-introductie, maar het enige wat Nvidia met betrekking tot gaming liet weten was dat de architectuur DirectX 11 ondersteunt en dat de videokaart op basis van Fermi sneller zal worden dan de HD 5870. De presentatie van Nvidia concentreerde zich dan ook op de betekenis van de Fermi-architectuur voor de Tesla-kaarten die in supercomputers gebruikt kunnen worden.

De verwachting was dat Fermi het antwoord zou worden op AMD's ATI Radeon HD 5000-introductie, maar het enige wat Nvidia met betrekking tot gaming liet weten was dat de architectuur DirectX 11 ondersteunt en dat de videokaart op basis van Fermi sneller zal worden dan de HD 5870. De presentatie van Nvidia concentreerde zich dan ook op de betekenis van de Fermi-architectuur voor de Tesla-kaarten die in supercomputers gebruikt kunnen worden.

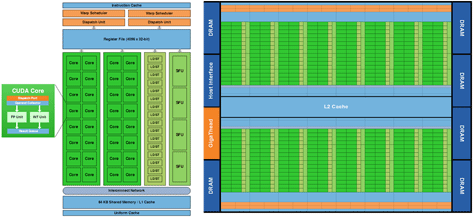

Fermi wordt op hetzelfde 40nm-procedé van TSMC als de RV870 van AMD's 58xx-serie videokaarten gebouwd. De chip krijgt echter 3 miljard transistors, waar de RV870-gpu van AMD 2,15 miljard transistors heeft en de huidige GT200-chip van Nvidia het met 1,4 miljard schakelingen moet doen. Er zijn 512 cores, die Nvidia 'Cuda Cores' noemt, die gegroepeerd zijn in blokken van 32. Elk blok van 32 cores beschikt over 64KB geheugen, dat als gedeeld geheugen of L1 cache geconfigureerd kan worden.

De hoeveelheid L2 cache-geheugen is een tussen de blokken gedeelde 768KB, waarmee de totale hoeveelheid geheugen van de Fermi-chip op 256KB tot 768KB L1-cache en 768KB L2-cache komt. De gpu kan via zijn 384bit-geheugenbus maximaal 6GB gddr5-geheugen aanspreken. De GT200 had een 512bit-geheugeninterface en werd met gddr3 uitgerust. Volgens AnandTech zou de die-size van Fermi, gezien het aantal transistors en het productieprocedé, op 467 vierkante millimeter uit kunnen komen. Wanneer de chips in het eerste kwartaal van 2010 verschijnen, zal de definitieve die-grootte duidelijk worden.

De Fermi-chip zal wat de consumentenmarkt betreft in het hogere prijssegment als desktopkaart ingezet worden, met afgeleiden die de mainstreammarkt moeten bedienen. Dit is de strategie die Nvidia ook in het verleden hanteerde. Primair moet Fermi echter als gpgpu dienst doen: Tesla-kaarten met de chip kunnen via in C++ geschreven programma's aangestuurd worden en bieden verbeterde ondersteuning voor Visual Studio. Bovendien biedt Fermi als eerste videokaart-architectuur ondersteuning voor ecc-geheugen in de registers, L1 en L2-caches en het dram, wat de data-integriteit van hpc-toepassingen moet verbeteren.

Nvidia zegt vooral van het mobiele platform Tegra en supercomputerplatform Tesla afhankelijk te zijn wat de groei in 2010 betreft: met name Tesla moet een exponentiele groei door gaan maken die door Fermi mogelijk gemaakt zou worden. Dubbele groeipercentages zouden overigens niet bijzonder lastig realiseerbaar moeten zijn: Tesla zorgde afgelopen kwartaal voor een omzet van slechts tien miljoen dollar.

| GPU | G80 | GT200 | Fermi |

|---|---|---|---|

| Transistors | 681 miljoen |

1,4 miljard |

3 miljard |

| Cuda Cores |

128 |

240 |

512 |

| Double precision fp |

- |

30 fma ops/clock |

256 fma ops/clock |

| Single precision fp |

128 mad ops/clock |

240 mad ops/clock | 512 fma ops/clock |

| Warp schedulers/ sm |

1 |

1 |

2 |

| Special Function Units/ sm |

2 |

2 |

4 |

| Shared memory/ sm |

16KB |

16KB |

48KB of 16KB (in te stellen) |

| L1 cache |

- |

- |

48KB of 16KB (in te stellen) |

| L2 cache |

- |

- |

768KB |

| ECC-ondersteuning | Nee |

Nee |

Ja |

| Gelijktijdige kernels |

Nee |

Nee |

Maximaal 16 |

:strip_icc():strip_exif()/i/1291899088.jpeg?f=fpa_thumb)

:strip_icc():strip_exif()/i/1263808600.jpeg?f=fpa_thumb)

:strip_exif()/i/1295600046.gif?f=fpa)

:strip_exif()/i/1123776957.jpg?f=fpa)

/i/1279715721.png?f=fpa)

/i/1269100785.png?f=fpa)

/i/1274867038.png?f=fpa)

/i/1269640903.png?f=fpa)

/i/1267461820.png?f=fpa)

/i/1208164214.png?f=fpa)

:strip_exif()/i/1212428440.gif?f=fpa)

/i/1262341213.png?f=fpa)

/i/1206089508.png?f=fpa)

:strip_exif()/i/1178734870.jpg?f=fpa)

/i/1237031931.png?f=fpa)

/i/1228815558.png?f=fpa)

/i/1239375893.png?f=fpa)

/i/1237635048.png?f=fpa)

:strip_exif()/i/1172864853.gif?f=fpa)

/i/1232550384.png?f=fpa)