Supercomputerfabrikant Cray heeft een vloeistofkoelsysteem geïntroduceerd dat efficiënter warmte uit supercomputers zou afvoeren dan bestaande methoden. Hierdoor kan een rekencentrum energie besparen en meer computers plaatsen.

Het nieuwe koelsysteem is door Cray 'Ecophlex' gedoopt, waarbij 'phlex' staat voor phase-change liquid exchange. Volgens de fabrikant van hpc-oplossingen kunnen supercomputers met behulp van een Ecophlex-systeem efficiënter gekoeld worden. In veel rekencentra lozen systeemkasten de gegenereerde hitte met behulp van fans naar de omliggende ruimte, waarna airconditioning de warme lucht afvoert en weer koelt met behulp van koud water. Volgens Cray is dit veel toegepaste systeem echter inefficiënt, nauwelijks schaalbaar en neemt het kostbare ruimte binnen rekencentra in beslag.

Het nieuwe koelsysteem is door Cray 'Ecophlex' gedoopt, waarbij 'phlex' staat voor phase-change liquid exchange. Volgens de fabrikant van hpc-oplossingen kunnen supercomputers met behulp van een Ecophlex-systeem efficiënter gekoeld worden. In veel rekencentra lozen systeemkasten de gegenereerde hitte met behulp van fans naar de omliggende ruimte, waarna airconditioning de warme lucht afvoert en weer koelt met behulp van koud water. Volgens Cray is dit veel toegepaste systeem echter inefficiënt, nauwelijks schaalbaar en neemt het kostbare ruimte binnen rekencentra in beslag.

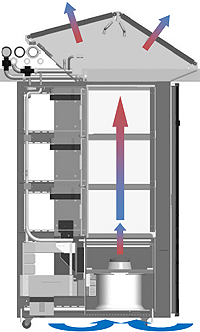

De Ecophlex-koeltechnologie, die als optie bij de XT5-systeemkasten van Cray wordt aangeboden, werkt volgens hetzelfde principe als traditionele koelsystemen, maar zou aanmerkelijk minder vloeistof nodig hebben en tot tien keer meer warmte af weten te voeren. De gegenereerde hitte, afkomstig van de racks die in de systeemkast draaien, kan worden afgevoerd door de kasten te koppelen aan externe waterkoelsystemen of middels het afvoeren van warme lucht via verticale airconditioning. Hierdoor blijft de temperatuur in de directe omgeving van de systeemkasten vrijwel constant.

De warmte-ontwikkeling van supercomputers kan binnen de perken gehouden worden door minder krachtige processors te gebruiken of door de klokfrequentie ervan te verlagen. Hierdoor werken systemen echter niet op volle kracht, waardoor de schaalbaarheid en kostenefficiëntie van een hpc-computers niet ten volle wordt benut, zo meldt Cray. De fabrikant claimt dat zijn Ecophlex-technologie dergelijke noodgrepen overbodig maakt. Bovendien zouden de kasten gewoon kunnen blijven staan als verouderde hardware door een nieuwe generatie rekenmachines wordt vervangen.

/i/1306331959.png?f=fpa)

/i/1226912359.png?f=fpa)

/i/1204897246.png?f=fpa)

/i/1210666281.png?f=fpa)

:strip_exif()/i/1185544089.jpg?f=fpa)