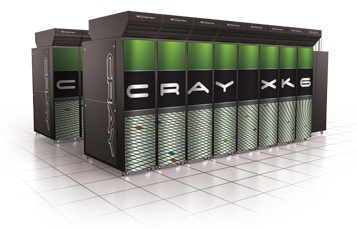

Cray, fabrikant van supercomputers, heeft een 'hybride supercomputer' aangekondigd. Het rekenmonster, XK6 geheten, gebruikt een combinatie van hexadecacore-AMD Opteron-processors en gpu's uit Nvidia's Tesla-serie.

Voor de XK6 heeft Cray gekozen voor AMD Opteron 6200-processors met elk 16 cores, codenaam Interlagos, terwijl de gpu's uit de Nvidia Tesla X2090-serie afkomstig zijn. Per serverkast kunnen maximaal 96 processors worden geplaatst, goed voor 1536 rekenkernen, in combinatie met maximaal 96 Tesla-gpu's. Per cabinet kan een maximale rekenkracht van meer dan 7 teraflops worden behaald, zo stelt Cray. Afhankelijk van de configuratie zou het verbruik tussen de 45 en 54,1kW liggen.

Volgens de fabrikant is zijn hybride supercomputer met behulp van verschillende nodes schaalbaar tot een rekencapaciteit van maximaal 50 petaflops. Volgens Cray is de XK6 door zijn schaalbaarheid en het gebruik van zowel cpu's als gpu's in combinatie met Cray's eigen Linux Environment een krachtig platform voor high performance computing-applicaties.

Het Swiss National Supercomputing Centre zal als eerste een XK6-supercomputer afnemen als vervanging voor zijn huidige XE6m-supercomputer. Het onderzoeksinstituut zal het rekenmonster inzetten voor toepassingen als klimaatsimulaties en complexe berekeningen in vakgebieden als geologie en farmacie. De organisatie denkt met de XK6 vooral te kunnen profiteren van de gpgpu-berekeningen die door de grafische Tesla-processoren van Nvidia uitgevoerd kunnen worden.

/i/1306331959.png?f=fpa)

/i/1309357282.png?f=fpa)

:strip_exif()/i/1295870878.gif?f=fpa)

/i/1275218511.png?f=fpa)

:strip_exif()/i/1234902603.gif?f=fpa)

:strip_exif()/i/1286274802.jpeg?f=fpa)

/i/1295019929.png?f=fpa)

/i/1242207182.png?f=fpa)

/i/1238771248.png?f=fpa)

/i/1216049654.png?f=fpa)

/i/1226912359.png?f=fpa)