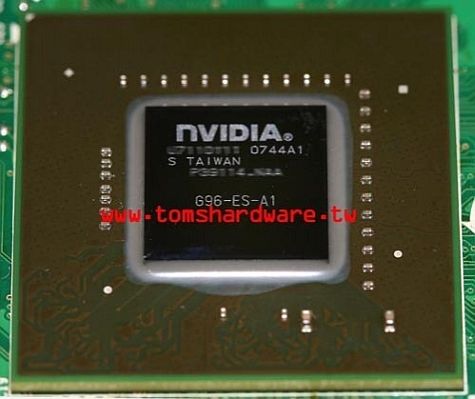

Er zijn wat details verschenen over de Geforce 9500GT van Nvidia. De kaart uit de Geforce 9-serie vormt het kleinere broertje van de 9600GT en is gebaseerd op de G96-gpu.

De kaart die Toms Hardware onder ogen kreeg, is gebouwd op het 65nm procedé en beschikt over een core die zijn werk op 650MHz doet, terwijl de shaderklok op 1650MHz draait. De betreffende referentiekaart, die over een 128-bit geheugenbus beschikt, is voorzien van 256MB ddr2-geheugen met een snelheid van 900MHz, maar het model zou ook overweg kunnen met sneller gddr3-geheugen. Verder blijkt de kaart ondersteuning te bieden voor DirectX 10.0, Opengl 2.1, Purevideo HD en pci-express 2.0, en dankzij Hybrid SLI kan bovendien een sli-opstelling gemaakt worden in combinatie met een igp.

Onbekend is nog hoeveel streamprocessors de G96-kaart mee gaat krijgen. Eveneens is onduidelijk wanneer de kaarten precies moeten gaan verschijnen, behalve dat dit in de eerste helft van dit jaar moet gaan gebeuren. De verwachting is dat de lowend-kaart de Nvidia Geforce 8600GT gaat opvolgen, aldus Toms Hardware Taiwan.

Eind december verschenen al gegevens over het eerste midrange-model uit de Geforce 9-serie, de 9600 GT. In de eerste week van 2008 doken daarop meer details en de eerste foto's op van het komende vlaggenschip van Nvidia: de 9800GX2.

/i/1208164214.png?f=fpa)

/i/1210928750.png?f=fpa)

/i/1205943054.png?f=fpa)

:strip_exif()/i/1045528068.gif?f=fpa)

/i/1199433345.png?f=fpa)

:strip_exif()/i/1123776957.jpg?f=fpa)