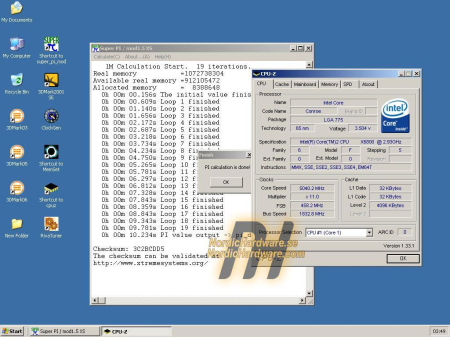

Zweedse overklokkers zijn er in geslaagd om de 5GHz-grens met een Core 2 Extreme X6800 te doorbreken. Normaal gesproken doet deze processor zijn werk op 2,93GHz bij een voltage van 1,34V. Door het voltage echter naar 1,73V te verhogen en met behulp van vloeibare stikstof de processor naar -125°C te koelen was het in eerste instantie mogelijk om 4,95GHz te bereiken. Meer zat er niet in omdat de snelheid van de FSB in het BIOS van het gebruikte Asus-moederbord niet hoger dan op 450MHz (1,8GHz effectief) kon worden ingesteld. Asus was echter bereid om een speciaal BIOS voor de Zweden te ontwikkelen waar deze limiet naar 500MHz werd opgehoogd. Gewapend met dit BIOS bleek de maximale haalbare snelheid waarop nog een SuperPi 1M-benchmark kon worden gedraaid op 5040Mhz te liggen.

Helaas was de overklok niet voldoende om een nieuw SuperPi-wereldrecord te vestigen. De overklokkers moesten dan ook genoegen nemen met een tweede plek. De eerste plaats blijft in handen van de Japanner Tam die ook gebruik maakte van een Core 2 Extreme X6800 en hiermee 5013MHz bleek te halen. Tam is waarschijnlijk de eerste tweaker ter wereld die de 5GHz-grens met de X6800 wist te doorbreken. Om deze snelheid te bereiken schakelde hij echter wel de tweede core van de processor uit, iets dat de Zweden niet gedaan hebben. Uiteraard laten de Scandinaviërs het hier niet bij zitten. Ze zullen doorgaan met het tweaken van het systeem om het SuperPi-snelheidsrecord van de Japanner te doorbreken.