XGI heeft aan Tom's Hardware Guide een sample van de Volari Duo V8 Ultra beschikbaar gesteld. Zoals gewoonlijk gaat Tom's Hardware Guide als eerste uitgebreid in op de architectuur van de Volari en voegen weinig nieuws toe aan de bespreking van de Volari door PCStats. Daarna bespreekt Tom's Hardware Guide de kaart zelf, de drivers en als laatste draaien de mannen van Tom's Hardware Guide een aantal benchmarks om te zien hoe snel de Volari is ten opzichte van de actuele nVidia- en ATi-GPU's.

De Volari Duo V8 Ultra is uitgerust met twee GPU's. Dit heeft als consequentie dat er ook twee Molex-connectors voor de voeding en twee ventilators op de kaart aanwezig zijn. Helaas bleken de twee ventilators niet in staat om de kaart onder alle omstandigheden koel te houden. Daarnaast maakten deze ventilators nogal veel geluid. XGI liet echter aan Tom's Hardware Guide weten dat ze van dit probleem bewust zijn en naar een oplossing zoeken. De referentiekaart is uitgerust met DDR2-geheugen dat op een snelheid van 450MHz draait. Het geheugen op het uiteindelijke productiemodel zal echter op 500Mhz zijn werk doen.

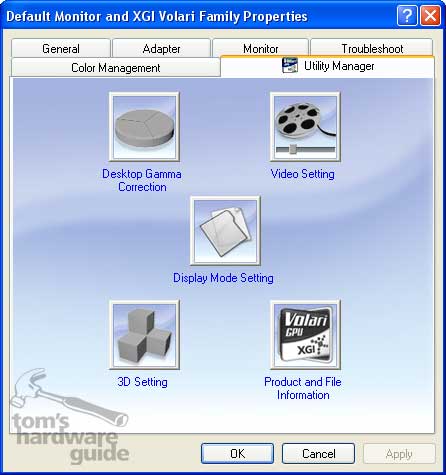

XGI heeft de drivers voor de Volari-serie van videokaarten Reactor gedoopt. De menu's van de drivers zijn erg helder en bieden veel mogelijkheden, waaronder de mogelijkheid om over te klokken. Helaas zijn de drivers nog niet helemaal af. Dat blijkt uit het feit dat onder andere anisotropic filtering en FSAA nog niet aangezet kunnen worden. Daarnaast had de driver problemen met enkele scènes van Aquamark en 3DMark 2003 en was het niet mogelijk om trilinear filtering te gebruiken. Er is dus nog flink wat werk aan de winkel voor XGI.

Maar waar het uiteindelijk allemaal om draait zijn de benchmarks. Hoewel de Volari Duo V8 Ultra respectabele scores neer zet in de flyby-demo van Unreal Tournament 2003, is het de hekkesluiter in de Inferno en Magna-timedemo van het spel. Met een 3DMark 2003-score van 5260 punten, doet de nieuwe GPU het niet slecht, ware het niet dat de kwaliteit van de gerenderde beelden te wensen over laten. In Aquamark 3 kan de videokaart van XGI goed meekomen met de snelste kaarten van ATi en nVidia maar in Halo Combat Evolved is het weer de hekkesluiter. Het lijkt er op dat de Volari vooral problemen heeft met PS2.0. Quake 3 is niet de sterkste kant van de Duo V8, hoewel de scores niet slecht te noemen zijn. In Wolfenstein is het echter weer doffe ellende, ondanks dat dit spel op de Quake-engine is gebaseerd. De laatste benchmark die wordt gedraaid is de X2 Rolling demo, waarin de Volari de laatste plaats inneemt. Daar deze benchmark veel gebruik maakt van stencil shadows, lijkt het er dus op dat de kaart ook hier problemen mee heeft.

Gezien het feit dat het hier gaat om een prototype van zowel de kaart als de drivers, is het moeilijk om een conclusie te trekken. Sommige benchmarks tonen aan dat er een hoop potentieel in de nieuwe GPU zit. Andere benchmarks tonen echter aan dat er nog een hoop werk aan de winkel is voor XGI. Hopelijk kunnen alle problemen in de drivers opgelost worden en is het geen hardware probleem, want de eerste kaarten met WHQL-gecertifieerde drivers moeten over één of twee maanden op de markt verschijnen. Met een verwachte introductieprijs van rond de $300, $100 tot $200 goedkoper dan de topkaarten van ATi en nVidia, is de Volari Duo V8 Ultra dus een geduchte concurrent om rekening mee te houden, mits de drivers in orde zijn.