In mei konden we lezen dat SiS stopte met het ontwerpen van chips voor grafische kaarten. Toch was dit niet het einde van de Xabre GPU, want de hele afdeling ging zelfstandig verder onder de naam Xabre Graphics Incorperated. Of dit een goede zet voor SiS was, is nog niet echt duidelijk, wel is duidelijk dat XGI een grote speler wilt worden. Daarvoor zullen ze echter wel de concurrentie aangaan met de huidige marktleiders, ATi en nVidia. Het was dan ook niet verwonderlijk dat XGI in september een nieuwe serie van GPU's aankondigden met de naam Volari die op papier snel genoeg zouden moeten zijn om met ATi en nVidia te concurreren.

![]() Volari V3

Volari V3

PCStats heeft ondertussen wat meer informatie weten te bemachtigen over de architectuur van de Volari. De GPU zal in vijf verschillende smaken verschijnen. Als instapmodel is er de Volari V3 die bedoeld is voor de DirectX 8.1 API. Deze GPU doet zijn werk op 300MHz, is uitgerust met twee texture-units en kan 128MB aan DDR300-geheugen aansturen via een 128bits brede bus.

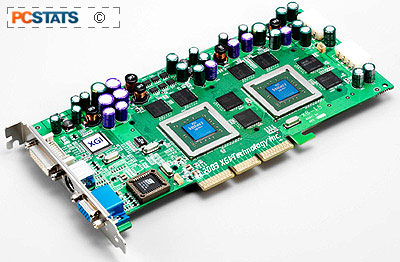

![]() Volarie V5 en V8

Volarie V5 en V8

Voor de DirectX 9.0-markt komt XGI met de Volari V5 en V8. Het verschil tussen beide GPU's zit hem in het aantal pixel- en shader pipelines waarmee ze zijn uitgerust. De V5 heeft er respectievelijk vier en twee, terwijl de V8 er acht en vier heeft. Elke pixel pipeline is uitgerust met twee texture units en daarnaast hebben beide GPU's ook nog eens twee vertex shaders. Van beide GPU's is er ook een Ultra-versie beschikbaar die op een hogere kloksnelheid werkt en ook met sneller geheugen is uitgerust. De geheugeninterface is 256bits breed en kan overweg met zowel DDR- als DDR2-geheugen.

![]() BitFluent

BitFluent

Om echter met bijvoorbeeld de nVidia GeForce FX 5900 Ultra en de ATi Radeon 9800 Pro te concurreren heeft XGI een technologie in hun Volari V5 en V8 ingebouwd die het mogelijk maakt om twee GPU's samen te laten werken, vergelijkbaar met de SLI-technologie van 3dfx. De naam van deze technologie is BitFluent. In plaats van beide GPU's tegelijkertijd dezelfde frame te laten renderen, heeft XGI ervoor gekozen om het eerst volgende frame door de host-GPU te laten renderen en het daarop volgende frame door de slave-GPU te laten renderen. De laatste is hiervoor doormiddel van de BitFluent-bridge op de host-GPU is aangesloten. Hierdoor kunnen beide GPU's met hun eigen geheugen worden uitgerust en zouden ze elkaar niet in de weg kunnen zitten, waardoor de snelheid in theorie verdubbelt.

![]() BroadBahn

BroadBahn

Om ervoor te zorgen dat de Volari GPU niet staat te wachten op gegevens uit het geheugen, is hij uitgerust met een speciale geheugeninterface die de naam BroadBahn heeft meegekregen. BroadBahn maakt gebruik van compressie om meer gegevens tussen de GPU en het geheugen te kunnen transporteren. Daarnaast is het geheugen onderverdeeld in vier verschillende banken die ieder hun eigen controller hebben. Hierdoor kan er vanuit of naar verschillende plaatsen in het geheugen tegelijkertijd data worden opgehaald of weggeschreven.

![]() CipherVideo en ColorAmp

CipherVideo en ColorAmp

Een snelle videochip is een ding, maar het oog wil natuurlijk ook wat. Dat dacht XGI ook en heeft daarvoor twee verschillende technieken ontwikkeld: CipherVideo en ColorAmp. ChipherVideo zorgt ervoor dat videobeelden die van buiten de chip komen een speciale behandeling krijgen waardoor ze er beter uit zouden moeten zien. Zo wordt onder andere het interlaced video-in signaal omgezet in een niet-interlaced signaal. ColorAmp zorgt ervoor dat bepaalde kleuren als het ware versterkt worden waardoor 3d-beelden helderder zijn en 2d-beeld iets meer verzadigd. Uiteraard is de mate en het soort van beeld dat door ColorAmp wordt bewerkt in te stellen door de gebruiker.

![]() Conclusie

Conclusie

Het lijkt erop dat XGI hard op weg is om een geduchte concurrent te worden van ATi en nVidia. Hiervoor zal XGI echter wel een naam moeten opbouwen die ze nu nog niet hebben. Als de kaarten echter presteren zoals XGI beweert met hun benchmarks, dan zou het hun kunnen lukken. Zeer zeker als de support goed is en de prijs laag.