Het een van de argumenten die Elon Musk vaak gebruikt om naar Mars te gaan. We moeten snel een multi-planetary civilization ontwikkelen om de uitsterving van de mensheid te voorkomen, vindt hij. Een beetje vanuit het idee dat het niet uitmaakt hoe klein het risico is als de mogelijk schade maar totaal is.

Dat is op zich lang geen slecht idee. Ik hoor de laatste tijd steeds vaker de theorie langskomen dat de dinosaurussen toch al op het punt stonden om uit te sterven ten tijde van Chicxulub (waardoor het niet helemaal eerlijk is om te zeggen dat ze door de inslag zijn uitgeroeid), maar dat verandert niets aan het feit dat die inslag overduidelijk heeft plaatsgevonden, dat er geen enkele reden is waarom dat niet nog een keer kan gebeuren en dat het "helemaal niet goed" zou zijn voor de mensheid als die volgende inslag komend jaar plaats zou vinden.

Daarnaast zijn er ook andere redenen om naar Mars te gaan. Juist omdat het zo ver weg is, moeten we heel zuinig omgaan met allerlei materialen; het water aan boord zal bijvoorbeeld voor 100% gezuiverd moeten worden tot drinkwater; als je "slechts" 99% haalt (en 1% moet lozen), dan moet je zo'n idiote hoeveelheid water meenemen dat je capsule simpelweg veel te zwaar wordt en we geen raket hebben die dat ding kan lanceren. Daarnaast moet de zuivering ook energie-efficiënt, want je hebt alleen zonnecellen als energievoorziening. Maar zodra dat soort technologie eenmaal bestaat, dan kunnen we die ook in alle waterzuiveringen op Aarde gebruiken, dat zou een enorme winst zijn. Dezelfde redenatie geldt ook voor bijvoorbeeld het produceren van voedsel.

Vanuit die redenering zou ook iedereen in God moeten geloven, want stel dat hij wel bestaat en jij gaat eeuwig naar de hel dan heb je totaalschade. Dat risico kun je niet lopen.

Daar heeft... ehm, telt George Carlin als "een grote filosoof"?

ooit over nagedacht en die kwam tot de conclusie dat het probleem niet zozeer is dat je niet in God gelooft, maar dat je in de verkeerde God gelooft. Er zijn nogal wat Goden en een heleboel daarvan houden niet van "concurrentie": als je in een andere God gelooft, dan ga je net zo goed naar de hel / onderwereld / whatever. Dus tenzij je net precies goed gokt ben je sowieso de sjaak.

Het probleem is alleen dat we een oneindig aantal van dat soort bedreigingen kunnen verzinnen waar we ons dan tegen zouden moeten wapenen, wat eenvoudig niet doenlijk is. Het levert ook tegenstrijdig belangen op.

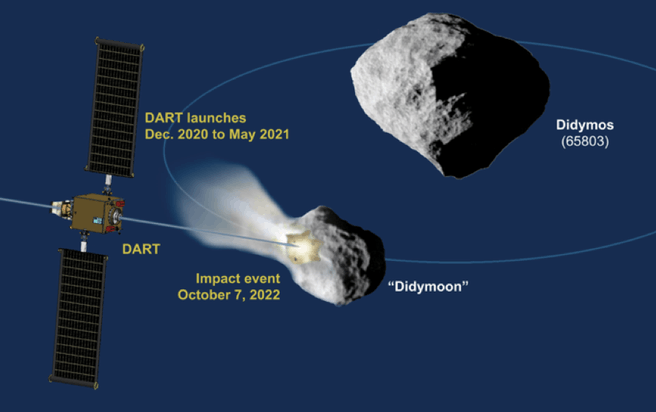

Die tegenstrijdigheden zie ik niet? Rekening houden met een epidemie van "builenpest 2.0" en proberen ons daar zo goed mogelijk op voor te bereiden is niet strijdig met het zoeken naar rotsblokken van het formaat "dino killer" die op ramkoers met de Aarde liggen en het ontwikkelen van een methode om dat te voorkomen. (Ja okee, je kunt geld maar één keer uitgeven, maar deze projecten kosten, relatief gezien, erg weinig geld en zijn nauw verwant aan ander onderzoek, waardoor de resultaten ook op andere plekken gebruikt kunnen worden, ook zonder armageddon. DART is bijvoorbeeld niet bepaald geavanceerd en het is niet alsof de Falcon ontwikkeld is alleen maar om dit ding te lanceren.)

En okee, het is inderdaad ondoenlijk om ons tegen

elk rampscenario te beschermen, maar hoe meer hoe beter toch? Lang niet alle ziektes kunnen we verslaan, maar we doen ons uiterste best om voor zoveel mogelijk ziektes een vaccin te ontwikkelen en als dat niet lukt, een geneesmiddel. Zelfs als we geen garantie hebben dat we élke inslag op tijd aan zien komen en zelfs als we geen technieken hebben om élke voorspelde inslag te voorkomen, dan nog lijkt het me een prima idee om de bedreigingen waar we

wel iets tegen kunnen doen ook inderdaad af te weren.

Voor mijn gevoel hangt het allemaal met risicoperceptie samen en die is niet rationeel, omdat we de echte risico's maar moelijk kunnen schatten en het daarom erg afhankelijk is van de hoeveelheid aandacht we er aan geven en en de mate waarin we onze geest er door in beslag laten nemen.

Van de ene kant klopt dat helemaal, maar ik ben het niet met je eens dat "we kunnen het risico niet exact uitrekenen" zou moeten betekenen "dan doen we er dus ook helemaal niets aan". Denk eraan dat we op dit moment heel weinig tijd, geld en grondstoffen (van de wereldwijde voorraad) besteden aan het zoeken naar mogelijk gevaarlijke objecten en het bouwen van verdedigingsmechanismen.

Ik denk dat aandacht voor het gevaar van komeetinslagen in diverse films geholpen hebben om deze missie mogelijk te maken.

Als films een grote rol zouden spelen, dan hadden we dit al vele jaren geleden gedaan, vlak na Armageddon en Deep Impact. We hebben recent toch geen block busters gehad over inslagen die de mensheid uit zouden roeien?

Daarbij speelt nog een rol dat enige onzekerheid over de risico's nog meer onzekerheid en angst opwekt.

Wat betreft het opwekken van angst heb ik niet het gevoel dat paniek over mogelijke inslagen echt een probleem is. Maar juist als onzekerheid over risico's voor angst zorgt, dan is de beste aanpak toch om die onzekerheid te verminderen? Stel dat NASA, ESA, JAXA, Roskosmos en co zouden kunnen zeggen "we kunnen elk object dat groot genoeg is om de mensheid uit te roeien gegarandeerd minimaal X jaar van tevoren aan zien komen en in X jaar tijd kunnen we de koers ver genoeg wijzigen dat ie de Aarde mist", dan is dat toch een stuk beter dan het huidige "we doen ons best, maar we kunnen geen enkele garantie geven over wanneer we objecten detecteren; de volgende dino killer zou morgen in kunnen slaan" in combinatie met "zelfs als we een inslag ver van te voren voorspellen, dan nog hebben we geen garantie dat we de baan genoeg aan kunnen passen, want zo'n missie hebben we zelfs nog nooit geoefend"...?

:strip_icc():strip_exif()/i/2001999883.jpeg?f=fpa_thumb)

/i/2004696860.png?f=fpa)

/i/1317819995.png?f=fpa)

/i/1241362271.png?f=fpa)

/i/1261474170.png?f=fpa)