Nvidia-kaarten met Maxwell-gpu's ondersteunen asynchronous compute niet echt, claimt de ontwikkelaar van Ashes of the Singularity. Volgens de Nvidia-driver zou de feature moeten werken, maar de prestaties bij de DX12-game zouden op het tegendeel wijzen.

Ashes of the Singularity is een recent in alpha-stadium uitgebrachte game die DirectX 12-functionaliteit ondersteunt. Bij het gebruik van een interne benchmark liep ontwikkelaar Oxide tegen een probleem in combinatie met Nvidia-kaarten op basis van de Maxwell-architectuur aan. Dit noopte de ontwikkelaars asynchronous compute, een feature waar DirectX 12 gebruik van kan maken, uit te schakelen bij gebruik van die kaarten.

Op het forum van Overclock.net claimt de ontwikkelaar dat de drivers van Nvidia melding maakten van ondersteuning van de functie. "Maar pogingen om het te gebruiken waren rampzalig wat betreft prestaties. Daarom hebben we het uitgeschakeld bij hun hardware. Voor zover ik weet heeft Maxwell geen ondersteuning voor asynchronous compute, dus ik weet niet waarom de driver dat probeerde aan te spreken." Niet bekend is of de kaarten de technologie echt niet ondersteunen, of dat het probleem bij de drivers of elders gezocht moet worden.

Nvidia legde de schuld voor de prestatieproblemen aanvankelijk bij bugs in de msaa-implementatie, maar dat ontkent Oxide. Die zouden volgens de ontwikkelaar dan evengoed in DX11-benchmarks te zien moeten zijn en het implementeren van DX12-functionaliteiten zou daar geen invloed op hebben. Volgens de Oxide-ontwikkelaar zou Nvidia ook druk hebben gezet om bepaalde instellingen in de benchmark uit te schakelen, maar welke dat zijn is niet bekend.

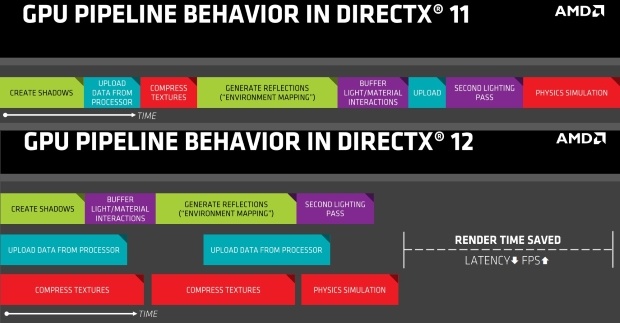

De DirectX 12-functie asynchronous compute zorgt ervoor dat multithreaded 3d-applicaties efficiënt afgehandeld worden. Er worden meerdere queues gebruikt voor bepaalde grafische rekentaken, terwijl bij DirectX 11 die taken nog één voor één, achter elkaar, afgehandeld worden. Door het gebruik van asynchronous compute kan de rekenkracht van de gpu dus beter benut worden maar er moet wel ondersteuning vanuit de hardware en de driver voor zijn.

Kaarten van zowel Nvidia als AMD ondersteunen niet alle functionaliteit van DirectX 12 maar de Graphics Core Next-architectuur van AMD kan sinds de introductie van Mantle wel overweg met asynchronous computing. Veel features van Mantle komen overeen met mogelijkheden van DirectX 12.

/i/2001211511.png?f=fpa)

:strip_exif()/i/2001092203.jpeg?f=fpa)

/i/1309767168.png?f=fpa)

/i/1365774447.png?f=fpa)

/i/1394087870.png?f=fpa)

:strip_exif()/i/1380099265.jpeg?f=fpa)

:strip_exif()/i/1295600046.gif?f=fpa)

/i/2000584654.png?f=fpa)

/i/1241443636.png?f=fpa)

:strip_exif()/i/2000575169.jpeg?f=fpa)

/i/1234873450.png?f=fpa)

/i/1369231191.png?f=fpa)