Beste game-cpu?

Intel maakt met de introductie van de Core i9-9900K de overstap naar desktopprocessors met acht cores aan boord. Daarmee volgt de Santa Clara-chipbakker concurrent AMD, dat met zijn Ryzen-processors vorig jaar al octocores voor zijn mainstreamplatform introduceerde. Intel claimt met zijn nieuwste Coffee Lake Refresh-processors de beste gameprocessors op de markt te zetten. Die belofte moeten we uiteraard nader onderzoeken.

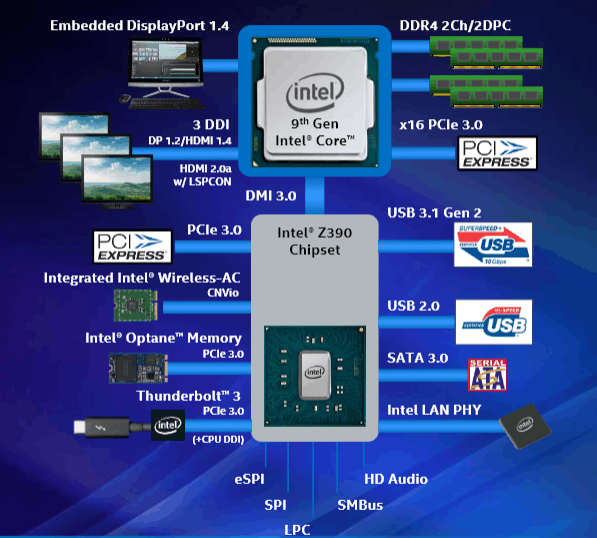

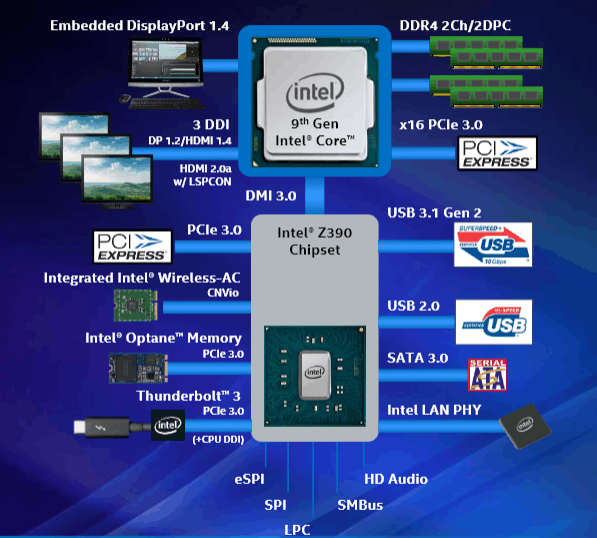

Behalve de nieuwe processors heeft Intel een nieuwe chipset uitgebracht. Dat lijkt wat overdreven na de minimale verschillen tussen de Z270- en Z370-chipsets, maar de nieuwe Z390-chipset biedt dit keer toch echt wat nieuws. Naast de prestaties van de nieuwe processors nemen we ook het bijbehorende platform onder de loep.

De adviesprijs voor het nieuwe Coffee Lake Refresh-topmodel bedraagt volgens Intel 488 dollar. In de Pricewatch kost de i9-9900K als preorder echter 649 euro. Daarmee is de processor fors duurder dan het Coffee Lake-topmodel, de i7-8700K, die ongeveer 460 euro kost. De tweede nieuwe octocore, de i7-9700K, heeft geen hyperthreading-ondersteuning, en kost als preorder 549 euro, wat zowel wat naam als wat prijs betreft meer in lijn is met de 8700K. De derde nieuweling is de i5-9600K, een hexacore zonder hyperthreading, en die kost als preorder 379 euro.

/i/2002256417.jpeg?f=imagenormal)

De processors

We hebben net al even de drie nieuwe Coffee Lake Refresh-processors de revue laten passeren. Alle drie zijn ze nog altijd gebakken op Intels 14nm-procedé, dat inmiddels al de derde variant van de node is. Net als voorgaande incrementele verbeteringen leidt het verbeterde 14nm-procedé tot een lager stroomverbruik bij gelijke prestaties of betere prestaties bij hetzelfde verbruik. In dit geval heeft Intel daarvan gebruikgemaakt door twee extra cores in dezelfde thermal envelope te proppen. Het topmodel i9-9900K heeft immers acht fysieke cores, maar wel dezelfde 95W-tdp als de hexacore i7-8700K.

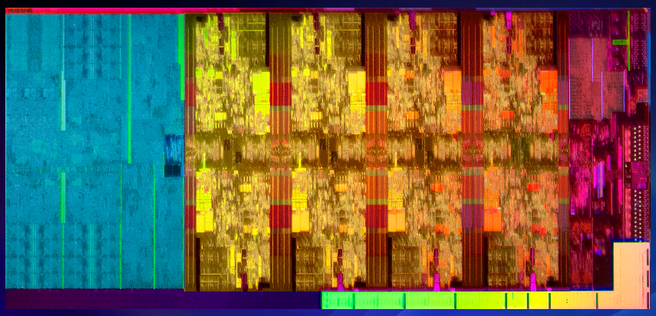

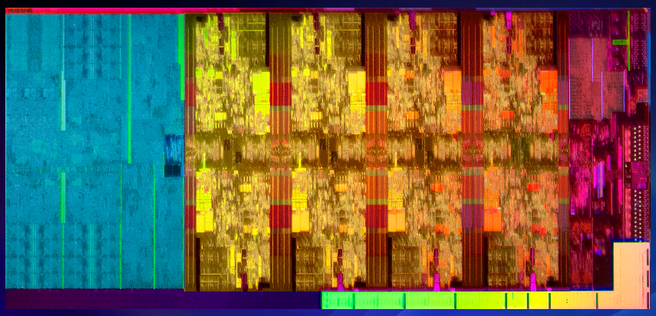

Wezenlijke veranderingen zijn er eigenlijk nauwelijks, behalve de twee extra cores. Die hebben in de 9900K natuurlijk wel de beschikking over 16MB L3-cache, aangezien elke core nog steeds 2MB L3-cache deelt met de andere cores. Net als vorige generaties processors maakt ook Coffee Lake Refresh gebruik van een ringbus voor die communicatie tussen de cores. Alleen de X-processors op het hedt-platform maken gebruik van de meshtopografie. Dat betekent dat de latencies in de nieuwe lichting lekker laag zijn, zonder de problemen die meshconfiguraties of verschillende core complexes met zich meebrengen. Ook hebben de processors aanpassingen gekregen om kwetsbaarheden als Spectre, Meltdown en Foreshadow het hoofd te bieden.

Toch zijn er twee wijzigingen aan de Coffee Lake Refresh-processors, niet zozeer in de architectuur, maar in de afwerking. De eerste is puur cosmetisch en waarschijnlijk een marketingreactie op AMD's Threadripper-verpakkingen. De verpakking van de nieuwe generatie is namelijk flink aangepakt en gemoderniseerd, met een plastic polyhedron in plaats van een simpele, rechthoekige kartonnen doos als verpakking. En over verpakking gesproken: de heatspreader is eindelijk weer aan de die gesoldeerd. Dat moet de warmte een stuk efficiënter kunnen afvoeren dan de gebruikelijke pasta die bij voorgaande generaties tussen processor en heatspreader zit, waardoor stabieler overklokken en lagere temperaturen mogelijk moeten zijn.

| Merk en productserie |

Intel Core i9 |

Intel Core i7 |

Intel Core i5 |

| Type |

9900K |

9700K |

9600K |

| Prijs |

€ 447,25 (5 winkels) |

€ 399,- (3 winkels) |

€ 229,88 (4 winkels) |

| Processortechniek |

| Socket |

1151 |

1151 |

1151 |

| Aantal cores |

8 |

8 |

6 |

| Threads |

16 |

8 |

6 |

| Klokfrequentie |

3,6GHz |

3,6GHz |

3,7GHz |

| Maximale turboklokfrequentie |

5GHz |

4,9GHz |

4,6GHz |

| Maximumgeheugengrootte |

64GB |

64GB |

64GB |

| Geheugenspecificatie |

PC4-21300 (DDR4-2666) |

PC4-21300 (DDR4-2666) |

PC4-21300 (DDR4-2666) |

| Procestechnologie |

14 nm |

14 nm |

14 nm |

| Thermal design power |

95W |

95W |

95W |

| Video |

| Geïntegreerde graphics |

Ja |

Ja |

Ja |

| Videochip |

Intel UHD Graphics 630 |

Intel UHD Graphics 630 |

Intel UHD Graphics 630 |

| Nominale snelheid videochip |

350MHz |

350MHz |

350MHz |

| Maximale snelheid videochip |

1,2GHz |

1,2GHz |

1,15GHz |

| Cache |

| Cpu-cache level 3 |

16MB |

12MB |

9MB |

| Functies |

| Hyperthreading / SMT |

Ja |

Nee |

Nee |

| Virtualisatietype |

Intel VT-d, Intel VT-x |

Intel VT-d, Intel VT-x |

Intel VT-d, Intel VT-x |

| Maximumaantal pci-e lanes |

16x |

16x |

16x |

De drie modellen die nu zijn uitgekomen, representeren ook de drie fysieke varianten van de chips of die waarin Coffee Lake Refresh verschijnt. De grootste die, met onbekende afmetingen, wordt voor de achtcore-i9-9900K gebruikt. Het middelste formaat, waarvan de afmetingen van 149mm² wel bekend zijn, bevat zes cores en vormt de basis voor de i7-9600K. De eerste lichting Coffee Lake Refresh is nog wat beperkt; Intel heeft nog maar drie processors met flinke onderlinge prijsverschillen uitgebracht. Wie tussen het huidige aanbod niets van zijn gading kan vinden, kan dus beter even wachten, want ongetwijfeld komen er later nog meer modellen om de serie compleet te maken.

Het platform: niet nieuw, wel beter

We zijn er inmiddels aan gewend dat Intel met de introductie van een nieuwe generatie processors ook een nieuw platform introduceert. Met de stap van Kaby Lake naar Coffee Lake was dat een nogal controversiële en onnodige beslissing, getuige het feit dat mensen erin slaagden Coffee Lake op een Series 100- of 200-moederbord te laten werken. Ook bij deze refresh heeft Intel een nieuwe chipset uitgebracht, wat moederbordfabrikanten de gelegenheid gaf een nieuwe reeks high-end moederborden uit te brengen. Er is echter goed nieuws; wie al een moederbord uit de Series 300-chipset in huis heeft, hoeft geen nieuw bord te kopen. Na een bios-update werken de nieuwe processors namelijk ook op de bestaande chipsets.

Wat is dan nieuw aan die nieuwe chipset? De Z390-chipset is eigenlijk een opgevoerde Z370-chipset en heeft de features aan boord die iedereen verwachtte met de Z370-pch te krijgen. Zo is er eindelijk ondersteuning voor usb 3.1 gen 2 op de chipset en is ook wifi voorbereid in de chipset. Natuurlijk is er nog altijd een fysieke module nodig die als insteekmodule voor moederborden gemaakt wordt, maar een aparte controller is niet meer nodig. En met de ondersteuning voor de snellere usb-variant in de chipset is de Z390-chipset nu op gelijke hoogte met de meer mainstream- en budgetchipsets. De H370- en B360-chipsets hadden namelijk ook al usb 3.1 gen 2-ondersteuning aan boord. De echte budgetchipset H310 heeft dat niet, en daar is nog iets mee aan de hand. Alle moderne Series 300-chipsets worden namelijk op 14nm geproduceerd. De H310-chipset krijgt echter een nieuwe versie, die op 22nm geproduceerd gaat worden, dezelfde node als de oudere Z370-chipset. Dat heeft ongetwijfeld met Intels capaciteitsproblemen op de 14nm-productielijnen te maken.

| Chipset |

Z390 |

Z370 |

H370 |

B360 |

H310 |

| Procedé |

14nm |

22nm |

14nm |

14nm |

14nm

(H310C 22nm) |

| Overklokken |

Ja |

Ja |

Nee |

Nee |

Nee |

| Usb 2.0-poorten |

14 |

14 |

14 |

12 |

10 |

| Usb 3.0-poorten |

10 |

10 |

8 |

6 |

4 |

| Usb 3.1-poorten |

6 |

0 |

4 |

4 |

0 |

| Sata-poorten |

6 |

6 |

6 |

6 |

4 |

| Geheugenslots |

4 |

4 |

4 |

4 |

2 |

| Pci-e-configs |

1 x16

2 x8

1 x8 + 2 x4 |

1 x16

2 x8

1 x8 + 2 x4 |

1 x16 |

1 x16 |

1 x16 |

| Wifi geïntegreerd |

Ja |

Nee |

Ja |

Ja |

Ja |

| Optane-ondersteuning |

Ja |

Ja |

Ja |

Ja |

Nee |

De meeste Z390-borden hebben nog een feature aan boord die niet zozeer wordt gedicteerd door de chipset, als door de processors die ze moeten huisvesten. Omdat deze high-end borden ontwikkeld zijn voor Intels snelste chips, moeten fabrikanten rekening houden met extra vermogen dat aan de processors moet kunnen worden geleverd. Intel heeft weliswaar de tdp van zijn nieuwe 9900K op een conservatieve 95W gesteld, maar Intels eerste octocore lust waarschijnlijk wel een stukje meer als je een beetje gaat overklokken. Fabrikanten houden daar rekening mee met extra pwm-fases voor de stroomvoorziening.

Dat gezegd hebbende is er natuurlijk weinig reden om je Z370-bord in te wisselen voor een Z390-bord. Alleen als je van een oudere generatie komt, is het logisch om voor de nieuwste chipset te kiezen, ook als je er een 'oude' Coffee Lake-processor als de 8700K in stopt.

Testmethode

We hebben de i9-9900K en i7-9700K fysiek in huis gehaald om te testen, waarbij alleen de 9900K door Intel werd gesampled. Bij gebrek aan een 9600K hebben we die gesimuleerd door twee cores van de 9700K uit te schakelen en de multipliers handmatig correct in te stellen. Hoewel dat ons inziens een goede indicatie van de prestaties geeft, nemen we de '9600K' niet mee in de bespreking van de resultaten.

We hebben onze reeks benchmarks gemoderniseerd om het dagelijks gebruik beter te benaderen. We hebben wel een aantal synthetische tests behouden, waaronder bijna vanzelfsprekend Cinebench, maar de overige benchmarks zijn grotendeels geüpdatet. Van alle software hebben we de nieuwste versies gebruikt en ook Windows is naar de laatste release geüpdatet.

| Platform |

AM4 - Ryzen 2 |

Lga1151 |

| Processors |

2700X, 2600X |

9900K, 9700K, 9600K

8700K,8600K |

| Moederbord |

Asus Crosshair VII Hero |

Asus Maximus VII Ranger |

| Geheugen |

16GB Ddr4-2933 |

16GB Ddr4-2667 |

| Videokaart |

Nvidia GeForce GTX 1080 Ti |

Nvidia GeForce GTX 1080 Ti |

| Koeling |

Cooler Master MasterLiquid Lite 120 |

Cooler Master MasterLiquid Lite 120 |

| Ssd |

Samsung 850 Evo 500GB |

Samsung 850 Evo 500GB |

| Besturingssysteem |

Windows 10 x64 v1709 |

Windows 10 x64 v1709 |

| Voeding |

Seasonic Prime Titanium 650W |

Seasonic Prime Titanium 650W |

De synthetische benchmark bestaat uit het eerder genoemde Cinebench, nog altijd versie R15. Daarnaast draaien we Geekbench, dat wordt opgedeeld in een multithreaded- en een singlethreaded-prestatie-index, waarbij we de singlethreaded-prestaties ook uitsplitsen in de deelbenchmarks. Dat zijn een integerbenchmark, met onder meer compressie- en html-parsedeeltests, een floating-pointbenchmark, met onder meer gaussian blur en raytracing, en een cryptografiebenchmark, waarmee de aes-engine van de processor wordt getest. De derde synthetische benchmark is Aida64, waarbij we de hash-, Julia-, Mandel- en Zlib-resultaten weergeven.

| Synthetisch |

Praktijk |

Games |

|

Cinebench R15

- singlethreaded

- multithreaded

|

Word

|

DX12 |

|

Geekbench

- Integer

- floating point

- crypto

|

Excel

|

Rise of the Tomb Raider

|

|

Aida64

|

Chrome 67

|

The Division

|

|

Opgenomen vermogen

- Idle (desktop, 5min)

- Load Cinebench

- Load Premiere

|

Staxrip

|

DX11

|

| |

Adobe

- Photoshop foto-edit

- Photoshop panorama

- Lightroom export

- Premiere 4k-export

|

Far Cry 5

|

| |

Blender

|

GTA 5

|

| |

Compressie

- 7-zip 4GB compressie

- Winrar 4GB compressie

|

Assassin’s Creed: Origins

|

| |

|

The Witcher 3: Blood and Wine

|

De praktijkbenchmarks bestaan uit zwaarder gebruik als foto- en videobewerking, en licht gebruik als office en browsing. Voor het lichte gebruik draaien we een pdf-export in Word, een Monte Carlo-test in Excel en de Jetstream-benchmark in Chrome. Voor videorendering testen we Staxrip met zowel de h264- als de h265-codec en Premiere Pro met een 4k-video-export. Van Adobe draaien we ook twee Photoshop-tests: een aantal uitgebreide bewerkingen van een enkele foto en het samenvoegen van vier foto's tot een panorama. Ook draaien we Lightroom met een export van dertig rawfoto's naar jpeg. Ten slotte hebben we een groep die het midden houdt tussen een synthetische en een realworldbenchmark: een 3d-rendertest met Blender en compressietests met 7-zip en Winrar.

Uiteraard hebben we ook weer games getest, waarbij we de resolutie op 1080p hebben gehouden om videokaartbottlenecks te voorkomen en vooral de cpu-prestaties in kaart te brengen. Games testen we waar mogelijk met hun ingebouwde benchmarktool, op een medium- en een ultra-preset. We hebben de games opgedeeld in dx11- en dx12-games. In de laatste categorie hebben we Rise of the Tomb Raider en The Division. De overige games, Far Cry 5, Assassin’s Creed: Origins, The Witcher 3: Blood and Wine en GTA V, draaien we in DX11.

Ten slotte meten we het opgenomen vermogen van de processors. Dat doen we idle, over een gemiddelde van vijf minuten, en tijdens twee belastingen, van Premiere en Cinebench. Bij die drie tests meten we het vermogen direct van de processor. Daarnaast meten we het opgenomen vermogen van het totale systeem.

Synthetische benchmarks

We combineren de synthetische benchmark Cinebench, waarschijnlijk de bekendste en meestgebruikte test voor processors, met de Blender-test. Beide renderen een afbeelding, waarbij Cinebench dat eerst op een en dan op alle cores doet. Blender gebruikt alle cores.

- Cinebench R15 1T

- Cinebench R15 nT

- Blender 2.78c

De singlethreaded-Cinebench-test laat geen verschil zien tussen de 9900K en de 9700K, hoewel er 100MHz verschil in turbokloksnelheid tussen de twee modellen zit en dat in deze test zichtbaar zou moeten zijn. In de multithreaded-test zien we de extra cores van de 9900K aan het werk en dankzij de hogere kloks is de Intel-octocore ruim tien procent sneller dan de AMD-octocore. Ook in Blender is Intels 9900K de snelste, maar de marge is iets kleiner.

- Aida64 Zlib

- - AES

- - Hash

- - VP8

- - Julia

- - Mandel

In sommige tests is Intel veel sneller dan AMD, zoals in de compressietest Zlib en de floating-pointbenchmarks Julia en Mandel. AMD is in versleutelingsbenchmarks als hash en aes weer veel sneller. We kijken dan ook vooral naar de verschillen van Intel-processors onderling en zien dat de 9900K veel sneller is dan de 9700K in compressietest Zlib en transcodetest VP8, maar in de overige benchmarks nauwelijks.

- Geekbench - multicore

- - singlecore

- - integer

- - fp

- - crypto

We gaan verder met Geekbench, waar AMD-processors een groot voordeel in de crypto-benchmark hebben, maar Intel in de overige tests de overhand heeft. De extra cores van de 9900K zijn in de multithreaded-test maar goed voor acht procent hogere prestaties en in de overige tests is het verschil tussen de hexa- en octocore gering.

Praktijktests

Hoewel iedere tweaker waarschijnlijk ten minste één keer Cinebench zal draaien op zijn fonkelnieuwe systeem, koop je je processor uiteraard niet om er alleen synthetische tests op te draaien. Daarom kijken we hoe de processors zich verhouden in een aantal praktijktests, waarbij we realistische scenario's benchmarken.

- Lightroom CC export

- Photoshop fotobewerking

- Photoshop panorama

We beginnen met twee Adobe-tests die relevant zijn voor iedereen die weleens een foto met een digitale camera of telefoon heeft geschoten en bewerkt. Dertig foto's exporteren met Lightroom kost je tien procent minder tijd op Intels octoacore dan op AMD's 2700X. Gek genoeg is de 9900K trager dan de 9700K, wat vermoedelijk een oorzaak heeft in hoe Lightroom met hyperthreading omgaat. Toen we hyperthreading in de 9900K uitschakelden, kregen we dan ook dezelfde score als die van de 9700K: 59 seconden.

In Photoshop zien we prestaties zoals we die verwachten; Intels octocore is de snelste, gevolgd door de hexacore. In de panorama-stitch profiteer je meer van kloksnelheid dan van extra cores.

- Word pdf-export

- Excel Monte Carlo

- Chrome Jetstream

De pdf-export in Word wordt niet veel sneller met de extra twee cores en hyperthreading van de 9900K tegenover de 9700K; het is meer de kloksnelheid die telt. De Monte Carlo-berekening in Excel is wel iets sneller met de 9900K, en het verschil tussen die twee processors in browserbenchmark Jetstream is vergelijkbaar.

- Premiere 4k

- Staxrip x264

- Staxrip x265

Ook in Premiere scoren de twee Coffee Lake Refresh-processors nagenoeg identiek; hyperthreading wordt ogenschijnlijk niet benut. De 9700K is in Staxrip met de x264-codec bijna even snel als AMD's 2700X en met de h265-codec zijn beide Coffee Lake Refresh-processors sneller dan AMD's octocore.

Het inpakken van 4GB met Winrar is op Intels processors sneller dan op de AMD-processor. Winrar kan wel overweg met hyperthreading en redelijk wat cores, getuige de betere prestaties van de 8700K met zes cores en twaalf threads, die een stuk beter presteren dan de acht cores en acht threads van de 9700K.

In 7-zip lijkt het veel meer de kloksnelheid die de prestaties dicteert, dus als je daarmee gaat inpakken, kun je beter voor een flinke turbo zorgen.

Gamebenchmarks

Intel prees de Coffee Lake Refresh-processors aan als de beste processors voor gaming. Zoals gebruikelijk hebben we onze gamebenchmarks dan ook gedraaid op de processors, waarbij een Nvidia GTX 1080 Ti een eventuele gpu-bottleneck moet voorkomen. Dat is ook de reden om de games op de relatief lage resolutie van 1920×1080 pixels te draaien. Op die resolutie draaien we de games op Medium- en Ultra-presets.

- Rot Tomb Raider Medium

- Rot TR Medium 99p

- Rot TR Ultra

- Rot TR Ultra 99p

In Tomb Raider zijn de nieuwe processors iets sneller dan de oude, maar een wereld van verschil maakt het niet. Op de Ultra-instelling zijn de niet-hyperthreading-processors iets sneller.

- The Division (DX12) - Medium

- The Division (DX12) - Ultra

De 8700K presteert in onze Division-benchmark beter dan de nieuwe processors en in de Ultra-settings is zelfs de 2700X sneller, ondanks zijn lagere kloksnelheden.

- Far Cry 5 Medium

- Far Cry 5 Ultra

In Far Cry 5 zien we wel min of meer de volgorde die we verwachten, hoewel hyperthreading ook nu weer weinig profijt biedt. Los daarvan zijn de winsten van de nieuwe processors gering.

- AC: Origins medium

- AC: Origins ultra

In Origins zien we eindelijk de 9900K bovenaan het lijstje, gevolgd door de 9700K. Ook in de Ultra-preset zijn de nieuwe processors sneller, hoewel de winst daar kleiner is.

- Witcher 3 1080p Medium

- - 1080p Medium 99p

- - 1080p Ultra

- - 1080p Ultra 99p

Op de Medium-preset zijn de nieuwe processors de snelste, maar op de Ultra-instelling zien we toch weer de 8700K die de rest nipt voorblijft. Als we overigens naar de frametimes kijken, is de 8600K veruit de snelste.

- GTA V Medium

- GTA V Medium (99p)

- GTA V Ultra

- GTA V Ultra (99p)

GTA 5 is een behoorlijk cpu-gelimiteerde game en hier zien we, dankzij de hogere kloksnelheden, winst voor de Refresh-generatie. Je wint een procent of zeven, acht met een negende-generatieprocessor.

Overklokken en opgenomen vermogen

Intel heeft de 9900K en 9700K van twee extra cores voorzien, maar de opgegeven tdp is onveranderd gebleven vergeleken met de 8700K, een hexacore van de vorige generatie. We meten het opgenomen vermogen van de processors door de 12V-voedingslijnen af te tappen, zodat we niet het complete systeem, maar alleen de processor meten.

- Opgenomen vermogen, idle

- Opg. verm, load Premiere

- Opg. verm, load Cinebench

Idle ontlopen de processors elkaar niet veel. Die ene watt verschil tussen de Coffee Lake-processors idle is nauwelijks meetbaar.

Onder belasting van Cinebench zien we dat de twee extra cores van de 9900K en 9700K wel degelijk meer vermogen vergen dan de 8700K. De 9700K zonder hyperthreading vraagt een kwart meer in Cinebench en de 9900K met hyperthreading vraagt zelfs 138 in plaats van 95W. Tijdens het renderen in Premiere is de vraag naar energie wat lager, maar nog steeds lusten de octocores aanzienlijk meer dan de hexacores. Intels 9900K is zelfs minder energiezuinig dan AMD's 2700X, terwijl AMD altijd bekendstond om zijn grotere vraag naar vermogen.

Ipc

We kijken als extra test nog even naar de ipc-prestaties, de instructies per clock dus. Om dat met een groot aantal processors vergelijkbaar te houden, klokken we de processors daarvoor op 2,4GHz en draaien Cinebench R15.

| Cpu-architectuur |

CFL-R |

CFL |

KBL |

Ryzen 2 |

| Cinebench R15 1T-score |

104 |

105 |

104 |

101 |

| Verschil Coffee Lake Refresh |

0% |

1% |

0% |

-3% |

De Coffee Lake- en Kaby Lake-varianten zijn in beginsel allemaal van dezelfde architectuur en we zien ook geen echt verschil, ondanks het puntje lager van de Coffee Lake Refresh-test. AMD zit met zijn nieuwste Ryzen-processors bijzonder dicht op Intels klok-voor-klokprestaties.

Overklokken

We hebben de i9-9900K overgeklokt tot Cinebench niet meer stabiel draaide. We kwamen met behulp van een Asus Maximus XI Gene en NZXT's Kraken X62-koeler tot 5200MHz, ongeveer hetzelfde als met alle processors met deze architectuur. Dat leverde een Cinebench-score van 2198 punten op.

Belangrijker zijn de spanning en temperatuur die we daarbij nodig hadden, danwel gemeten hebben. De spanning om de cpu stabiel te houden, bedroeg 1,285V, terwijl we voor de 8700K 1,36V nodig hadden voor dezelfde overklok.

De temperaturen van de 9900K lopen op tot gemiddeld 82 graden met de X62. We hebben de beide processors ook met onze custom loop cooler met 480mm-radiator getest en de temperaturen gemeten. De cores van 8700K worden met die koeler gemiddeld 78 graden op 5200MHz en de 9900K wordt dan 80 graden. De twee extra cores leveren dus 2 graden extra op, terwijl de processor tijdens de overklok bijna 200W verstookt.

Om de temperaturen iets beter in kaart te brengen, hebben we op het Asus Maximus XI Extreme-bord de 8700K en 9900K zowel stock als overgeklokt op 5,2GHz gedraaid. De overklok is bij beide processors met een Vcore van 1,3V gerealiseerd, zodat daar geen onderlinge verschillen aan te wijten zijn. De koeling bestond bij deze tests uit de NZXT Kraken X62, een waterkoelsetje met een 280mm-radiator. Het geheugen werd voor de overkloks op 4000MT/s gezet, stock op 2667MT/s. Om de processors lekker warm te krijgen draaien we vijf Cinebench-runs achter elkaar.

| Processor |

Temperatuur |

Max vermogen (systeem) |

Max vermogen (package) |

| 8700K stock |

67 |

154W |

88W |

| 8700K @ 5,2GHz |

95 |

235W |

143W |

| 9900K stock |

64 |

196W |

138W |

| 9900K @ 5,2GHz |

84 |

292W |

187W |

Stock is de 9900K enkele graden koeler, maar overgeklokt met dezelfde spanning is de 8700K toch een stuk warmer. De 9900K blijft zo'n 84 graden, tien graden koeler dus, terwijl toch een dikke 40W meer vermogen gevraagd wordt. Overigens liggen de temperaturen in deze test wat hoger dan in bovenstaande resultaten, waar maar één Cinebench-run werd gedraaid. Met vijf runs warmen de processors meer op. Een interessant detail is het opgenomen vermogen van de stock-processors. De 8700K blijft netjes binnen zijn tdp van 95W, maar de 9900K zit daar met 138W stock tijdens Cinebench ver boven.

Conclusie: 14nm maximaal opgerekt

Intel heeft met zijn refresh van de Coffee Lake-generatie weer even wat ademruimte gecreëerd in afwachting van succes met de 10nm-generatie. Eigenlijk is Coffee Lake Refresh nog steeds een opgepoetste Skylake-processor, maar dan wel met flink verbeterde transistors. En we mogen ook de ingebouwde, hardwarematige bescherming tegen kwetsbaarheden als de diverse Spectre- en Meltdown-varianten niet wegvlakken.

Omdat de Coffee Lake Refresh-processors, met de eerste lichting in de vorm van de i9-9900K, de i7-9700K en de i5-9600K, van zwaar geoptimaliseerde 14nm-processors gebruikmaken, kan Intel de kloksnelheden nog iets verder opschroeven zonder de tdp al te zeer op te rekken. Dat resulteert in een mainstreamprocessor die de 5GHz op de turbostand met een of twee cores kan aantikken. De jubileumprocessor 8086K kon dat weliswaar ook al, maar dat betrof een beperkte oplage met bijbehorende meerprijs.

Dat wil niet zeggen dat je voor acht cores en zestien threads, een punt waar AMD met zijn Ryzen-processors overigens vorig jaar al was aangeland, niet flink in de buidel moet tasten. De 9900K kost in het gunstigste geval 488 dollar, terwijl zijn voorganger, de 8700K, 359 dollar kost. Als je die vergelijking niet eerlijk vindt, rekenen we met de 9700K versus de 8700K en dan kost die eerste nog altijd 374 dollar. Op papier maar iets meer, maar daar lever je dan wel hyperthreading voor in. Bovendien: de prijs die Intel hanteert, is niet de prijs die je betaalt. Door de schaarste aan 14nm-productie betaal je inmiddels voor de 8700K een kleine 500 euro, en de 9900K en 9700K staan voor respectievelijk 650 en 550 euro in de preorder. Voor AMD's concurrenten als de 2600X en 2700X betaal je ongeveer 220 en 320 euro. Dat is de helft van het geld, maar daarvoor lever je tien tot twintig procent prestaties in. Het is maar net waar je prioriteiten liggen.

Het geeft overigens wel te denken, want Intel zit inmiddels op ongeveer gelijke core count met AMD, en de ipc-prestaties zijn aardig naar elkaar toegetrokken. Intels grote voordeel is de hogere kloksnelheid van zijn processors, maar als AMD overstapt naar 7nm-Zen2-cores, wordt dat een interessant gevecht in 2019. We hopen dat AMD in ieder geval voor zijn mainstreamplatform AM4 niet voor hogere aantallen cores en threads kiest, want zoals je aan de meeste praktijktests en games kunt zien, profiteert lang niet alle software daarvan. Sterker, je kunt in veel gevallen misschien beter hyperthreading uitschakelen of de 9700K in plaats van de 9900K kopen.

Hoe het ook zij, Intel heeft voor de gewone desktopmarkt de prestatiekroon nog altijd stevig in handen en met een nieuwe Z390-chipset die de Z370-vergissing moet doen vergeten, staat er een prima, maar behoorlijk prijzig platform voor de veeleisende gebruiker en gamer.

- Intel Core i7-9700K

- Intel Core i9-9900K

/i/2002256417.jpeg?f=imagenormal)

/i/2002256311.png?f=imagemedium)

/i/2002256313.png?f=imagemedium)

/i/2002256327.png?f=imagemedium)

/i/2002256323.png?f=imagemedium)

:strip_exif()/i/2002238997.gif?f=thumbmedium)

:strip_exif()/i/2002238587.png?f=thumbmedium)

:strip_icc():strip_exif()/i/2003191210.jpeg?f=fpa_thumb)

:strip_icc():strip_exif()/i/2002395970.jpeg?f=fpa_thumb)

/u/468821/crop594848c6b86e5.png?f=community)

:strip_icc():strip_exif()/u/434930/crop5b9567e2e994b_cropped.jpeg?f=community)

:strip_icc():strip_exif()/i/2002066185.jpeg?f=fpa_thumb)

:strip_icc():strip_exif()/i/2001941433.jpeg?f=fpa_thumb)

:strip_icc():strip_exif()/i/2001673545.jpeg?f=fpa_thumb)

/i/2002173217.png?f=fpa)

/i/1370069782.png?f=fpa)

/i/2001665377.png?f=fpa)